>[success] ## **Analyzer(分詞器)的作用是把一段文本中的詞按一定規則進行切分**

> **分詞器的一般工作流程:**

> 1、切分關鍵詞

> 2、對于英文單詞,把所有字母轉為小寫(搜索時不區分大小寫)

## **一、下載ik分詞器**

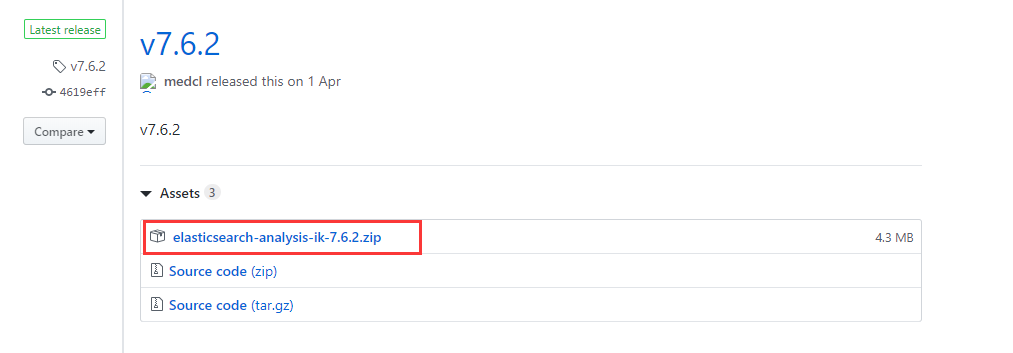

不同的es有不同的ik版本對應,可在`releases`找到對應的版本,直接下載zip文件即可。

下載地址:[https://github.com/medcl/elasticsearch-analysis-ik/releases](https://github.com/medcl/elasticsearch-analysis-ik/releases)?,這里你需要根據你的Es的版本來下載對應版本的IK,這里我使用的是7.6.2的ES,所以就下載ik-7.6.2.zip的文件。

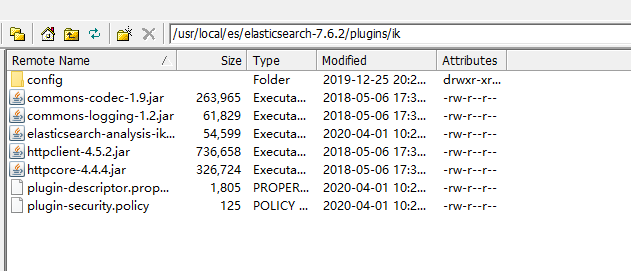

## **二、解壓-->將文件復制到 es的安裝目錄/plugins/ik目錄**

## **三、重啟ElasticSearch,測試效果**

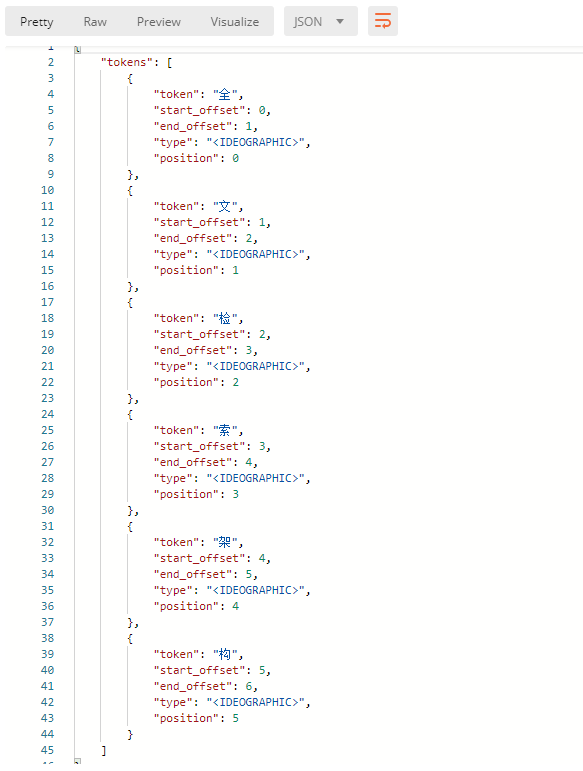

未使用ik分詞器的時候測試分詞效果:

```

POST http://IP:9200/shop/_analyze

{

"text": "全文檢索架構"

}

```

結果如下:

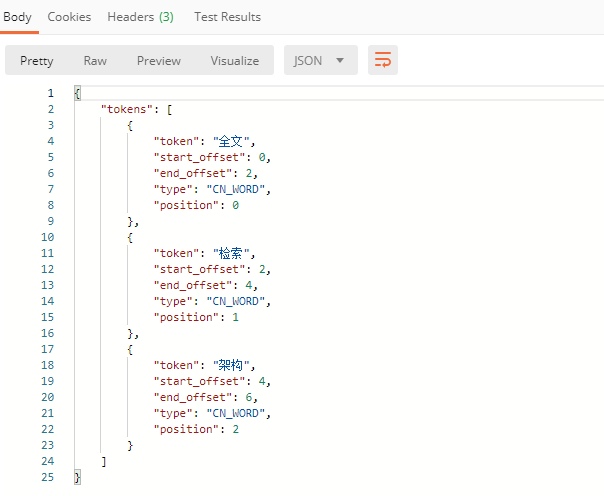

使用IK分詞器之后,結果如下:

```

POST http://IP:9200/shop/_analyze

{

"analyzer": "ik_max_word",

"text": "全文檢索架構"

}

```

結果如下:

>[danger] ## **注意**

1. 如果未安裝ik分詞器,那么你寫?"analyzer": "ik_max_word",程序就會報錯,因為你沒有安裝ik分詞器

2. 如果你安裝了ik分詞器之后,你不指定分詞器,不加上 ?"analyzer": "ik_max_word" 這句話,那么其分詞效果跟你沒有安裝ik分詞器是一致的,也是分詞成每個漢字。

- 前言

- ElasticSearch7.6.2 安裝

- Elasticsearch7.6.2 Postman操作總結

- Elasticsearch配置IK中文分詞器

- IK中文分詞器模式詳解及最佳實踐

- IK自定義詞庫及遠程熱更新

- ElasticSearch7.6.2 設置用戶認證

- Elasticsearch-head插件

- Elasticsearch SSL證書的生成及使用

- ElasticSearch 集群搭建

- Kibana開源分析及管理可視化

- Logstash 收集、解析和轉換日志

- Logstash 簡介與安裝

- Logstash 采集、過濾、分析日志數據

- MySQL8 數據增量同步到ElasticSearch

- Logstash 采集、過濾MySQL8單表全量數據

- MySQL8 單表數據增量同步ES

- MySQL8 多表數據增量同步ES

- Elasticsearch7.6.2 查詢總結

- 結構化檢索

- 精確值檢索

- 范圍檢索

- 前綴檢索

- 通配符檢索

- Ids檢索

- 全文檢索

- 匹配檢索

- 多字段匹配檢索

- Elasticsearch7.6.2 TP6使用詳解

- 創建索引

- 創建映射

- 添加文檔

- 查詢文檔: 條件查詢、復合查詢

- 高亮查詢

- 更新文檔

- 刪除文檔

- 查詢映射

- 刪除索引

- 安裝軟件、源代碼下載

- 解壓密碼