## **1、實戰問題**

最近社區里有多個關于區分大小寫的問題:

問題1:ES查詢和聚合怎么設置不區分大小寫呢?

問題2:ES7.6 如何實現模糊查詢不區分大小寫? 主要是如何進行分詞和mapping的一些設置來實現這個效果,

自己也嘗試過對setting 和 mapping字段進行設置,都是報錯比較著急,

類似的問題,既然有很多同學問到,那么咱們就有必要梳理出完整的思路和方案。

這或許是銘毅天下公眾號的使命所在。

這個問題不復雜,所以本文會言簡意賅,直擊要害!

## **2、問題拆解**

### **2.1 拆解一:如果默認分詞方式,能區分大小寫的嗎?**

是的,默認分詞器是Standard 標準分詞器,是不區分大小寫的。

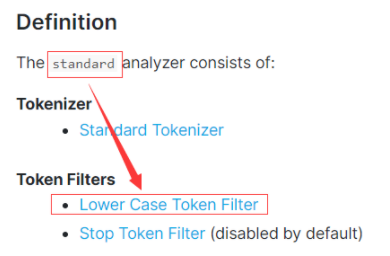

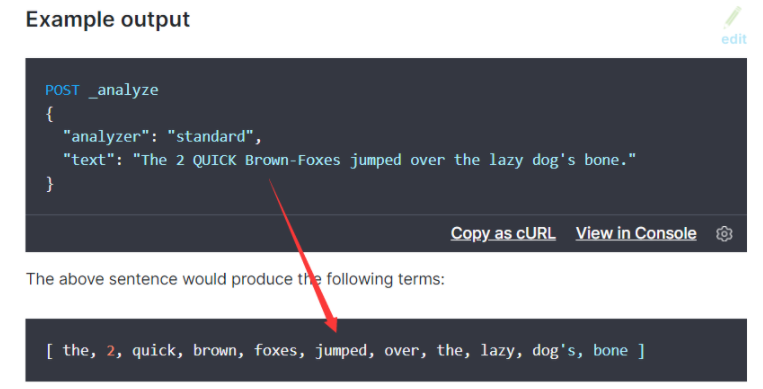

官方文檔原理部分:

如下的兩張圖很直觀的說明了:標準分詞器的 Token filters 核心組成是:Lower Case Token Filter。

什么意思呢?大寫的英文字符會轉換成小寫。

### **2.2 拆解二:實踐 Demo 驗證**

```

~~~javascript

DELETE test_003

PUT test_003

{

"mappings": {

"properties": {

"title":{

"type":"text",

"analyzer": "standard"

},

"keyword":{

"type":"keyword"

}

}

}

}

POST test_003/_bulk

{"index":{"_id":1}}

{ "city": "New York"}

{"index":{"_id":2}}

{ "city": "new York"}

{"index":{"_id":3}}

{ "city": "New york"}

{"index":{"_id":4}}

{ "city": "NEW YORK"}

{"index":{"_id":5}}

{ "city": "Seattle"}

POST test_003/_analyze

{

"text": "New york",

"analyzer": "standard"

}

POST test_003/_search

{

"query": {

"match_phrase":{

"city":"new york"

}

}

}

~~~

```

match\_phrase 檢索返回結果非常明確:\_id = 1,2,3,4 的數據都被召回。

這里初步結論是:standard 標準默認分詞器可以實現區分大小寫。

但是,我們再看一下聚合呢?

```

~~~javascript

GET test_003/_search

{

"size": 0,

"aggs": {

"cities": {

"terms": {

"field": "city.keyword"

}

}

}

}

~~~

```

返回結果如下:

```

~~~javascript

"aggregations" : {

"cities" : {

"doc_count_error_upper_bound" : 0,

"sum_other_doc_count" : 0,

"buckets" : [

{

"key" : "NEW YORK",

"doc_count" : 1

},

{

"key" : "New York",

"doc_count" : 1

},

{

"key" : "New york",

"doc_count" : 1

},

{

"key" : "Seattle",

"doc_count" : 1

},

{

"key" : "new York",

"doc_count" : 1

}

]

}

}

~~~

```

這里最核心的是:

* Mapping 設置是:multi-fields。

* 聚合走的是 keyword 類型了,不涉及分詞器:standard 了。

既然提到了 keyword, 我們進一步看:

```

~~~javascript

POST test_003/_search

{

"query": {

"term":{

"city.keyword":"new york"

}

}

}

~~~

```

執行精準匹配后,召回結果為空。

怎么解釋呢?keyword 類型屬于精準匹配,也就是說:單純的keyword 類型沒法實現大小寫區分。

進一步小結:

我們上面的組合multi-field 方式,并沒有解決檢索和聚合區分大小寫的問題?

multi-field 都搞不定,那還有招嗎?別急,我們慢慢來......

這時候得思考:需要在 Mapping 階段做文章了。

核心原理:把所有都轉為小寫,寫入時候設置 Mapping——設置filter過濾:小寫過濾。

這個是一個我們過往文章沒有提及的知識點 normalizer,希望你把它看完并掌握。

## **3、解決方案**

先給出實現,后面講原理。

```

~~~javascript

PUT caseinsensitive

{

"settings": {

"analysis": {

"normalizer": {

"lowercase_normalizer": {

"type": "custom",

"char_filter": [],

"filter": [

"lowercase"

]

}

}

}

},

"mappings": {

"properties": {

"city": {

"type": "keyword",

"normalizer": "lowercase_normalizer"

}

}

}

}

POST caseinsensitive/_bulk

{"index":{"_id":1}}

{ "city": "New York"}

{"index":{"_id":2}}

{ "city": "new York"}

{"index":{"_id":3}}

{ "city": "New york"}

{"index":{"_id":4}}

{ "city": "NEW YORK"}

{"index":{"_id":5}}

{ "city": "Seattle"}

GET caseinsensitive/_search

{

"query": {

"bool": {

"filter": {

"term": {

"city": "NEW YORK"

}

}

}

}

}

~~~

```

此時的檢索返回結果是:\_id = 1,2,3,4 文檔都被召回。

注意,我們使用了 terms 檢索。

```

~~~javascript

GET caseinsensitive/_search

{

"size": 0,

"aggs": {

"cities": {

"terms": {

"field": "city"

}

}

}

}

~~~

```

返回結果是:

```

~~~javascript

"aggregations" : {

"cities" : {

"doc_count_error_upper_bound" : 0,

"sum_other_doc_count" : 0,

"buckets" : [

{

"key" : "new york",

"doc_count" : 4

},

{

"key" : "seattle",

"doc_count" : 1

}

]

}

}

~~~

```

以上 new york 4種不同大小寫的全都聚合到了一起,這是我們期望的結果。

## **4、解決方案的原理解讀**

核心的核心是我們使用了:normalizer。

這個概念咱們之前分詞的文章都沒有提及,這里要普及一下。

官方解讀如下:

* The normalizer property of keyword fields is similar to analyzer except that it guarantees that the analysis chain produces a single token.

* The normalizer is applied prior to indexing the keyword, as well as at search-time when the keyword field is searched via a query parser such as the match query or via a term-level query such as the term query.

核心點如下:

* 第一:normalizer是 keyword的一個屬性,類似 analyzer分詞器的功能,不同的地方在于:可以對 keyword生成的單一 Term再做進一步的處理。

* 第二:normalizer 在 keyword 類型數據索引化之前被使用,同時在 match 或者 term 類型檢索階段也能被使用。

剛才提及的進一步處理,反映到我們的解決方案上:就是可以做小寫 lowercase 轉換。

由于寫入階段和檢索階段:normalizer 都生效,所以就實現了我們想要的不區分大小寫的結果。

## **5、小結**

如果官方文檔熟悉,我們的示例,實際就是官方文檔:normalizer 的舉例。

中間的 filter 我們設置了小寫,當然也可以有其他的設置,需要結合業務場景靈活使用。

歡迎大家留言說一下類似問題的其他不同實現方案。

和你一起,死磕 Elasticsearch!

- php開發

- 常用技巧

- 字符數組對象

- php換行替換,PHP替換回車換行符的三種方法

- PHP 數組轉字符串,與字符串轉數組

- php將img中的寬高刪除,PHP刪除HTML中寬高樣式的詳解

- php去除換行(回車換行)的三種方法

- php 過濾word 樣式

- php如何設置隨機數

- 2個比較經典的PHP加密解密函數分享

- php怎么去除小數點后多余的0

- php中判斷是一維數組還是二維數組的解決方案

- php 獲取數組中出現次數最多的值(重復最多的值)與出現的次數

- PHP過濾掉換行符、特殊空格、制表符等

- PHP中json_endoce轉義反斜杠的問題

- PHP過濾Emoji表情和特殊符號的方法

- PHP完美的提取鏈接正則

- php很牛的圖片采集

- 日期處理

- php 獲取今日、昨日、上周、本月的起始時間戳和結束時間戳的方法非常簡單

- PHP指定時間戳/日期加一天,一年,一周,一月

- 使用php 獲取時間今天明天昨天時間戳的詳解

- php獲得當月的節假日函數(包含周末,年度節假日)

- PHP獲取本月起始和截止時間戳

- php 獲取每月開始結束時間,php 獲取指定月份的開始結束時間戳

- PHP獲取今天,昨天,本月,上個月,本年 起始時間戳

- php、mysql查詢當天,本周,本月的用法

- php獲取兩個時間戳之間相隔多少天多少小時多少分多少秒

- 毫秒級時間戳和日期格式轉換

- php-倒計時

- 請求提交上傳

- php+put+post,Curl和PHP-如何通過PUT,POST,GET通過curl傳遞json

- PHP put提交和獲取數據

- PHP curl put方式上傳文件

- 數據導入導出

- PHP快速導入大量數據到數據庫的方法

- PHP快速導出百萬級數據到CSV或者EXCEL文件

- PHP解析大型Excel表格的庫:box/spout

- PHP導入(百萬級)Excel表格數據

- PHP如何切割excel大文件

- 使用 PHP_XLSXWriter 代替 PHPExcel 10W+ 數據秒級導出

- 安裝php擴展XLSXWriter

- 解決php導入excel表格時獲取日期變成浮點數的方法

- xml處理

- PHP XML和數組互相轉換

- php解析xml字符串

- php 生成vcf通訊錄

- 文件操作相關

- php獲取文件后綴的9種方法

- PHP判斷遠程文件是否存在

- PHP獲取文件修改時間,訪問時間,inode修改時間

- php獲取遠程文件大小教程

- php 讀取文件并以文件方式下載

- php 把數字轉化為大寫中文

- 請求響應

- PHP 獲取當前訪問的URL

- 壓縮

- php生成zip壓縮包

- PHPMailer

- 整理PHPMailer 發送郵件 郵件內容為html 可以添加多個附件等

- 通達oa

- OA管理員密碼忘了怎么辦,這里教你分分鐘搞定…

- 跨域

- php解決多站點跨域

- php設置samesite cookie,有效防止CSRF

- Chrome 配置samesite=none方式

- Cookie 的 SameSite 屬性

- 圖片

- php pdf首頁截圖,PHP_PHP中使用Imagick讀取pdf并生成png縮略圖實例,pdf生成png首頁縮略圖

- PHP -- 七牛云 在線視頻 獲取某一幀作為封面圖

- PHP圖片壓縮方法

- 如何解決PHP curl或file_get_contents下載圖片損壞或無法打開的問題

- php遠程下載文章中圖片并保存源文件名不變

- 詳解PHP如何下載采集圖片到本地(附代碼實例)

- php如何將webp格式圖片轉為jpeg

- PHP獲取遠程圖片的寬高和體積大小

- php 軟件版本號比較

- 使用PHP通過SMTP發送電郵

- 常用正則表達式

- php如何用正則表達式匹配中文

- 用于分割字符串的 PHP preg_match_all 正則表達式

- 性能優化

- php.ini配置調優

- PHP 幾種常見超時的設置方法

- PHP函數in_array、array_key_exists和isset效率分析

- php array push 和array_merge 效率誰高,php 通過array_merge()和array+array合并數組的區別和效率比較...

- php 兩個數組取交集、并集、差集

- 設置PHP最大連接數及php-fpm 高并發 參數調整

- 小工具

- php 獲取代碼執行時間和消耗的內存

- PHP如何判斷某項擴展是否開啟

- centos7.x下php 導出擴展 XLSXWriter 安裝

- php生成mysql數據庫字典

- PHP 實現 word/excel/ppt 轉換為 PDF

- composer的使用

- showdoc sqlite3 找回管理員密碼

- php怎么將數組轉為xml

- PHP抖音最新視頻提取代碼

- yii

- Yii2 如何獲取Header參數?

- swoole

- Linux下搭建swoole服務的基本步驟

- 相關學習資料

- 帶你學習swoole_process詳解

- 按照官方文檔 在win10下安裝 docker for windows easyswoole鏡像 掛載目錄

- php常用框架

- Hyperf

- 常用算法PHP版

- thinkphp6

- TP6 事件綁定、監聽、訂閱

- Thinkphp 模板中輸出HTML的變量

- Thinkphp6(操作SQL數據庫)

- thinkphp6 mysql查詢語句對于為null和為空字符串給出特定值處理

- Thinkphp 6 - 連接配置多個數據庫并實現自由切換(詳細過程及實例demo)

- TP框架中的Db::name 和 dB::table 以及 db('') 的區別

- thinkphp6.0模型篇之模型的軟刪除

- thinkphp6自定義日志驅動,增加顯示全部請求信息

- 其他系統

- 微擎數據庫字段字典

- Flutter實現微信支付和iOS IAP支付

- Flutter上線項目實戰——蘋果內購

- PHP接入蘋果支付

- 調試

- php如何獲取當前腳本所有加載的文件

- php跟蹤所有調用方法,日志方法

- 解析phpstorm + xdebug 遠程斷點調試

- PHP XDEBUG調試 PHPSTORM配置

- 異常處理

- PHP 出現 502 解決方案

- php 語法解析錯誤 syntax error unexpected namespace T_NAMESPACE

- Composer 安裝與使用

- 數據庫相關

- php pdo怎么設置utf8

- php 如何根據最新聊天對用戶進行排序

- php lic&fpm

- 讓php程序在linux后臺執行

- PHPcli模式和fpm模式優缺點在哪里?

- 運行模式

- php運行模式之cli模式

- 自己庫

- php批量獲取所有公眾號粉絲openid

- 地圖

- php 判斷點在多邊形內,php百度地圖api判斷地址是否在多邊形區域內

- PHP,Mysql-根據一個給定經緯度的點,進行附近地點查詢

- MySQL 根據經緯度查找排序

- PHP+MySQL獲取坐標范圍內的數據

- 【百度地圖】刪除指定覆蓋物

- 百度地圖多點+畫連接線+數字標注

- laravel5.8

- laravel5.8(四)引入自定義常量文件及公共函數文件

- Lumen 查詢執行SQL

- 使你的 Laravel 項目模塊化

- Laravel 多條件 AND , OR條件組合查詢

- Laravel 查詢 多個or或者and條件

- laravel redis操作大全

- laravel中外部定義whereIn的用法和where中使用in

- lumen5.8

- 創建laravel5.8 lumen前后臺api項目--記錄請求和響應日志

- Laravel和Lumen開啟SQL日志記錄

- Laravel 5.8 常用操作(路徑+日志+分頁+其他操作)

- 升級php7.4 laravel lumen報錯Trying to access array offset on value of type null

- Laravel 任務調度(計劃任務,定時任務)

- laravel的command定時任務時間的設置

- Laravel任務調度的簡單使用

- laravel單數據庫執行事務和多數據庫執行事務

- laravel中鎖以及事務的簡單使用

- 申請其他相關

- 小程序地理位置接口申請

- PHP高并發

- php 高并發下 秒殺處理思路

- 記錄 PHP高并發 商品秒殺 問題的 Redis解決方案

- thinkphp3.2

- thinkphp3.2 數據庫 AND OR連綴使用

- laravel

- laravel的聯表查詢with方法的使用

- laravel獲取請求路由對應的控制器和方法

- Laravel 模型關聯建立與查詢

- Laravel多表(3張表以上)with[]關聯查詢,對關聯的模型做條件查詢(has,跟join一樣結果 )

- Laravel模型屬性的隱藏屬性、顯示屬性和臨時暴露隱藏屬性用法介紹

- aravel獲取當前的url以及當前的基礎域名方法匯總

- Laravel 模型實現多庫查詢或者多表映射

- 關于 Laravel 的 with 多表查詢問題

- Laravel 模型過濾(Filter)設計

- 懶加載、預加載、with()、load() 傻傻分不清楚?

- laravel模型$castsl屬性

- Laravel Query Builder 復雜查詢案例:子查詢實現分區查詢 partition by

- Laravel 模型關聯、關聯查詢、預加載使用實例

- laravel 中with關聯查詢限定查詢字段

- laravel 原生字段查詢 whereRaw 和 where(DB::raw(''))

- lavarel - where條件分組查詢(orWhere)

- 通過 Laravel 查詢構建器實現復雜的查詢語句

- 兩個結果集合并成一個

- Laravel 對某一列進行篩選然后求和 sum()

- laravel怎么優雅的拼接where,處理whereIn與where數組查詢的問題

- laravel查詢時判斷是否存在數據

- laravel中的whereNull和whereNotNull

- laravel框架中的子查詢

- Laravel框架中 orwhere 多條件查詢的使用

- Laravel中where的高級使用方法

- laravel復雜的數據庫查詢(事例)

- laravel多條件查詢方法(and,or嵌套查詢)

- Laravel 的 where or 查詢

- Laravel 進行where 多個or和and的條件查詢可用

- laravel Middleware 中間件 $next($request) 報錯不執行問題

- 基于Laravel框架--自定義CORS跨域中間件

- laravel9新增路由文件及解決跨域問題方法

- 解決在laravel中leftjoin帶條件查詢沒有返回右表為NULL的問題

- 【Laravel 】faker數據填充詳解

- 數據庫

- mysql

- mysql聯合索引(復合索引)詳解

- MYSQL 清空表和截斷表

- MySQL快速生成大量測試數據(100萬、1000萬、1億)

- 提高mysql千萬級大數據SQL查詢優化30條經驗(Mysql索引優化注意)

- MySQL常用命令

- MySQL(三)|《千萬級大數據查詢優化》第一篇:創建高性能的索引

- MySQL(一)|性能分析方法、SQL性能優化和MySQL內部配置優化

- MySQL(二)|深入理解MySQL的四種隔離級別及加鎖實現原理

- MySQL(四)|《千萬級大數據查詢優化》第一篇:創建高性能的索引(補充)

- MySQL(五)|《千萬級大數據查詢優化》第二篇:查詢性能優化(1)

- MySQL(六)|《千萬級大數據查詢優化》第二篇:查詢性能優化(2)

- MySQL(七)|MySQL分庫分表的那點事

- Mysql索引優化 Mysql通過索引提升查詢效率(第二棒)

- MySQL查詢的性能優化(查詢緩存、排序跟索引)

- 【總結】MySQL數據庫

- MySQL存儲引擎、事務日志并發訪問以及隔離級別

- 技巧

- 數據庫 SQL查詢重復記錄 方法

- 替換數據庫中某個字段中的部分字符

- mysql開啟bin log 并查看bin log日志(linux)

- 分表分區

- 千萬級別數據的mysql數據表優化

- MYSQL百萬級數據,如何優化

- MySQL備份和恢復

- MySQL間隙鎖死鎖問題

- 小技巧

- 基礎

- MySQL中sql_mode參數

- mysql數據庫異常

- this is incompatible with sql_mode=only_full_group_by

- mysql安全

- MySQL數據庫被比特幣勒索及安全調整

- mysql忘記密碼后重置(以windows系統mysql 8.4為例)

- MongoDB

- sql查詢

- MYSQL按時間段分組查詢當天,每小時,15分鐘數據分組

- 高級

- 基于 MySQL + Tablestore 分層存儲架構的大規模訂單系統實踐-架構篇

- 數據庫安全

- 服務器被黑,MySQL 數據庫遭比特幣勒索!該如何恢復?

- 數千臺MySQL數據庫遭黑客比特幣勒索,該怎么破?

- MySQL 數據庫規范

- MySQL數據庫開發的36條鐵律

- Elasticsearch

- 安裝與配置

- ElasticSearch關閉重啟命令

- 設置ES默認分詞器IK analyzer

- 查詢

- elasticsearch 模糊查詢不分詞,實現 mysql like

- elasticSearch多條件高級檢索語句,包含多個must、must_not、should嵌套示例,并考慮nested對象的特殊檢索

- elasticSearch按字段普通檢索,結果高亮

- Elasticsearch 如何實現查詢/聚合不區分大小寫?

- 索引更新&刷新

- refresh與批量操作的效率

- Elasticsearch 刪除type

- 分詞器

- ElasticSearch最全分詞器比較及使用方法

- 異常錯誤

- 解決ES因內存不足而無法查詢的錯誤,Data too large, data for [<http_request>]

- linux

- 基本知識

- CentOS7.5 通過wget下載文件到指定目錄

- 【CentOS】vi命令

- centos7查看硬盤使用情況

- CentOS7 查看目錄大小

- Centos 7下查看當前目錄大小及文件個數

- 普通用戶sudo\su 到root免密碼

- 普通用戶切換到root用戶下的免密配置方法

- linux 獲取進程啟動參數,linux查看進程啟動及運行時間

- Linux 查看進程

- linux刪除文件后不釋放磁盤的問題

- Linux查找大文件命令

- linux 如何關閉正在執行的php腳本

- linux三劍客(grep、sed、awk)基本使用

- centos 卸載軟件

- centos查看內存、cpu占用、占用前10,前X

- Centos 查看系統狀態

- 異常

- 問題解決:Failed to download metadata for repo ‘appstream‘: Cannot prepare internal mirrorlist:...

- php相關

- centos 安裝phpize

- Centos7.2下phpize安裝php擴展

- 切換版本

- 運營工具

- 資深Linux運維工程師常用的10款軟件/工具介紹

- 一款良心的終端連接工具

- 六款Linux常用遠程連接工具介紹,看看哪一款最適合你

- Finalshell

- Linux Finalshell連接centos7和文件無顯示問題

- WSL2:我在原生的Win10玩轉Linux系統

- MobaXterm

- 運維

- linux服務器上定時自動備份數據庫,并保留最新5天的數據

- Centos系統開啟及關閉端口

- CentOS7開放和關閉端口命令

- Linux中查看所有正在運行的進程

- 防火墻firewall-cmd命令詳解

- centos 7.8阿里云服務器掛載 數據盤

- Linux Finalshell連接centos7和文件無顯示問題

- Centos7系統端口被占用問題的解決方法

- vi

- 如何在Vim/Vi中復制,剪切和粘貼

- 命令

- [Linux kill進程] kill 進程pid的使用詳解

- 備份還原

- Linux的幾種備份、恢復系統方式

- Linux系統全盤備份方法

- 相關軟件安裝

- linux下 lua安裝

- python

- 升級pip之后出現sys.stderr.write(f“ERROR: {exc}“)

- lua

- centos源碼部署lua-5.3

- deepin

- deepin20.6設置默認的root密碼

- 任務相關

- 寶塔定時任務按秒執行

- CentOS 7 定時任務 crontab 入門

- centos7定時任務crontab

- Linux下定時任務的查看及取消

- Linux(CentOS7)定時執行任務Crond詳細說明

- Linux 查看所有定時任務

- linux查看所有用戶定時任務

- Linux 定時任務(超詳細)

- 防火墻

- Centos7開啟防火墻及特定端口

- CentOS防火墻操作:開啟端口、開啟、關閉、配置

- 生成 SSH 密鑰(windows+liunx)

- 阿里云,掛載云盤

- 前端

- layui

- layui多文件上傳

- layer.msg()彈框,彈框后繼續運行

- radio取值

- layui-數據表格排序

- Layui select選擇框添加搜索選項功能

- 保持原來樣式

- layui表格單元如何自動換行

- layui-laydate時間日歷控件使用方法詳解

- layui定時刷新數據表格

- layer 延時設置

- layer.open 回調函數

- 【Layui內置方法】layer.msg延時關閉msg對話框(代碼案例)

- layui多圖上傳圖片順序錯亂及重復上傳解決

- layer.confirm關閉彈窗

- vue

- Vue跨域解決方法

- vue 4.xx.xx版本降級至2.9.6

- vue-cli 2.x升級到3.x版本, 和3.x降級到2.x版本命令

- 最新版Vue或者指定版本

- Vue2.6.11按需模塊安裝配置

- jQuery

- jQuery在頁面加載時動態修改圖片尺寸的方法

- jquery操作select(取值,設置選中)

- 日歷

- FullCalendar中文文檔:Event日程事件

- js

- JS 之 重定向

- javascript截取video視頻第一幀作為封面方案

- HTML <video> preload 屬性

- jQuery使用ajax提交post數據

- JS截取視頻靚麗的幀作為封面

- H5案例分享:移動端touch事件判斷滑屏手勢的方向

- JS快速獲取圖片寬高的方法

- win

- Windows環境下curl的使用

- Cygwin

- Windows下安裝Cygwin及apt-cyg

- Cygwin 安裝、CMake 安裝

- mklink命令 詳細使用

- Nginx

- Nginx高級篇-性能優化

- Nginx常用命令(Linux)

- linux+docker+nginx如何配置環境并配置域名訪問

- Nginx的啟動(start),停止(stop)命令

- linux 查看nginx 安裝路徑

- 安裝配置

- Linux 查看 nginx 安裝目錄和配置文件路徑

- 【NGINX入門】3.Nginx的緩存服務器proxy_cache配置

- thinkphp6.0 偽靜態失效404(win下)

- 深入

- nginx rewrite及多upstream

- Nginx負載均衡(upstream)

- 專業術語

- 耦合?依賴?耦合和依賴的關系?耦合就是依賴

- PHP常用六大設計模式

- 高可用

- 分布式與集群

- Nginx 實踐案例:反向代理單臺web;反向代理多組web并實現負載均衡

- 容器

- Docker

- 30 分鐘快速入門 Docker 教程

- linux查看正在運行的容器,說說Docker 容器常用命令

- Windows 安裝Docker至D盤

- 配置

- win10 快速搭建 lnmp+swoole 環境 ,部署laravel6 與 swoole框架laravel-s項目1

- win10 快速搭建 lnmp+swoole 環境 ,部署laravel6 與 swoole框架laravel-s項目2

- docker 容器重命名

- Linux docker常用命令

- 使用

- docker 搭建php 開發環境 添加擴展redis、swoole、xdebug

- docker 單機部署redis集群

- Docker 退出容器不停止容器運行 并重新進入正在運行的容器

- 進入退出docker容器

- Docker的容器設置隨Docker的啟動而啟動

- 使用異常處理

- docker容器中bash: vi: command not found

- OCI runtime exec failed: exec failed:解決方法

- docker啟動容器慢,很慢,特別慢的坑

- 解決windows docker開發thinkphp6啟動慢的問題

- 【Windows Docker】docker掛載解決IO速度慢的問題

- Docker的網絡配置,導致Docker使用網路很慢的問題及解決辦法

- golang工程部署到docker容器

- Docker 容器設置自啟動

- 如何優雅地刪除Docker鏡像和容器(超詳細)

- 5 個好用的 Docker 圖形化管理工具

- Docker 可能會用到的命令

- Kubernetes

- 消息隊列

- RabbitMQ

- php7.3安裝使用rabbitMq

- Windows環境PHP如何使用RabbitMQ

- RabbitMQ學習筆記:4369、5672、15672、25672默認端口號修改

- Window10 系統 RabbitMQ的安裝和簡單使用

- RabbitMQ默認端口

- RabbitMQ可視化界面登錄不了解決方案

- RocketMQ

- Kafka

- ActiveMQ

- mqtt

- phpMQTT詳解以及處理使用過程中內存耗死問題

- MQTT--物聯網(IoT)消息推送協議

- php實現mqtt發布/發送 消息到主題

- Mqtt.js 的WSS鏈接

- emqx

- 如何在 PHP 項目中使用 MQTT

- emqx 修改dashboard 密碼

- 其他

- Windows 系統中單機最大TCP的連接數詳解

- EMQX

- Linux系統EMQX設置開機自啟

- Centos7 EMQX部署

- docker安裝 EMQX 免費版 docker安裝并配置持久化到服務器

- 實時數倉

- 網易云音樂基于 Flink + Kafka 的實時數倉建設實踐

- 實時數倉-基于Flink1.11的SQL構建實時數倉探索實踐

- 安全

- 網站如何保護用戶的密碼

- 關于web項目sessionID欺騙的問題

- php的sessionid可以偽造,不要用來做防刷新處理了

- DVWA-Weak Session IDs (弱會話)漏洞利用方式

- 保證接口數據安全的10種方案

- cookie和session的竊取

- 萬能密碼漏洞

- 黑客如何快速查找網站后臺地址方法整理

- 網站后臺萬能密碼/10大常用弱口令

- 萬能密碼漏洞02

- 大多數網站后臺管理的幾個常見的安全問題注意防范

- token可以被竊取嗎_盜取token

- token被劫持[token被劫持如何保證接口安全性]

- PHP給后臺管理系統加安全防護機制的一些方案

- php - 重新生成 session ID

- 隱藏響應中的server和X-Powered-By

- PHP會話控制之如何正確設置session_name

- Session攻擊001

- PHP防SQL注入代碼,PHP 預防CSRF、XSS、SQL注入攻擊

- php25個安全實踐

- php架構師 系統管理員必須知道的PHP安全實踐

- 版本控制

- Linux服務器關聯Git,通過執行更新腳本實現代碼同步

- PHP通過exec執行git pull

- git 在linux部署并從windows上提交代碼到linux

- git上傳到linux服務器,git一鍵部署代碼到遠程服務器(linux)

- linux更新git命令,使用Linux定時腳本更新服務器的git代碼

- git異常

- 如何解決remote: The project you were looking for could not be found

- git status顯示大量文件修改的原因是什么

- PHPstorm批量修改文件換行符CRLF為LF

- git使用

- git常用命令大全

- centos git保存賬戶密碼

- GIT 常用命令

- git怎樣還原修改

- Git 如何放棄所有本地修改的方法

- Git忽略文件模式改變

- git: 放棄所有本地修改

- Git三種方法從遠程倉庫拉取指定的某一個分支

- 雜七雜八

- h5視頻

- H5瀏覽器支持播放格式:H264 AVCA的MP4格式,不能轉換為mpeg-4格式,

- iOS無法播放MP4視頻文件的解決方案 mp4視頻iphone播放不了怎么辦

- h5點播播放mp4視頻遇到的坑,ios的h5不能播放視頻等

- 【Linux 并發請求數】支持多少并發請求數

- Linux下Apache服務器并發優化

- 緩存

- redis

- Linux啟動PHP的多進程任務與守護redis隊列

- 重啟redis命令

- golang