[TOC]

> 官網:https://kubernetes.io/docs/concepts/services-networking/service/

# 介紹

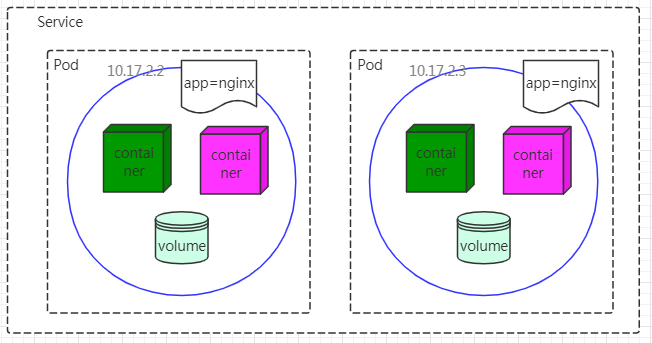

* RC、RS和Deployment保障支撐服務Pod的數量

* Service解決訪問Pod的問題

* 每個Service對應集群內部一個有效虛擬IP

* 集群內部通過虛擬IP訪問一個服務

* K8s內部負載均衡為Kube-proxy

* 每個節點都有一個Kube-proxy

* Service是由標簽選擇器定義的一組pods

* `Service`能將一個接收`port`映射到任意的`targetPort`

* 默認`Service`的`targetPort`和`port`的值相同

* 支持多個端口、協議可以相同也可以不相同

# 舉例

## 有selector的Service

一組`Pod`對外暴露6379端口,標簽為`app=MyRedis`

```yaml

apiVersion: v1

kind: Service

metadata:

name: redis-master

spec:

selector:

app: MyRedis

ports:

- protocol: TCP

port: 80

targetPort: 6379

```

> 通過上述配置創建名稱為“redis-master”的`Service`對象,將請求代理到使用TCP端口6379,并且標簽為`app=MyRedis`的`Pod`

## 無selector的Service

Service常規用法是抽象化對·Pod·的訪問,也可以抽象化其他種類的后端:

* 在生產環和測試環境中使用不同的數據庫集群

* 服務指向另一個命名空間中或其他集群中的服務

* 在K8s集群中運行部分后端,用于評估將工作負載遷移到K8S

```

apiVersion: v1

kind: Service

metadata:

name: redis-master

spec:

ports:

- protocol: TCP

port: 80

targetPort: 6379

```

由于定義的`Service`沒有selector,所以不會自動創建相應的Endpoint對象,需要手動添加Endpoint對象,將服務手動映射到運行該服務的網絡地址和端口

```yaml

apiVersion: v1

kind: Endpoints

metadata:

name: redis-master

subsets:

- addresses:

- ip: 192.168.136.200

ports:

- port: 6379

```

> * 端點 IPs 不可以是環回( IPv4 的 127.0.0.0/8 , IPv6 的 ::1/128 )

> * 不可以是本地鏈接(IPv4 的 169.254.0.0/16 和 224.0.0.0/24,IPv6 的 fe80::/64)

> * 端點 IP 地址不能是其他 Kubernetes Services 的群集 IP,因為kube-proxy不支持將虛擬 IP 作為目標

訪問沒有 selector 的`Service`,與有 selector 的`Service`的原理相同。 請求將被路由到用戶定義的 Endpoint, YAML中為:`192.168.136.200:6379`(TCP)

### ExternalName Service

* ExternalName `Service`無Selector,也沒有用DNS名稱代替,是`Service`的特例

* ExternalName類型的`Service`將服務映射到DNS名稱,如`redis-service`,可以通過`spec.externalNmae`參數指定服務

#### 舉例

將`prod`名稱空間中的`redis-master`服務映射到`my.redis.pmk8s.com`

```yaml

apiVersion: v1

kind: Service

metadata:

name: redis-master

namespace: prod

spec:

type: ExternalName

externalName: my.redis.pmk8s.com

```

> ExternalName 接受 IPv4 地址字符串,但作為包含數字的 DNS 名稱,而不是 IP 地址。 類似于 IPv4 地址的外部名稱不能由 CoreDNS 或 ingress-nginx 解析,因為外部名稱旨在指定規范的 DNS 名稱。 要對 IP 地址進行硬編碼,需要使用`headless Services`

當查找主機`redis-service.prod.svc.cluster.local`時,群集DNS服務返回`CNAME`記錄,其值為`my.redis.pmk8s.com`。 訪問`redis-service`的方式與其他服務的方式相同,但主要區別在于重定向發生在 DNS 級別,而不是通過代理或轉發

# Service代理

kube-proxy負責為`Service`實現了一種VIP(虛擬IP)的形式,而不是ExternalName的形式

## userspace代理模式

## iptables代理模式

## IPVS代理模式

# 多端口Service

* 定義多個端口時,必須提供端口名稱

* 端口名稱只能包含小寫字母、數字字符和`-`

* 端口號名稱必須以字母數字字符開頭和結尾

```

apiVersion: v1

kind: Service

metadata:

name: redis-master

spec:

selector:

app: MyRedis

ports:

- name: http

protocol: TCP

port: 80

targetPort: 6379

- name: https

protocol: TCP

port: 443

targetPort: 6380

```

# 選擇自己的IP地址

* 在` Service`創建請求中,通過設置`spec.clusterIP`字段指定自己的集群IP地址

* 指定的IP地址必須合法,并且這個IP地址在`service-cluster-ip-range` CIDR范圍內

```

apiVersion: v1

kind: Service

metadata:

name: redis-master

spec:

selector:

app: MyRedis

clusterIP: 10.96.0.13

ports:

- name: http

protocol: TCP

port: 80

targetPort: 6379

- name: https

protocol: TCP

port: 443

targetPort: 6380

```

# 服務發現

K8s支持環境變量和DNS兩種服務發現模式

* 環境變量

* 當`Pod`運行在`Node`上,kubelet 會為每個活躍的`Service`添加一組環境變量

* 它同時支持 Docker links兼容變量、簡單的`{SVCNAME}_SERVICE_HOST`和`{SVCNAME}_SERVICE_PORT`變量

* 這里`Service`的名稱需大寫,橫線被轉換成下劃線。

例子,一個名稱為`"redis-master"`的 Service 暴露了 TCP 端口 6379,同時給它分配了 Cluster IP 地址 10.96.0.13,這個 Service 生成了如下環境變量:

```shell

REDIS_MASTER_SERVICE_HOST=10.96.0.13

REDIS_MASTER_SERVICE_PORT=6379

REDIS_MASTER_PORT=tcp://10.96.0.13:6379

REDIS_MASTER_PORT_6379_TCP=tcp://10.96.0.13:6379

REDIS_MASTER_PORT_6379_TCP_PROTO=tcp

REDIS_MASTER_PORT_6379_TCP_PORT=6379

REDIS_MASTER_PORT_6379_TCP_ADDR=10.96.0.13

```

> 通過環境變量訪問服務的Pod時,服務創建必須在客戶端Pod出現之前創建好

* DNS

* 使用[附加組件](https://kubernetes.io/docs/concepts/cluster-administration/addons/)為Kubernetes集群設置DNS服務。

* 支持群集的DNS服務器(例如CoreDNS)監視 Kubernetes API 中的新服務,并為每個服務創建一組 DNS 記錄

* 如果在整個群集中都啟用了 DNS,則所有 Pod 都應該能夠通過其 DNS 名稱自動解析服務

* Kubernetes DNS 服務器是唯一的一種能夠訪問`ExternalName`類型的 Service 的方式

* Kubernetes 還支持命名端口的 DNS SRV(服務)記錄

例如,如果您在 Kubernetes 命名空間`"my-ns"`中有一個名為`"redis-master"`的服務, 則控制平面和DNS服務共同為`"redis-master.my-ns"`創建 DNS 記錄。`"my-ns"`命名空間中的Pod應該能夠通過簡單地對`redis-master`進行名稱查找來找到它(`"redis-master.my-ns"`也可以工作)。

其他命名空間中的Pod必須將名稱限定為`redis-master.my-ns`。 這些名稱將解析為為服務分配的群集IP。

如果`"redis-master.my-ns"`服務具有名為`"http"` 的端口,且協議設置為`TCP`, 則可以對`_http._tcp.redis-master.my-ns`執行DNS SRV查詢查詢以發現該端口號,`"http"`以及IP地址

# Headless Services

有時不需要或不想要負載均衡,以及單獨的 Service IP。 遇到這種情況,可以通過指定 Cluster IP(`spec.clusterIP`)的值為`"None"`來創建`Headless`Service。

您可以使用 headless Service 與其他服務發現機制進行接口,而不必與 Kubernetes 的實現捆綁在一起。

對這 headless`Service`并不會分配 Cluster IP,kube-proxy 不會處理它們,而且平臺也不會為它們進行負載均衡和路由。 DNS 如何實現自動配置,依賴于`Service`是否定義了 selecto

# 發布服務

* Kubernetes`ServiceTypes`允許指定一個需要的類型的 Service,默認是`ClusterIP`類型

* `Type`的取值以及行為如下:

* `ClusterIP`:通過集群的內部 IP 暴露服務,選擇該值,服務只能夠在集群內部可以訪問,這也是默認的`ServiceType`。 \*[`NodePort`](https://kubernetes.io/zh/docs/concepts/services-networking/service/#nodeport):通過每個 Node 上的 IP 和靜態端口(`NodePort`)暴露服務。

* `NodePort`服務會路由到`ClusterIP`服務,這個`ClusterIP`服務會自動創建。通過請求`<NodeIP>:<NodePort>`,可以從集群的外部訪問一個`NodePort`服務。

* `LoadBalancer`:使用云提供商的負載局衡器,可以向外部暴露服務。外部的負載均衡器可以路由到`NodePort`服務和`ClusterIP`服務。

* `ExternalName`:通過返回`CNAME`和它的值,可以將服務映射到`externalName`字段的內容(例如,`foo.bar.example.com`)。 沒有任何類型代理被創建

## NodePort類型

如果將`type`字段設置為`NodePort`,則 Kubernetes 控制平面將在`--service-node-port-range`標志指定的范圍內分配端口(默認值:30000-32767)。 每個節點將那個端口(每個節點上的相同端口號)代理到您的服務中。 您的服務在其`.spec.ports[*].nodePort`字段中要求分配的端口。

如果您想指定特定的IP代理端口,則可以將 kube-proxy 中的`--nodeport-addresses`標志設置為特定的IP塊。從Kubernetes v1.10開始支持此功能。

該標志采用逗號分隔的IP塊列表(例如10.0.0.0/8、192.0.2.0/25)來指定 kube-proxy 應該認為是此節點本地的IP地址范圍。

例如,如果您使用`--nodeport-addresses=127.0.0.0/8`標志啟動 kube-proxy,則 kube-proxy 僅選擇 NodePort Services 的環回接口。`--nodeport-addresses`的默認值是一個空列表。 這意味著 kube-proxy 應該考慮 NodePort 的所有可用網絡接口。 (這也與早期的Kubernetes版本兼容)。

如果需要特定的端口號,則可以在`nodePort`字段中指定一個值。 控制平面將為您分配該端口或向API報告事務失敗。 這意味著您需要自己注意可能發生的端口沖突。 您還必須使用有效的端口號,該端口號在配置用于NodePort的范圍內。

使用 NodePort 可以讓您自由設置自己的負載平衡解決方案,配置 Kubernetes 不完全支持的環境,甚至直接暴露一個或多個節點的IP。

需要注意的是,Service 能夠通過`<NodeIP>:spec.ports[*].nodePort`和`spec.clusterIp:spec.ports[*].port`而對外可見

## LoadBalancer 類型

使用支持外部負載均衡器的云提供商的服務,設置`type`的值為`"LoadBalancer"`,將為`Service`提供負載均衡器。 負載均衡器是異步創建的,關于被提供的負載均衡器的信息將會通過`Service`的`status.loadBalancer`字段被發布出去

外部IP,如轉到外部的DB存儲

```yaml

apiVersion: v1

kind: Service

metadata:

name: redis-master

spec:

selector:

app: MyApp

ports:

- protocol: TCP

port: 80

targetPort: 6379

clusterIP: 10.0.171.239

loadBalancerIP: 78.11.24.19

type: LoadBalancer

status:

loadBalancer:

ingress:

- ip: 146.148.47.155

```

來自外部負載均衡器的流量將直接打到 backend`Pod`上,不過實際它們是如何工作的,這要依賴于云提供商。

在這些情況下,將根據用戶設置的`loadBalancerIP`來創建負載均衡器。 某些云提供商允許設置`loadBalancerIP`。如果沒有設置`loadBalancerIP`,將會給負載均衡器指派一個臨時 IP。 如果設置了`loadBalancerIP`,但云提供商并不支持這種特性,那么設置的`loadBalancerIP`值將會被忽略掉。

## 外部 IP

如果外部的 IP 路由到集群中一個或多個 Node 上,Kubernetes`Service`會被暴露給這些`externalIPs`。 通過外部 IP(作為目的 IP 地址)進入到集群,打到`Service`的端口上的流量,將會被路由到`Service`的 Endpoint 上。`externalIPs`不會被 Kubernetes 管理,它屬于集群管理員的職責范疇。

根據`Service`的規定,`externalIPs`可以同任意的`ServiceType`來一起指定。 在上面的例子中,`redis-master`可以在 “`192.168.136.200:80`”(`externalIP:port`) 上被客戶端訪問

```yaml

apiVersion: v1

kind: Service

metadata:

name: redis-master

spec:

selector:

app: MyApp

ports:

- name: http

protocol: TCP

port: 80

targetPort: 6379

externalIPs:

- 192.168.136.200

```

- 前言

- 1.說明

- 2.文檔更新說明

- docker

- 01.docker安裝

- 02.docker加速器

- 03.docker基本使用

- 04.docker 鏡像與容器

- 05.Dockerfile

- 06.docker阿里鏡像倉庫

- 07.docker私有鏡像倉庫harbor

- 08.docker網絡

- 09.docker項目實戰01

- 10.docker項目實戰02

- 11.docker componse

- 12.docker-compose常用命令

- 13.docker compose 案例

- 14.docker swarm集群

- 15.docker swarm常用命令

- 16.docker swarm 案例

- 17.volume

- 18.network

- 19.idea中部署項目到docker

- 20.docker目錄方式掛載sqlite

- 21.docker常用命令補充

- 22.nginx容器代理靜態文件403解決

- 23.docker集群管理平臺

- k8s

- 01.Kubernetes介紹

- 02.K8s基本概念

- 03.K8s架構圖

- 04.Minikube單節點環境搭建

- 05.kubeadm集群安裝1.14.0

- 06.虛擬機靜態網絡配置

- 07.kubeadm高可用集群安裝1.14.0

- 08 高可用VIP配置(keepalived+haproxy)

- 09.高可用免密登錄

- 10.kubeadm init流程

- 11.k8s體驗

- 12.網絡插件

- 13.Ingress

- 14.Ingress分類

- 15.Dashboard

- 16.存儲

- 01.Volumes

- 02.nfs

- 03.PV PVC

- 04.StorageClass

- 17.基礎組件

- 01.Pod

- 02.Service

- 03.ReplicaSet(RS)

- 04.Deployment

- 06.Namespace

- 02.DaemonSet

- 03.StatefulSet

- 04.ReplicationController(RC)

- 06.Job

- 09.PetSet

- 10.StatefulSets

- 11.Federation

- 12.Secret

- 05.Resources

- 13.UserAccount/ServiceAccount

- 14.RBAC

- 18.核心組件

- Master組件

- 01.kube-apiserver

- 02.etcd

- 03.kube-controller-manager

- 04.cloud-controller-manager

- 05.kube-scheduler

- 06.DNS

- Node組件

- 01.kubelet

- 02.kube-proxy

- 03.docker

- 04.RKT

- 05.supervisord

- 06.fluentd

- kubectl

- 19.K8S服務更新部署

- 20.CI/CD

- 01.java安裝

- 02.maven安裝

- 03.gitlab安裝

- 04.git安裝

- 05.jenkins安裝

- 06.k8s集群

- 07.DockerHub

- 08.實戰

- 21.日志

- 01.不同組件日志

- 02.LogPilot+ES+Kibana

- 22.監控

- 23.k8s部署ocp項目[mysql]

- 01.ocp介紹

- 02.環境準備

- 03.鏡像準備

- 04.部署說明

- 05.eureka-server

- 06.mysql

- 07.redis

- 08.auth-server

- 09.user-center

- 10.new-api-gateway

- 11.back-center

- 飛致云kubeoperator

- 01.kubeoperator介紹

- 02.kubeoperator安裝

- 飛致云DataEase

- 項目介紹

- 系統架構

- 安裝部署

- 在線安裝

- 離線安裝

- 用戶手冊

- 通用功能

- 數據源

- 數據集

- 視圖

- 儀表板

- 系統管理

- 用戶管理

- 飛致云JumpServer

- TIDB

- 網絡

- 交換機

- ISO/OSI協議模型詳解

- 交換CCNP

- RSTP快速生成樹協議

- MST多生成樹協議

- 以太網信道【應用廣泛】

- 廣播和多播抑制

- 多層交換

- ARP地址解析協議抑制

- VLAN間路由

- 熱備份路由協議HSRP【思科私有】

- 虛擬路由器冗余協議VRRP

- linux

- 01.時間同步

- linux時間不能同步

- Linux掛載磁盤

- 安裝ftp

- linux環境ftp賬號

- HTTP狀態碼

- 寶塔

- Centos安裝vsftp

- nginx ssl 配置

- datax

- 1.geom類型遷移擴展

- python安裝

- 消息中間件

- 1.RocketMQ

- 1.RocketMQ單機環境安裝

- 前端

- node踩坑之npm

- 數據庫

- Mysql安裝

- ClickHouse

- OceanBase數據庫

- OceanBase介紹

- OceanBase數據庫整體架構

- 快速入門

- 資源準備

- 安裝 OBD部署 OceanBase 數據庫

- 基本操作

- 數據庫操作

- 表操作

- 索引操作

- 插入數據

- 刪除數據

- 更新數據

- 提交事務

- 回滾事務

- 安裝部署

- 使用 RPM 包安裝 OceanBase 數據庫

- 使用源碼構建 OceanBase 數據庫

- 設置無密碼 SSH 登錄

- 配置時鐘源

- 數據分布

- 集群管理

- 租戶與資源管理

- 數據分布1

- 數據副本與服務

- 數據均衡

- 數據模型

- 多租戶架構

- 系統租戶

- 普通租戶

- 表格和表組

- 二級索引

- 無主鍵表

- 視圖

- 高可用

- 高可用方案

- 部署模式

- redo 日志管理控制

- 事務管理

- 隔離級別

- 并發控制

- 全局時間戳服務

- 本地事務

- 分布式事務

- 分布式查詢

- 存儲架構

- LSM Tree 架構

- 內存表 MemTable

- 塊存儲 SSTable

- 轉儲和合并

- 緩存機制

- 讀寫流程

- DDL

- SQL 引擎

- SQL 請求執行流程

- 查詢改寫

- 基于規則的查詢改寫

- 基于代價的查詢改寫

- 查詢優化

- 訪問路徑

- 基于規則的路徑選擇

- 基于代價的路徑選擇

- 聯接算法

- 聯接算法

- 聯接順序

- SQL 執行計劃

- 執行計劃算子

- TABLE SCAN

- TABLE LOOKUP

- JOIN

- COUNT

- GROUP BY

- WINDOW FUNCTION

- SUBPLAN FILTER

- DISTINCT

- SEQUENCE

- MATERIAL

- SORT

- LIMIT

- FOR UPDATE

- SELECT INTO

- SUBPLAN SCAN

- UNION

- INTERSECT

- EXCEPT/MINUS

- INSERT

- DELETE

- UPDATE

- MERGE

- EXCHANGE

- GI

- 執行計劃緩存

- 快速參數化

- 實時執行計劃展示

- 分布式執行計劃

- 分布式執行和并行查詢

- 分布式計劃的生成

- 分布式執行計劃調度

- 分布式執行計劃管理

- 并行查詢的執行

- 并行查詢的參數調優

- 備份與恢復

- 備份架構

- 恢復架構

- Backup Set

- Archive Log Round

- 管理員指南

- 數據庫基礎組件介紹

- 數據庫管理工具介紹

- OceanBase 客戶端

- MySQL 客戶端

- 數據庫基礎管理

- OceanBase 集群管理

- 集群參數管理

- 查詢集群參數

- 修改集群參數

- Zone 管理

- 增加或刪除 Zone

- 啟動或停止 Zone

- 修改 Zone

- OBServer 管理

- 查看 OBServer 狀態

- 停止 OBServer

- 啟動 OBServer

- 管理 OBServer 節點狀態

- 資源管理

- 創建資源單元

- 查看資源單元

- 修改資源單元

- 刪除資源單元

- 創建資源池

- 查看資源配置

- 修改資源池

- 刪除資源池

- 租戶管理

- 創建用戶租戶

- 新建租戶

- 查看租戶

- 修改租戶

- 刪除租戶

- 查看租戶會話

- 終止租戶會話

- 租戶管理變量

- 內存管理

- OceanBase 內存結構

- OceanBase 數據庫內存上限

- 系統內部內存管理

- 租戶內部內存管理

- 執行計劃緩存

- 常見內存問題

- 數據庫對象管理

- 管理表

- 關于表

- 創建表

- 定義自增列

- 定義列的約束類型

- 查看表的定義

- 更改表

- 清空表

- 刪除表

- 管理表組

- 關于表組

- 表組管理命令

- 管理索引

- 關于索引

- 創建索引

- 查看索引

- 刪除索引

- 視圖和同義詞管理

- 管理視圖

- 管理同義詞

- 數據分布和鏈路管理

- 分區表和分區索引管理

- 關于分區

- 分區策略

- 創建分區表

- 一級分區表

- 二級分區表

- 維護分區表

- 一級分區表

- 二級分區表

- 分區裁剪

- 分區命名與查詢

- 在分區表上建立索引

- 局部索引

- 全局索引

- 使用索引

- 副本管理

- 表級副本的使用

- Locality 管理

- 修改租戶的 Locality

- 事務管理

- 提交事務

- 回滾事務

- 事務隔離級別

- 用戶權限管理

- 創建用戶

- 修改用戶權限

- 查看白名單

- 鎖定和解鎖用戶

- 刪除用戶

- 數據高可用

- 回收站管理

- 回收站支持的對象

- 數據庫、表和索引級回收站

- 租戶級回收站

- 物理備份與恢復管理

- 部署 NFS

- 備份數據

- 通過命令行備份

- 查看備份進度

- 停止備份

- 刪除過期的備份

- 清理備份數據

- 取消清理備份數據

- 恢復數據

- 執行恢復

- 查看恢復進度和結果

- 備份維護

- 開發者指南

- 關于OceanBase數據庫

- OceanBase 集群簡介

- OceanBase 租戶簡介

- MySQL 租戶數據庫對象

- MySQL 客戶端

- OceanBase 客戶端(obclient)

- 關于結構化查詢語言

- Java 數據庫連接驅動(JDBC)

- 連接OceanBase數據庫

- 通過 MySQL 客戶端連接 OceanBase 租戶

- 通過 obclient 連接 OceanBase 租戶

- 創建 OceanBase 示例數據庫 TPCC

- 通過 obclient 探索 OceanBase MySQL 租戶

- 查詢表數據

- 關于查詢語句

- 查詢表里符合特定搜索條件的數據

- 對查詢的結果進行排序

- 從多個表里查詢數據

- 在查詢中使用操作符和函數

- 查看查詢執行計劃

- 在查詢中使用 SQL Hint

- 關于查詢超時設計

- 關于 DML 語句和事務

- 關于 DML 語句

- 關于 INSERT 語句

- 關于 UPDATE 語句

- 關于 DELETE 語句

- 關于 REPLACE INTO 語句

- 關于事務控制語句

- 提交事務

- 回滾事務

- 事務保存點

- 關于事務超時

- 創建和管理數據庫對象

- 關于 DDL 語句

- 創建數據庫

- 創建和管理表

- 關于 SQL 數據類型

- 創建表

- 關于自增列

- 關于列的約束類型

- 關于表的索引

- 閃回被刪除的表

- 創建和管理分區表

- 分區路由

- 分區策略

- 分區表的索引

- 分區表使用建議

- 創建和管理表組

- 關于表組

- 創建表時指定表組

- 查看表組信息

- 向表組中增加表

- 刪除表組

- 創建和管理視圖

- 創建視圖

- 修改視圖

- 刪除視圖

- 向 OceanBase 遷移數據

- DataX

- 不同數據源的 DataX 讀寫插件示例

- OceanBase 數據加載技術

- 附錄

- OceanBase 常用參數和變量

- OceanBase 常用 SQL

- SQL參考

- 基本元素

- 運算符

- 函數

- 函數

- 聚集函數

- 分析函數

- 信息函數

- 其它函數

- 查詢和子查詢

- 連接

- 集合

- SQL語句

- 通用語法

- ALTER DATABASE

- ALTER OUTLINE

- ALTER RESOURCE POOL

- ALTER RESOURCE UNIT

- ALTER SYSTEM

- ALTER TABLE

- ALTER TABLEGROUP

- ALTER TENANT

- ALTER USER

- CREATE DATABASE

- CREATE INDEX

- CREATE OUTLINE

- CREATE RESOURCE POOL

- CREATE RESOURCE UNIT

- CREATE RESTORE POINT

- CREATE SYNONYM

- CREATE TABLE

- CREATE TABLEGROUP

- CREATE TENANT

- CREATE USER

- CREATE VIEW

- DELETE

- DROP DATABASE

- DROP INDEX

- DROP OUTLINE

- DROP RESOURCE POOL

- DROP RESOURCE UNIT

- DROP RESTORE POINT

- DROP TABLE

- DROP TABLEGROUP

- DROP TENANT

- DROP SYNONYM

- DROP USER

- DROP VIEW

- EXPLAIN

- FLASHBACK DATABASE

- FLASHBACK TABLE

- FLASHBACK TENANT

- GRANT

- INSERT

- KILL

- PURGE DATABASE

- PURGE INDEX

- PURGE RECYCLEBIN

- PURGE TABLE

- PURGE TENANT

- RENAME TABLE

- RENAME USER

- REPLACE

- REVOKE

- SAVEPOINT

- SCHEMA

- SELECT

- SESSION

- SET PASSWORD

- SHOW GRANTS

- SHOW RECYCLEBIN

- TRANSACTION

- TRUNCATE TABLE

- UPDATE

- SQL調優指南

- SQL請求執行流程

- SQL 執行計劃

- SQL 執行計劃簡介

- 執行計劃算子

- TABLE SCAN

- TABLE LOOKUP

- JOIN

- COUNT

- GROUP BY

- WINDOW FUNCTION

- SUBPLAN FILTER

- DISTINCT

- SEQUENCE

- MATERIAL

- SORT

- LIMIT

- FOR UPDATE

- SELECT INTO

- SUBPLAN SCAN

- UNION

- INTERSECT

- EXCEPT/MINUS

- INSERT

- DELETE

- UPDATE

- MERGE

- EXCHANGE

- GI

- 執行計劃緩存

- 快速參數化

- 實時執行計劃展示

- 分布式執行計劃

- 分布式執行和并行查詢

- 分布式計劃的生成

- 分布式執行計劃調度

- 分布式執行計劃管理

- 并行查詢的執行

- 并行查詢的參數調優

- 參考指南

- 系統視圖

- 概述

- 字典視圖

- mysql.help_topic

- mysql.help_category

- mysql.help_keyword

- mysql.help_relation

- mysql.db

- mysql.proc

- mysql.time_zone

- mysql.time_zone_name

- mysql.time_zone_transition

- mysql.time_zone_transition_type

- mysql.user

- information_schema.CHARACTER_SETS

- information_schema.COLLATIONS

- information_schema.COLLATION_CHARACTER_SET_APPLICABILITY

- information_schema.COLUMNS

- information_schema.DBA_OUTLINES

- information_schema.ENGINES

- information_schema.GLOBAL_STATUS

- information_schema.GLOBAL_VARIABLES

- information_schema.KEY_COLUMN_USAGE

- information_schema.PARAMETERS

- information_schema.PARTITIONS

- information_schema.PROCESSLIST

- information_schema.REFERENTIAL_CONSTRAINTS

- information_schema.ROUTINES

- information_schema.SCHEMATA

- information_schema.SCHEMA_PRIVILEGES

- information_schema.SESSION_STATUS

- information_schema.SESSION_VARIABLES

- information_schema.STATISTICS

- information_schema.TABLES

- information_schema.TABLE_CONSTRAINTS

- information_schema.TABLE_PRIVILEGES

- information_schema.USER_PRIVILEGES

- information_schema.USER_RECYCLEBIN

- information_schema.VIEWS

- oceanbase.CDB_OB_BACKUP_ARCHIVELOG_SUMMARY

- oceanbase.CDB_OB_BACKUP_JOB_DETAILS

- oceanbase.CDB_OB_BACKUP_SET_DETAILS

- oceanbase.CDB_OB_BACKUP_PROGRESS

- oceanbase.CDB_OB_BACKUP_SET_EXPIRED

- oceanbase.CDB_OB_BACKUP_ARCHIVELOG_PROGRESS

- oceanbase.CDB_OB_BACKUP_CLEAN_HISTORY

- oceanbase.CDB_OB_BACKUP_TASK_CLEAN_HISTORY

- oceanbase.CDB_OB_RESTORE_PROGRESS

- oceanbase.CDB_OB_RESTORE_HISTORY

- oceanbase.CDB_CKPT_HISTORY

- oceanbase.CDB_OB_BACKUP_VALIDATION_JOB

- oceanbase.CDB_OB_BACKUP_VALIDATION_JOB_HISTORY

- oceanbase.CDB_OB_TENANT_BACKUP_VALIDATION_TASK

- oceanbase.CDB_OB_BACKUP_VALIDATION_TASK_HISTORY

- oceanbase.CDB_OB_BACKUP_BACKUP_ARCHIVELOG_SUMMARY

- oceanbase.CDB_OB_BACKUP_BACKUPSET_TASK_HISTORY

- oceanbase.CDB_OB_BACKUP_BACKUPSET_TASK

- oceanbase.CDB_OB_BACKUP_BACKUPSET_JOB_HISTORY

- oceanbase.CDB_OB_BACKUP_BACKUPSET_JOB

- oceanbase.CDB_OB_BACKUP_SET_OBSOLETE

- 性能視圖

- gv$plan_cache_stat

- gv$plan_cache_plan_stat

- gv$session_event

- gv$session_wait

- gv$session_wait_history

- gv$system_event

- gv$sesstat

- gv$sysstat

- gv$sql_audit

- gv$latch

- gv$memory

- gv$memstore

- gv$memstore_info

- gv$plan_cache_plan_explain

- gv$obrpc_outgoing

- gv$obrpc_incoming

- gv$sql

- gv$sql_plan_monitor

- gv$outline

- gv$concurrent_limit_sql

- gv$sql_plan_statistics

- gv$server_memstore

- gv$unit_load_balance_event_history

- gv$tenant

- gv$database

- gv$table

- gv$unit

- gv$partition

- gv$lock_wait_stat

- gv$session_longops

- gv$tenant_memstore_allocator_info

- gv$minor_merge_info

- gv$tenant_px_worker_stat

- gv$partition_audit

- gv$ps_stat

- gv$ps_item_info

- gv$sql_workarea

- gv$sql_workarea_histogram

- gv$ob_sql_workarea_memory_info

- gv$server_schema_info

- gv$merge_info

- gv$lock

- gv$sstable

- gv$ob_trans_table_status

- v$statname

- v$event_name

- v$session_event

- v$session_wait

- v$session_wait_history

- v$sesstat

- v$sysstat

- v$system_event

- v$memory

- v$memstore

- v$memstore_info

- v$plan_cache_stat

- v$plan_cache_plan_stat

- v$plan_cache_plan_explain

- v$sql_audit

- v$obrpc_outgoing

- v$obrpc_incoming

- v$sql

- v$sql_monitor

- v$sql_plan_monitor

- v$sql_plan_statistics

- v$unit

- v$partition

- v$lock_wait_stat

- v$session_longops

- v$latch

- v$tenant_memstore_allocator_info

- v$tenant_px_worker_stat

- v$partition_audit

- v$ob_cluster

- v$ob_standby_status

- v$ob_cluster_stats

- v$ob_cluster_event_history

- v$ps_stat

- v$ps_item_info

- v$sql_workarea

- v$sql_workarea_active

- v$sql_workarea_histogram

- v$ob_sql_workarea_memory_info

- v$ob_timestamp_service

- v$server_schema_info

- v$merge_info

- v$lock

- v$sql_monitor_statname

- v$restore_point

- v$ob_cluster_failover_info

- v$encrypted_tables

- v$encrypted_tablespaces

- v$sstable

- v$ob_trans_table_status

- 系統變量

- 系統變量概述

- auto_increment_increment

- auto_increment_offset

- autocommit

- character_set_client

- character_set_connection

- character_set_database

- character_set_results

- character_set_server

- character_set_system

- collation_connection

- collation_database

- collation_server

- interactive_timeout

- last_insert_id

- max_allowed_packet

- sql_mode

- time_zone

- tx_isolation

- version_comment

- wait_timeout

- binlog_row_image

- character_set_filesystem

- connect_timeout

- datadir

- debug_sync

- div_precision_increment

- explicit_defaults_for_timestamp

- group_concat_max_len

- identity

- lower_case_table_names

- net_read_timeout

- net_write_timeout

- read_only

- sql_auto_is_null

- sql_select_limit

- timestamp

- tx_read_only

- version

- sql_warnings

- max_user_connections

- init_connect

- license

- net_buffer_length

- system_time_zone

- query_cache_size

- query_cache_type

- sql_quote_show_create

- max_sp_recursion_depth

- sql_safe_updates

- ob_proxy_partition_hit

- ob_log_level

- ob_max_parallel_degree

- ob_query_timeout

- ob_read_consistency

- ob_enable_transformation

- ob_trx_timeout

- ob_enable_plan_cache

- ob_enable_index_direct_select

- ob_proxy_set_trx_executed

- ob_enable_aggregation_pushdown

- ob_last_schema_version

- ob_global_debug_sync

- ob_proxy_global_variables_version

- ob_enable_trace_log

- ob_enable_hash_group_by

- ob_enable_blk_nestedloop_join

- ob_bnl_join_cache_size

- ob_org_cluster_id

- ob_plan_cache_percentage

- ob_plan_cache_evict_high_percentage

- ob_plan_cache_evict_low_percentage

- recyclebin

- ob_capability_flag

- ob_stmt_parallel_degree

- is_result_accurate

- error_on_overlap_time

- ob_compatibility_mode

- ob_create_table_strict_mode

- ob_sql_work_area_percentage

- ob_route_policy

- ob_enable_transmission_checksum

- foreign_key_checks

- ob_enable_truncate_flashback

- ob_tcp_invited_nodes

- sql_throttle_current_priority

- sql_throttle_priority

- sql_throttle_rt

- sql_throttle_network

- auto_increment_cache_size

- ob_enable_jit

- ob_timestamp_service

- plugin_dir

- undo_retention

- ob_sql_audit_percentage

- ob_enable_sql_audit

- optimizer_use_sql_plan_baselines

- optimizer_capture_sql_plan_baselines

- parallel_max_servers

- parallel_servers_target

- ob_trx_idle_timeout

- block_encryption_mode

- ob_reserved_meta_memory_percentage

- ob_check_sys_variable

- tracefile_identifier

- transaction_isolation

- ob_trx_lock_timeout

- validate_password_check_user_name

- validate_password_length

- validate_password_mixed_case_count

- validate_password_number_count

- validate_password_policy

- validate_password_special_char_count

- default_password_lifetime

- ob_trace_info

- secure_file_priv

- ob_pl_block_timeout

- performance_schema

- transaction_read_only

- resource_manager_plan

- 系統配置項

- 系統配置項概述

- auto_leader_switch_interval

- auto_delete_expired_backup

- autoinc_cache_refresh_interval

- audit_sys_operations

- audit_trail

- balancer_idle_time

- balancer_log_interval

- balancer_timeout_check_interval

- balancer_task_timeout

- balancer_tolerance_percentage

- balancer_emergency_percentage

- balance_blacklist_failure_threshold

- balance_blacklist_retry_interval

- backup_concurrency

- backup_dest

- backup_net_limit

- backup_recovery_window

- backup_region

- builtin_db_data_verify_cycle

- bf_cache_miss_count_threshold

- bf_cache_priority

- cache_wash_threshold

- clog_cache_priority

- clog_sync_time_warn_threshold

- clog_disk_usage_limit_percentage

- clog_transport_compress_all

- clog_transport_compress_func

- clog_persistence_compress_func

- clog_max_unconfirmed_log_count

- cluster

- cluster_id

- cpu_count

- cpu_quota_concurrency

- cpu_reserved

- config_additional_dir

- data_copy_concurrency

- data_dir

- datafile_disk_percentage

- dtl_buffer_size

- datafile_size

- debug_sync_timeout

- default_compress_func

- default_compress

- default_progressive_merge_num

- default_row_format

- devname

- data_disk_usage_limit_percentage

- disk_io_thread_count

- dead_socket_detection_timeout

- enable_clog_persistence_compress

- election_cpu_quota

- enable_one_phase_commit

- enable_sys_unit_standalone

- enable_pg

- enable_smooth_leader_switch

- election_blacklist_interval

- enable_election_group

- enable_auto_leader_switch

- enable_global_freeze_trigger

- enable_manual_merge

- enable_merge_by_turn

- enable_perf_event

- enable_rebalance

- enable_record_trace_log

- enable_record_trace_id

- enable_early_lock_release

- enable_rereplication

- enable_rich_error_msg

- enable_rootservice_standalone

- enable_sql_audit

- enable_sql_operator_dump

- enable_async_syslog

- enable_syslog_recycle

- enable_syslog_wf

- enable_upgrade_mode

- enable_separate_sys_clog

- enable_ddl

- enable_major_freeze

- enable_rebuild_on_purpose

- enable_log_archive

- enable_monotonic_weak_read

- external_kms_info

- freeze_trigger_percentage

- flush_log_at_trx_commit

- fuse_row_cache_priority

- force_refresh_location_cache_interval

- force_refresh_location_cache_threshold

- get_leader_candidate_rpc_timeout

- global_major_freeze_residual_memory

- global_write_halt_residual_memory

- ignore_replay_checksum_error

- global_index_build_single_replica_timeout

- high_priority_net_thread_count

- ignore_replica_checksum_error

- ignore_replay_checksum_error

- index_cache_priority

- index_clog_cache_priority

- index_info_block_cache_priority

- internal_sql_execute_timeout

- large_query_worker_percentage

- large_query_threshold

- leak_mod_to_check

- lease_time

- location_cache_cpu_quota

- location_cache_expire_time

- location_cache_priority

- location_cache_refresh_min_interval

- location_fetch_concurrency

- location_refresh_thread_count

- log_archive_checkpoint_interval

- log_archive_concurrency

- log_restore_concurrency

- major_freeze_duty_time

- max_kept_major_version_number

- max_string_print_length

- max_syslog_file_count

- merge_stat_sampling_ratio

- major_compact_trigger

- memory_chunk_cache_size

- memory_limit

- memory_limit_percentage

- memory_reserved

- merge_thread_count

- merger_check_interval

- merger_completion_percentage

- merger_switch_leader_duration_time

- merger_warm_up_duration_time

- max_px_worker_count

- migration_disable_time

- min_observer_version

- minor_deferred_gc_time

- minor_freeze_times

- minor_warm_up_duration_time

- mysql_port

- minor_merge_concurrency

- multiblock_read_gap_size

- multiblock_read_size

- micro_block_merge_verify_level

- migrate_concurrency

- minor_compact_trigger

- memstore_limit_percentage

- net_thread_count

- obconfig_url

- ob_enable_batched_multi_statement

- partition_table_check_interval

- partition_table_scan_batch_count

- plan_cache_evict_interval

- px_task_size

- px_workers_per_cpu_quota

- replica_safe_remove_time

- resource_hard_limit

- resource_soft_limit

- rootservice_async_task_queue_size

- rootservice_async_task_thread_count

- rootservice_list

- rootservice_ready_check_interval

- row_compaction_update_limit

- row_purge_thread_count

- rpc_port

- rpc_timeout

- restore_concurrency

- rootservice_memory_limit

- rebuild_replica_data_lag_threshold

- schema_history_expire_time

- ssl_client_authentication

- server_check_interval

- server_data_copy_in_concurrency

- server_data_copy_out_concurrency

- server_permanent_offline_time

- stack_size

- server_balance_critical_disk_waterlevel

- server_balance_disk_tolerance_percent

- system_memory

- server_balance_cpu_mem_tolerance_percent

- server_cpu_quota_max

- server_cpu_quota_min

- sql_audit_memory_limit

- sys_bkgd_io_high_percentage

- sys_bkgd_io_low_percentage

- sys_bkgd_io_timeout

- sys_bkgd_net_percentage

- sys_bkgd_migration_change_member_list_timeout

- sys_bkgd_migration_retry_num

- syslog_level

- switchover_process_thread_count

- system_cpu_quota

- sys_cpu_limit_trigger

- syslog_io_bandwidth_limit

- tablet_size

- tableapi_transport_compress_func

- tenant_task_queue_size

- tenant_groups

- trace_log_slow_query_watermark

- trace_log_sampling_interval

- trx_2pc_retry_interval

- trx_force_kill_threshold

- tde_method

- token_reserved_percentage

- unit_balance_resource_weight

- user_block_cache_priority

- user_row_cache_priority

- user_tab_col_stat_cache_priority

- user_iort_up_percentage

- use_large_pages

- virtual_table_location_cache_expire_time

- workers_per_cpu_quota

- wait_leader_batch_count

- writing_throttling_maximum_duration

- writing_throttling_trigger_percentage

- weak_read_version_refresh_interval

- workarea_size_policy

- zone

- zone_merge_concurrency

- zone_merge_order

- zone_merge_timeout

- ob_ssl_invited_common_names

- ssl_external_kms_info

- ob_event_history_recycle_interval

- backup_log_archive_checkpoint_interval

- plsql_ccflags

- plsql_code_type

- plsql_debug

- plsql_optimize_level

- plsql_v2_compatibility

- plsql_warnings

- recyclebin_object_expire_time

- log_archive_batch_buffer_limit

- clog_disk_utilization_threshold

- backup_backup_archive_log_batch_count

- backup_backup_archivelog_retry_interval

- backup_backupset_batch_count

- backup_backupset_retry_interval

- open_cursors

- fast_recovery_concurrency

- 預留關鍵字

- 部署實踐

- 設置無密碼 SSH 登錄

- 單機安裝

- 本地安裝

- 分布式安裝

- 創建租戶

- OceanBaseDeploy(OBD)常用命令

- 大數據

- 數據倉庫分層

- 數據倉庫分層實踐

- hive安裝

- hive命令

- hadoop安裝

- jdk安裝

- 應龍inlong

- 網關

- apisix

- apisix2.7源碼安裝

- apisix rpm2.6安裝

- apisix-dashboard2.7 rpm安裝

- apisix-dashboard使用

- apisix-dashboard進階