## 把分類網絡修改為語義分割的網絡存在下面問題:

1. 分辨率變小(the reduction of signal

resolution incurred by the repeated combination of max-pooling and downsampling (‘striding’) performed at every layer of standard DCNNs)

2. spatial ‘insensitivity’ (invariance)。(relates to the fact that obtaining object-centric decisions from a classifier requires invariance to spatial transformations, inherently limiting the spatial accuracy of the DCNN

model)-- This is

due to the very invariance properties that make DCNNs good for high level tasks

*****

我們來看FCN怎么來解決這兩個問題的?

### 第一個問題解決思路:

2014年,加州大學伯克利分校的Long等人提出的**完全卷積網絡(Fully Convolutional Networks)**,推廣了原有的CNN結構,**在不帶有全連接層的情況下能進行密集預測。**然后使用反卷積層來恢復圖像的分辨率

這種結構的提出使得分割圖譜可以生成任意大小的圖像,且與圖像塊分類方法相比,也提高了處理速度。在后來,幾乎所有關于語義分割的最新研究都采用了這種結構。

### 第二個問題解決思路:

使用了skip結構來結合底層特征和高層特征,來提高圖像的分割精度

*****

### FCN總覽:

論文:

Fully Convolutional Networks for Semantic Segmentation

于2014年11月14日提交到arvix

[https://arxiv.org/abs/1411.4038](http://link.zhihu.com/?target=https%3A//arxiv.org/abs/1411.4038)

主要貢獻:

* 將端到端的卷積網絡推廣到語義分割中;

* 重新將預訓練好的Imagenet網絡用于分割問題中;

* 使用反卷積層進行上采樣;

* 提出了跳躍連接來改善上采樣的粗糙程度。

具體解釋:

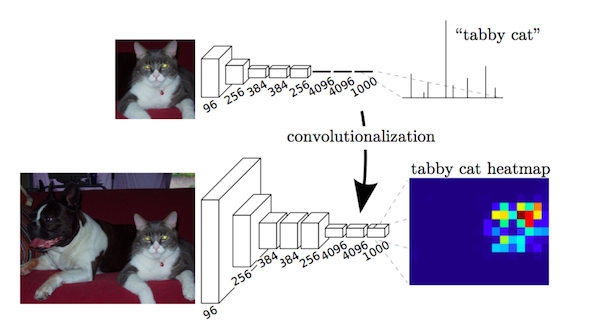

本文的關鍵在于:分類網絡中的全連接層可以看作是使用卷積核遍歷整個輸入區域的卷積操作。

這相當于在重疊的輸入圖像塊上評估原始的分類網絡,但是與先前相比計算效率更高,因為在圖像塊重疊區域,共享計算結果。

盡管這種方法并不是這篇文章中所特有的,還有一篇關于overfeat的文章也使用了這種思想,但是確實顯著提高了在VOC2012數據集上的實際效果。

**△**用卷積運算實現的全連接層結構

在將VGG等預訓練網絡模型的全連接層卷積化之后,由于CNN網絡中的池化操作,得到的特征圖譜仍需進行上采樣。

反卷積層在進行上采樣時,不是使用簡單的雙線性插值,而是通過學習實現插值操作。此網絡層也被稱為上卷積、完全卷積、轉置卷積或是分形卷積。

然而,由于在池化操作中丟失部分信息,使得即使加上反卷積層的上采樣操作也會產生粗糙的分割圖。因此,本文還從高分辨率特性圖譜中引入了跳躍連接方式。

個人評論:

本文的研究貢獻非常重要,但是最新的研究已經很大程度地改進了這個結果。

> 最后我們給出一個對FCN理解我認為很到位的兩個連接:https://blog.csdn.net/DL_CreepingBird/article/details/78574059

> https://blog.csdn.net/DL_CreepingBird/article/details/78574059

- 序言

- 第一章 機器學習概述

- 第二章 機器學習環境搭建

- 環境搭建

- 第三章 機器學習之基礎算法

- 第一節:基礎知識

- 第二節:k近鄰算法

- 第三節:決策樹算法

- 第四節:樸素貝葉斯

- 第五節:邏輯斯蒂回歸

- 第六節:支持向量機

- 第四章 機器學習之深度學習算法

- 第一節: CNN

- 4.1.1 CNN介紹

- 4.1.2 CNN反向傳播

- 4.1.3 DNN實例

- 4.1.4 CNN實例

- 第五章 機器學習論文與實踐

- 第一節: 語義分割

- 5.1 FCN

- 5.1.1 FCN--------實現FCN16S

- 5.1.2 FCN--------優化FCN16S

- 5.2 DeepLab

- 5.2.1 DeepLabv2

- 第六章 機器學習在實際項目中的應用