. 設想一個場景:有100萬用戶同時與一個進程保持著TCP連接,而每一時刻只有幾十個或幾百個TCP連接是活躍的(接收TCP包),也就是說在每一時刻進程只需要處理這100萬連接中的一小部分連接。那么,如何才能高效的處理這種場景呢?進程是否在每次詢問操作系統收集有事件發生的TCP連接時,把這100萬個連接告訴操作系統,然后由操作系統找出其中有事件發生的幾百個連接呢?實際上,在Linux2.4版本以前,那時的select或者poll事件驅動方式是這樣做的。

.??這里有個非常明顯的問題,即在某一時刻,進程收集有事件的連接時,其實這100萬連接中的大部分都是沒有事件發生的。因此如果每次收集事件時,都把100萬連接的套接字傳給操作系統(**這首先是用戶態內存到內核態內存的大量復制**),而由操作系統內核尋找這些連接上有沒有未處理的事件,將會是巨大的資源浪費,然后select和poll就是這樣做的,因此它們最多只能處理幾千個并發連接。而epoll不這樣做,它在Linux內核中申請了一個簡易的文件系統,把原先的一個select或poll調用分成了3部分:

~~~cpp

int epoll_create(int size);

int epoll_ctl(int epfd, int op, int fd, struct epoll_event *event);

int epoll_wait(int epfd, struct epoll_event *events,int maxevents, int timeout);

~~~

1\. 調用epoll\_create建立一個epoll對象(在epoll文件系統中給這個句柄分配資源);

2\. 調用epoll\_ctl向epoll對象中添加這100萬個連接的套接字;

3\. 調用epoll\_wait收集發生事件的連接。

??這樣只需要在進程啟動時建立1個epoll對象,并在需要的時候向它添加或刪除連接就可以了,因此,在實際收集事件時,epoll\_wait的效率就會非常高,因為調用epoll\_wait時并沒有向它傳遞這100萬個連接,內核也不需要去遍歷全部的連接。

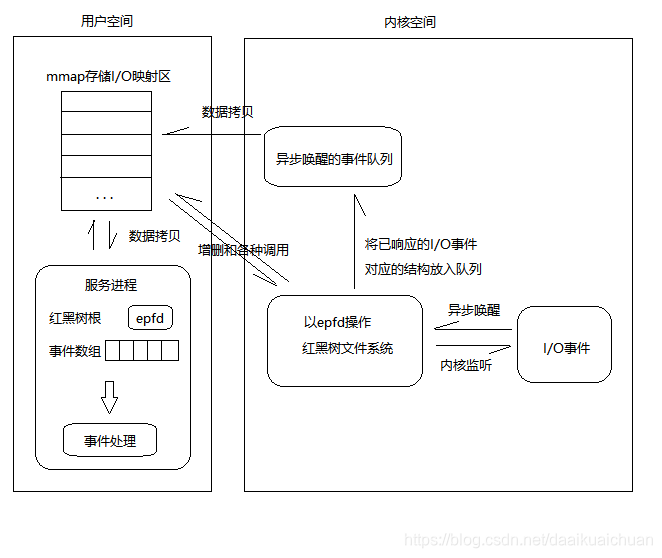

## 一、epoll原理詳解

??當某一進程調用epoll\_create方法時,Linux內核會創建一個eventpoll結構體,這個結構體中有兩個成員與epoll的使用方式密切相關,如下所示:

~~~cpp

struct eventpoll {

...

/*紅黑樹的根節點,這棵樹中存儲著所有添加到epoll中的事件,

也就是這個epoll監控的事件*/

struct rb_root rbr;

/*雙向鏈表rdllist保存著將要通過epoll_wait返回給用戶的、滿足條件的事件*/

struct list_head rdllist;

...

};

~~~

??我們在**調用epoll\_create**時,內核除了幫我們在epoll文件系統里建了個file結點,**在內核cache里建了個紅黑樹**用于存儲以后epoll\_ctl傳來的socket外,**還會再建立一個rdllist雙向鏈表,用于存儲準備就緒的事件**,**當epoll\_wait調用時,僅僅觀察這個rdllist雙向鏈表里有沒有數據即可。有數據就返回**,沒有數據就sleep,等到timeout時間到后即使鏈表沒數據也返回。所以,epoll\_wait非常高效。

??所有添加到epoll中的事件都會與設備(如網卡)驅動程序**建立回調關系**,也就是說相應事件的發生時會調用這里的回調方法。這個回調方法在內核中叫做**ep\_poll\_callback**,它會把這樣的事件放到上面的rdllist雙向鏈表中。

??在epoll中對于每一個事件都會建立一個epitem結構體,如下所示:

~~~cpp

struct epitem {

...

//紅黑樹節點

struct rb_node rbn;

//雙向鏈表節點

struct list_head rdllink;

//事件句柄等信息

struct epoll_filefd ffd;

//指向其所屬的eventepoll對象

struct eventpoll *ep;

//期待的事件類型

struct epoll_event event;

...

}; // 這里包含每一個事件對應著的信息。

~~~

??當調用epoll\_wait檢查是否有發生事件的連接時,只是檢查eventpoll對象中的**rdllist雙向鏈表是否有epitem元素**而已,如果rdllist鏈表不為空,則這里的事件復制到用戶態內存(使用共享內存提高效率)中,同時將事件數量返回給用戶。因此epoll\_waitx效率非常高。epoll\_ctl在向epoll對象中添加、修改、刪除事件時,從rbr紅黑樹中查找事件也非常快,也就是說epoll是非常高效的,它可以輕易地處理百萬級別的并發連接。

【**總結**】:

??**一顆紅黑樹,一張準備就緒句柄鏈表**,少量的內核cache,就幫我們解決了大并發下的socket處理問題。

* 執行epoll\_create()時,創建了紅黑樹和就緒鏈表;

* 執行epoll\_ctl()時,如果增加socket句柄,則檢查在紅黑樹中是否存在,存在立即返回,不存在則添加到樹干上,然后向內核注冊回調函數,用于當中斷事件來臨時向準備就緒鏈表中插入數據;

* 執行epoll\_wait()時立刻返回準備就緒鏈表里的數據即可。

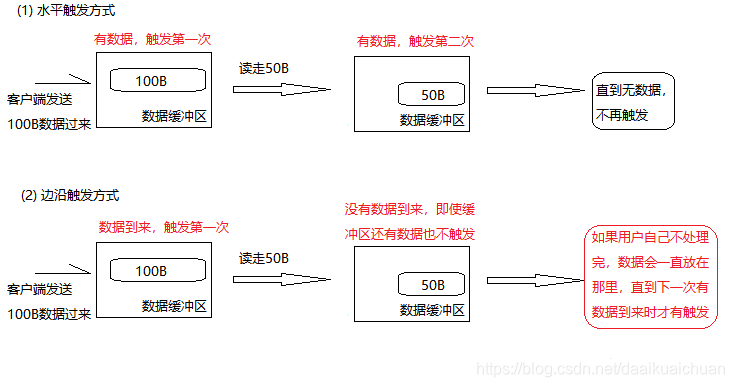

## 二、epoll的兩種觸發模式

??epoll有EPOLLLT和EPOLLET兩種觸發模式,LT是默認的模式,ET是“高速”模式。

* LT(水平觸發)模式下,只**要這個文件描述符還有數據可讀,每次 epoll\_wait都會返回它的事件**,提醒用戶程序去操作;

* ET(邊緣觸發)模式下,在它檢測到有 I/O 事件時,通過 epoll\_wait 調用會得到有事件通知的文件描述符,**對于每一個被通知的文件描述符,如可讀,則必須將該文件描述符一直讀到空**,讓 errno 返回 EAGAIN 為止,否則下次的 epoll\_wait 不會返回余下的數據,會丟掉事件。如果ET模式不是非阻塞的,那這個一直讀或一直寫勢必會在最后一次阻塞。

??還有一個特點是,epoll使用“事件”的就緒通知方式,通過epoll\_ctl注冊fd,一旦該fd就緒,內核就會采用類似callback的回調機制來激活該fd,epoll\_wait便可以收到通知。

【epoll為什么要有EPOLLET觸發模式?】:

??如果采用EPOLLLT模式的話,**系統中一旦有大量你不需要讀寫的就緒文件描述符,它們每次調用epoll\_wait都會返回**,這樣會大大降低處理程序檢索自己關心的就緒文件描述符的效率.。而采用EPOLLET這種邊緣觸發模式的話,當被監控的文件描述符上有可讀寫事件發生時,epoll\_wait()會通知處理程序去讀寫。如果這次沒有把數據全部讀寫完(如讀寫緩沖區太小),那么下次調用epoll\_wait()時,它不會通知你,也就是它只會通知你一次,直到該文件描述符上出現第二次可讀寫事件才會通知你!!!這種模式比水平觸發效率高,系統不會充斥大量你不關心的就緒文件描述符。

【**總結**】:

* ET模式(邊緣觸發)**只有數據到來才觸發**,**不管緩存區中是否還有數據**,緩沖區剩余未讀盡的數據不會導致epoll\_wait返回;

* LT 模式(水平觸發,默認)**只要有數據都會觸發**,緩沖區剩余未讀盡的數據會導致epoll\_wait返回。

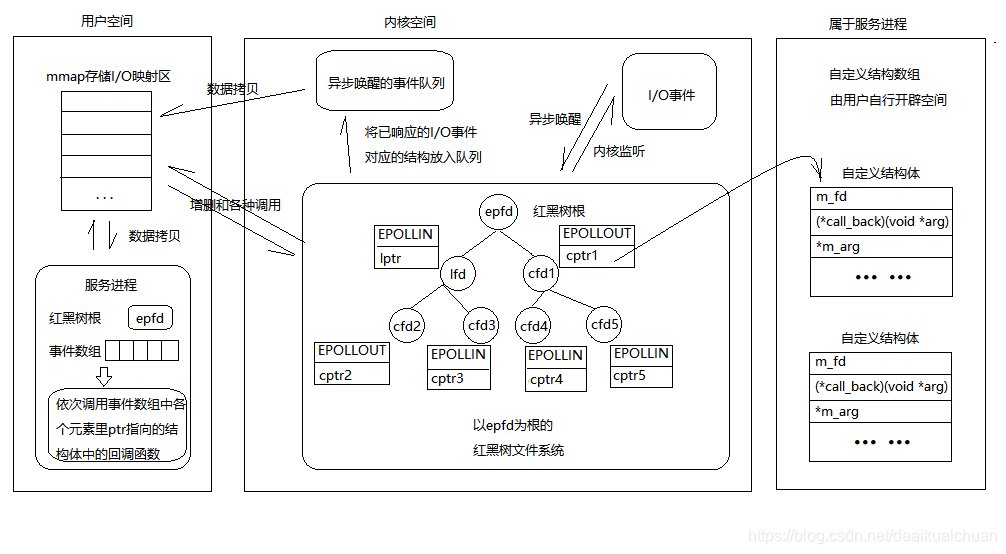

## 三、epoll反應堆模型

【epoll模型原來的流程】:

~~~

epoll_create(); // 創建監聽紅黑樹

epoll_ctl(); // 向書上添加監聽fd

epoll_wait(); // 監聽

有監聽fd事件發送--->返回監聽滿足數組--->判斷返回數組元素--->

lfd滿足accept--->返回cfd---->read()讀數據--->write()給客戶端回應。

~~~

【epoll反應堆模型的流程】:

~~~

epoll_create(); // 創建監聽紅黑樹

epoll_ctl(); // 向書上添加監聽fd

epoll_wait(); // 監聽

有客戶端連接上來--->lfd調用acceptconn()--->將cfd掛載到紅黑樹上監聽其讀事件--->

epoll_wait()返回cfd--->cfd回調recvdata()--->將cfd摘下來監聽寫事件--->

epoll_wait()返回cfd--->cfd回調senddata()--->將cfd摘下來監聽讀事件--->...--->

~~~

【Demo】:

~~~cpp

#include <stdio.h>

#include <sys/socket.h>

#include <sys/epoll.h>

#include <arpa/inet.h>

#include <fcntl.h>

#include <unistd.h>

#include <errno.h>

#include <string.h>

#include <stdlib.h>

#include <time.h>

#define MAX_EVENTS 1024 /*監聽上限*/

#define BUFLEN 4096 /*緩存區大小*/

#define SERV_PORT 6666 /*端口號*/

void recvdata(int fd,int events,void *arg);

void senddata(int fd,int events,void *arg);

/*描述就緒文件描述符的相關信息*/

struct myevent_s

{

int fd; //要監聽的文件描述符

int events; //對應的監聽事件,EPOLLIN和EPLLOUT

void *arg; //指向自己結構體指針

void (*call_back)(int fd,int events,void *arg); //回調函數

int status; //是否在監聽:1->在紅黑樹上(監聽), 0->不在(不監聽)

char buf[BUFLEN];

int len;

long last_active; //記錄每次加入紅黑樹 g_efd 的時間值

};

int g_efd; //全局變量,作為紅黑樹根

struct myevent_s g_events[MAX_EVENTS+1]; //自定義結構體類型數組. +1-->listen fd

/*

* 封裝一個自定義事件,包括fd,這個fd的回調函數,還有一個額外的參數項

* 注意:在封裝這個事件的時候,為這個事件指明了回調函數,一般來說,一個fd只對一個特定的事件

* 感興趣,當這個事件發生的時候,就調用這個回調函數

*/

void eventset(struct myevent_s *ev, int fd, void (*call_back)(int fd,int events,void *arg), void *arg)

{

ev->fd = fd;

ev->call_back = call_back;

ev->events = 0;

ev->arg = arg;

ev->status = 0;

if(ev->len <= 0)

{

memset(ev->buf, 0, sizeof(ev->buf));

ev->len = 0;

}

ev->last_active = time(NULL); //調用eventset函數的時間

return;

}

/* 向 epoll監聽的紅黑樹 添加一個文件描述符 */

void eventadd(int efd, int events, struct myevent_s *ev)

{

struct epoll_event epv={0, {0}};

int op = 0;

epv.data.ptr = ev; // ptr指向一個結構體(之前的epoll模型紅黑樹上掛載的是文件描述符cfd和lfd,現在是ptr指針)

epv.events = ev->events = events; //EPOLLIN 或 EPOLLOUT

if(ev->status == 0) //status 說明文件描述符是否在紅黑樹上 0不在,1 在

{

op = EPOLL_CTL_ADD; //將其加入紅黑樹 g_efd, 并將status置1

ev->status = 1;

}

if(epoll_ctl(efd, op, ev->fd, &epv) < 0) // 添加一個節點

printf("event add failed [fd=%d],events[%d]\n", ev->fd, events);

else

printf("event add OK [fd=%d],events[%0X]\n", ev->fd, events);

return;

}

/* 從epoll 監聽的 紅黑樹中刪除一個文件描述符*/

void eventdel(int efd,struct myevent_s *ev)

{

struct epoll_event epv = {0, {0}};

if(ev->status != 1) //如果fd沒有添加到監聽樹上,就不用刪除,直接返回

return;

epv.data.ptr = NULL;

ev->status = 0;

epoll_ctl(efd, EPOLL_CTL_DEL, ev->fd, &epv);

return;

}

/* 當有文件描述符就緒, epoll返回, 調用該函數與客戶端建立鏈接 */

void acceptconn(int lfd,int events,void *arg)

{

struct sockaddr_in cin;

socklen_t len = sizeof(cin);

int cfd, i;

if((cfd = accept(lfd, (struct sockaddr *)&cin, &len)) == -1)

{

if(errno != EAGAIN && errno != EINTR)

{

sleep(1);

}

printf("%s:accept,%s\n",__func__, strerror(errno));

return;

}

do

{

for(i = 0; i < MAX_EVENTS; i++) //從全局數組g_events中找一個空閑元素,類似于select中找值為-1的元素

{

if(g_events[i].status ==0)

break;

}

if(i == MAX_EVENTS) // 超出連接數上限

{

printf("%s: max connect limit[%d]\n", __func__, MAX_EVENTS);

break;

}

int flag = 0;

if((flag = fcntl(cfd, F_SETFL, O_NONBLOCK)) < 0) //將cfd也設置為非阻塞

{

printf("%s: fcntl nonblocking failed, %s\n", __func__, strerror(errno));

break;

}

eventset(&g_events[i], cfd, recvdata, &g_events[i]); //找到合適的節點之后,將其添加到監聽樹中,并監聽讀事件

eventadd(g_efd, EPOLLIN, &g_events[i]);

}while(0);

printf("new connect[%s:%d],[time:%ld],pos[%d]",inet_ntoa(cin.sin_addr), ntohs(cin.sin_port), g_events[i].last_active, i);

return;

}

/*讀取客戶端發過來的數據的函數*/

void recvdata(int fd, int events, void *arg)

{

struct myevent_s *ev = (struct myevent_s *)arg;

int len;

len = recv(fd, ev->buf, sizeof(ev->buf), 0); //讀取客戶端發過來的數據

eventdel(g_efd, ev); //將該節點從紅黑樹上摘除

if (len > 0)

{

ev->len = len;

ev->buf[len] = '\0'; //手動添加字符串結束標記

printf("C[%d]:%s\n", fd, ev->buf);

eventset(ev, fd, senddata, ev); //設置該fd對應的回調函數為senddata

eventadd(g_efd, EPOLLOUT, ev); //將fd加入紅黑樹g_efd中,監聽其寫事件

}

else if (len == 0)

{

close(ev->fd);

/* ev-g_events 地址相減得到偏移元素位置 */

printf("[fd=%d] pos[%ld], closed\n", fd, ev-g_events);

}

else

{

close(ev->fd);

printf("recv[fd=%d] error[%d]:%s\n", fd, errno, strerror(errno));

}

return;

}

/*發送給客戶端數據*/

void senddata(int fd, int events, void *arg)

{

struct myevent_s *ev = (struct myevent_s *)arg;

int len;

len = send(fd, ev->buf, ev->len, 0); //直接將數據回射給客戶端

eventdel(g_efd, ev); //從紅黑樹g_efd中移除

if (len > 0)

{

printf("send[fd=%d], [%d]%s\n", fd, len, ev->buf);

eventset(ev, fd, recvdata, ev); //將該fd的回調函數改為recvdata

eventadd(g_efd, EPOLLIN, ev); //重新添加到紅黑樹上,設為監聽讀事件

}

else

{

close(ev->fd); //關閉鏈接

printf("send[fd=%d] error %s\n", fd, strerror(errno));

}

return ;

}

/*創建 socket, 初始化lfd */

void initlistensocket(int efd, short port)

{

struct sockaddr_in sin;

int lfd = socket(AF_INET, SOCK_STREAM, 0);

fcntl(lfd, F_SETFL, O_NONBLOCK); //將socket設為非阻塞

memset(&sin, 0, sizeof(sin)); //bzero(&sin, sizeof(sin))

sin.sin_family = AF_INET;

sin.sin_addr.s_addr = INADDR_ANY;

sin.sin_port = htons(port);

bind(lfd, (struct sockaddr *)&sin, sizeof(sin));

listen(lfd, 20);

/* void eventset(struct myevent_s *ev, int fd, void (*call_back)(int, int, void *), void *arg); */

eventset(&g_events[MAX_EVENTS], lfd, acceptconn, &g_events[MAX_EVENTS]);

/* void eventadd(int efd, int events, struct myevent_s *ev) */

eventadd(efd, EPOLLIN, &g_events[MAX_EVENTS]); //將lfd添加到監聽樹上,監聽讀事件

return;

}

int main()

{

int port=SERV_PORT;

g_efd = epoll_create(MAX_EVENTS + 1); //創建紅黑樹,返回給全局 g_efd

if(g_efd <= 0)

printf("create efd in %s err %s\n", __func__, strerror(errno));

initlistensocket(g_efd, port); //初始化監聽socket

struct epoll_event events[MAX_EVENTS + 1]; //定義這個結構體數組,用來接收epoll_wait傳出的滿足監聽事件的fd結構體

printf("server running:port[%d]\n", port);

int checkpos = 0;

int i;

while(1)

{

/* long now = time(NULL);

for(i=0; i < 100; i++, checkpos++)

{

if(checkpos == MAX_EVENTS);

checkpos = 0;

if(g_events[checkpos].status != 1)

continue;

long duration = now -g_events[checkpos].last_active;

if(duration >= 60)

{

close(g_events[checkpos].fd);

printf("[fd=%d] timeout\n", g_events[checkpos].fd);

eventdel(g_efd, &g_events[checkpos]);

}

} */

//調用eppoll_wait等待接入的客戶端事件,epoll_wait傳出的是滿足監聽條件的那些fd的struct epoll_event類型

int nfd = epoll_wait(g_efd, events, MAX_EVENTS+1, 1000);

if (nfd < 0)

{

printf("epoll_wait error, exit\n");

exit(-1);

}

for(i = 0; i < nfd; i++)

{

//evtAdd()函數中,添加到監聽樹中監聽事件的時候將myevents_t結構體類型給了ptr指針

//這里epoll_wait返回的時候,同樣會返回對應fd的myevents_t類型的指針

struct myevent_s *ev = (struct myevent_s *)events[i].data.ptr;

//如果監聽的是讀事件,并返回的是讀事件

if((events[i].events & EPOLLIN) &&(ev->events & EPOLLIN))

{

ev->call_back(ev->fd, events[i].events, ev->arg);

}

//如果監聽的是寫事件,并返回的是寫事件

if((events[i].events & EPOLLOUT) && (ev->events & EPOLLOUT))

{

ev->call_back(ev->fd, events[i].events, ev->arg);

}

}

}

return 0;

}

~~~

參考:[https://blog.csdn.net/qq\_36359022/article/details/81355897](https://blog.csdn.net/qq_36359022/article/details/81355897)

[https://blog.csdn.net/weixin\_40204595/article/details/83213332](https://blog.csdn.net/weixin_40204595/article/details/83213332)

[http://www.cnblogs.com/pluser/p/epoll\_principles.html](http://www.cnblogs.com/pluser/p/epoll_principles.html)

[https://www.cnblogs.com/aspirant/p/9166944.html](https://www.cnblogs.com/aspirant/p/9166944.html)

- 前言

- 服務器開發設計

- Reactor模式

- 一種心跳,兩種設計

- 聊聊 TCP 長連接和心跳那些事

- 學習TCP三次握手和四次揮手

- Linux基礎

- Linux的inode的理解

- 異步IO模型介紹

- 20個最常用的GCC編譯器參數

- epoll

- epoll精髓

- epoll原理詳解及epoll反應堆模型

- epoll的坑

- epoll的本質

- socket的SO_REUSEADDR參數全面分析

- 服務器網絡

- Protobuf

- Protobuf2 語法指南

- 一種自動反射消息類型的 Protobuf 網絡傳輸方案

- 微服務

- RPC框架

- 什么是RPC

- 如何科學的解釋RPC

- RPC 消息協議

- 實現一個極簡版的RPC

- 一個基于protobuf的極簡RPC

- 如何基于protobuf實現一個極簡版的RPC

- 開源RPC框架

- thrift

- grpc

- brpc

- Dubbo

- 服務注冊,發現,治理

- Redis

- Redis發布訂閱

- Redis分布式鎖

- 一致性哈希算法

- Redis常見問題

- Redis數據類型

- 緩存一致性

- LevelDB

- 高可用

- keepalived基本理解

- keepalived操做

- LVS 學習

- 性能優化

- Linux服務器程序性能優化方法

- SRS性能(CPU)、內存優化工具用法

- centos6的性能分析工具集合

- CentOS系統性能工具 sar 示例!

- Linux性能監控工具集sysstat

- gdb相關

- Linux 下如何產生core文件(core dump設置)