[TOC]

## 單選題

1-5 BCBBA

6-10 BCACB

11-15 BABCC

16-20 AACBC

21-25 ADCCB

26-30 ADCCA

31-35 ACBBD

36-40 BA(AC)AB

## 多選題

1.AB

2.ABCD

3.ACD

4.BC

5.ABD

6.ACD

7.ACD

8.BCD

## 填空題

1.DataFrame   Series

2.信息增益率  基尼指數

3.頻繁項集的獲取   強關系規則的發現

4.回歸  分類

5.松弛系數   核函數

6.梯度下降  最小二乘法

7.單詞計數向量  TF-IDF

8. Eps   MinPts

9.特征的類條件獨立假設

10.fit   transform

11.標簽編碼  獨熱編碼

12.離散   連續

13.ceof_   feature_importances

14.用戶   物品

15.梯度下降   最小二乘法

16.歐式距離   曼哈頓距離  閔科夫斯基距離

## 綜合題

### 1.K-means算法步驟:

(1)為每個聚類選擇一個初始聚類中心;

(2)將樣本集按照最小距離原則分配到最鄰近聚類;

(3)使用每個聚類的樣本均值更新聚類中心;

(4)重復步驟(2)、(3),直到聚類中心不再發生變化;

(5)輸出最終的聚類中心和k個簇劃分;

**缺點與改進**:

(1)對于不是凸的數據集比較難收斂(改進:基于密度的聚類算法更加適合,比如DESCAN算法)

(2)對噪音和異常點比較的敏感(改進1:離群點檢測的LOF算法,通過去除離群點后再聚類,可以減少離群點和孤立點對于聚類效果的影響;改進2:改成求點的中位數,這種聚類方式即K-Mediods聚類(K中值))。

(3)初始聚類中心的選擇(改進1:k-means++;改進2:二分K-means)

### 2.KNN算法的步驟:

1)計算已知類別數據集中的點與當前點的距離;

2)按距離遞增次序排序;

3)選取與當前點距離最小的k個點;

4)統計前k個點所在的類別出現的頻率;

5)返回前k個點出現頻率最高的類別作為當前點的預測分類;

### 3.四個分類算法,簡單介紹算法原理

1)K鄰近算法(KNN):?所謂K最近鄰,就是k個最近的鄰居的意思,說的是每個樣本都可以用它最接近的k個鄰居來代表

2)決策樹:找到具有決定性作用的特征,根據其決定性作用最大的那個特征作為根節點,然后遞歸找到各分支下子數據集中次大的決定性特征,直至子數據集中所有數據都屬于同一類。

3)樸素貝葉斯:對于給出的待分類項,求解在此項出現的個條件各個類別出現的概率,哪個最大,就認為此分類項屬于哪個類別。

4)支持向量機:是尋找一個超平面來對樣本進行 分割,分割的原則是間隔最大化,最終轉化為一個凸二次規劃問題來求解

### 4.下表給出了一組數據的相似矩陣

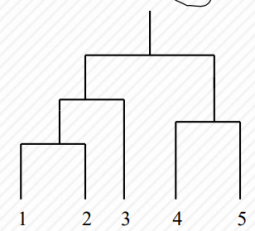

1).使用單鏈接(MIN)方式進行層次聚類,請畫出對應的樹狀圖。

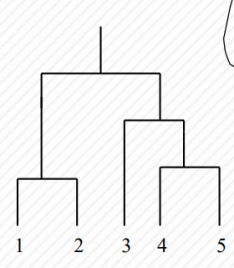

2). 使用全鏈接(MAX)方式進行層次聚類,請畫出對應的樹狀圖。

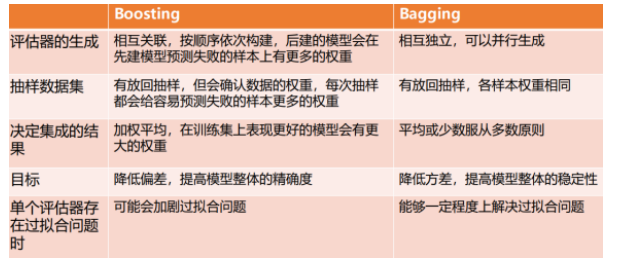

### 5. 請對比分析boosting和bagging。

### 6. 請簡述數據挖掘的整個過程。

商業理解、數據理解、數據準備 建模 評價 部署

### 7. 請談談你對特征工程的理解。

最大限度地從原始數據進行預處理然后從中提取特征以供算法和模型使用

### 8. 請簡述什么是過擬合問題、產生的原因有哪些以及解決過擬合的辦法。

什么是過擬合問題:

過擬合是指模型過分的擬合訓練樣本,但對測試樣本預測準確率不高的情況,也就是說模型泛化能力很差

原因:

(1)數據特征的角度

數據噪聲導致的過擬合?

缺乏代表性樣本導致的過擬合:

(2)模型的角度

模型過度復雜,

過擬合的可能解決方法:

a、減少特征:

b、正則化:

c、得到更多的訓練樣本

d、遷移學習\-----可以解決由于訓練數據較小引起的過擬合。