## 概述

在 Spring Cloud Netflix 階段我們采用 Eureka 做作為我們的服務注冊與發現服務器,現利用 Spring Cloud Alibaba 提供的 Nacos 組件替代該方案。

[Nacos 官網](https://nacos.io/zh-cn/)

## 什么是 Nacos

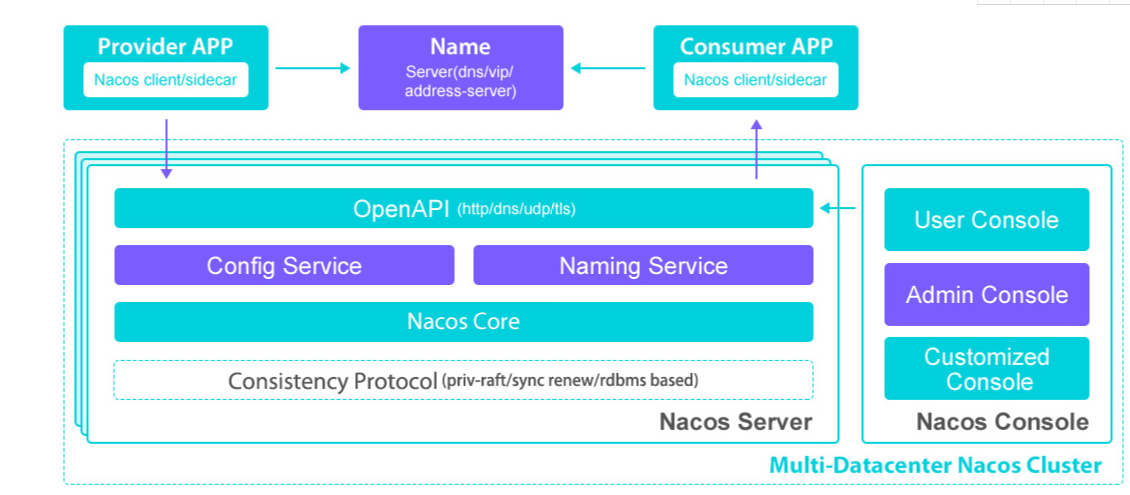

Nacos是一款比較新的技術產品,在2018年7月開源,它致力于發現、配置和管理微服務,可以作為服務的注冊中心和配置中心。Nacos?提供了一組簡單易用的特性集,以“服務”為中心,能夠提供快速實現動態服務發現、服務配置、服務元數據及流量管理能力。

## Nacos數據模型

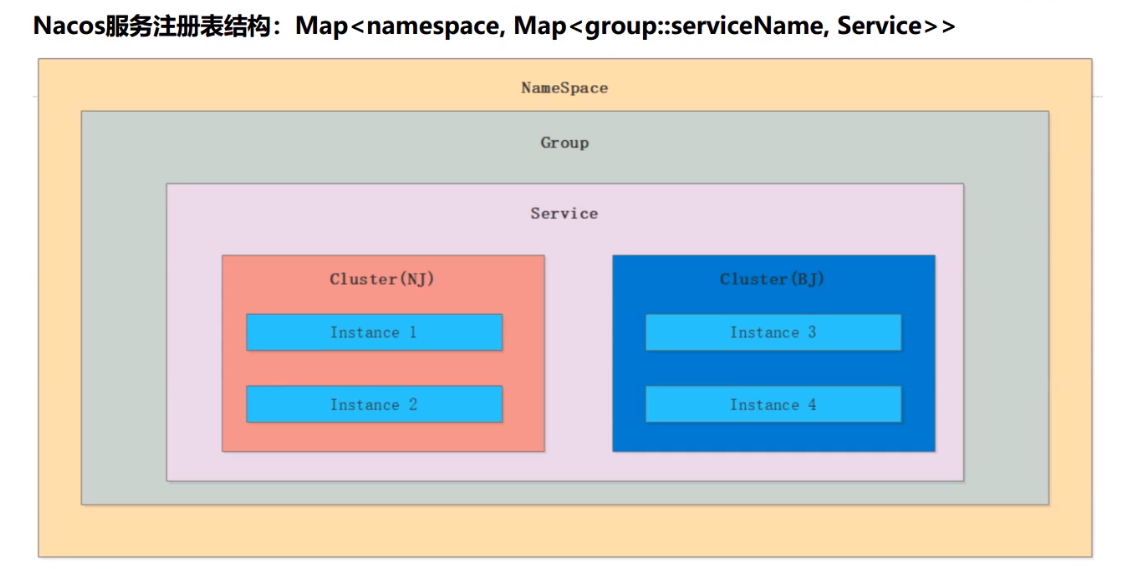

在Nacos的架構中有一個名字服務?(Naming?Service),提供了分布式系統中所有對象(Object)、實體(Entity)的“名字”到關聯的元數據之間的映射管理服務,解決了namespace到clusterId的路由問題。Nacos數據模型相對復雜,因為Nacos為服務的管理提供了很多特性,這些特性都被體現在數據的建模上。下面我們先來看看這張圖:

服務層和實例層很好理解,因為在分布式中一個服務必然會有多個節點,但是Nacos在服務層與實例層中間新增了一個集群層,一個服務對應多個集群,一個集群對應多個實例。這個集群層帶來了以下收益:

* Nacos的隔離性也從物理節點級別上升到了集群級別;

* 在進行水平擴縮容的時候,也可以進行集群級別的伸縮;

* 在應用需要使用Nacos時候,可以直接以集群為單位進行支撐。

實例分為兩種臨時實例和持久化實例:

* 臨時實例:使用客戶端上報模式,需要能夠自動摘除不健康實例,并且不需要持久化,而上層的業務服務,例如微服務或者?Dubbo?服務,服務的?Provider?端支持添加匯報心跳的邏輯,就可以作為臨時實例進行注冊。

* 持久化實例:服務端來主動探測是否健康,因為客戶端不會上報心跳,那么自然就不能去自動摘除下線的實例。一些基礎的組件例如數據庫、緩存等,這些往往不能上報心跳,這種類型的服務在注冊時,就需要作為持久化實例注冊。

上面是從服務出發的數據模型。下面則是把視野放大,從不同環境出發,建立起更廣泛的數據模型,也可以理解為對不同環境的相同服務做了數據隔離。

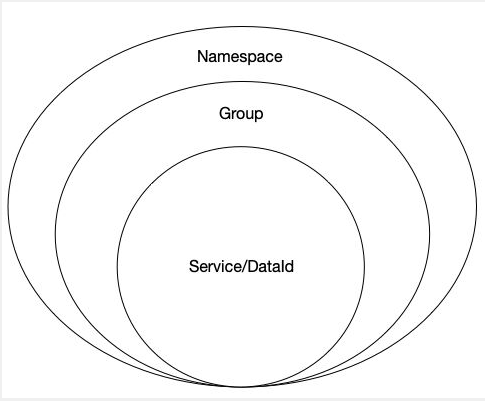

## 不同粒度的服務數據隔離

從命名空間到單個實例,中間經歷了組、服務、集群的層級劃分。每一個層級對應著不一樣的粒度的數據隔離,有效的滿足多業務多環境下的不同數據隔離需求。

這種圖要表達的意思很簡單,在Service層外面還包有兩層,分別是命名空間和組。

* 命名空間:業務在開發的時候可以將開發環境和生產環境分開,或者根據不同的業務線存在多個生產環境,命名空間常用場景之一就是不同環境的配置的區分隔離,例如開發測試環境和生產環境的資源(如配置、服務)隔離等。

* 組:對服務進行分組,可以滿足接口級別的隔離。

## 一致性協議

Nacos作為服務的注冊中心,同樣也需要面對數據的一致性問題,也就是需要在CAP理論中選擇,在最新的版本中,Nacos支持AP原則和CP原則兩種原則。

Nacos中的CP原則實現是基于簡化的Raft,主要是一主多從策略,Raft有三類角色Leader(領袖)、Follower(群眾)以及Candidate(候選人)。Raft的選舉過程和上一小節將到的ZAB協議選舉過程是一樣的,也需要獲得半數以上的票才能夠成功選出Leader。有一點小的區別是,ZAB的Follower在投票給一個Leader之前必須和Leader的日志達成一致,而Raft的Follower則簡單地說是誰的term高就投票給誰。Raft?協議也和ZAB協議一樣強依賴?Leader?節點的可用性來確保集群數據的一致性。只有Leader節點才有權力領導寫操作。它的寫操作流程跟我在上一小節講到的ZAB協議流程一樣類似于二階段提交的流程。在心跳檢測中Raft協議的心跳是從Leader到Follower,?而ZAB協議則相反。Raft和ZAB如此相似,歸根結底是因為Raft和ZAB都是Paxos算法的簡化和優化,并且把Paxos更加的具象化,讓人易于實現和理解。

Nacos中的AP原則實現基于阿里自研協議?Distro。Distro?協議則是參考了內部?ConfigServer?和開源?Eureka。該實現沒有主從之分,當客戶端請求的某個節點掛了后,不會有類似于選主的過程,客戶端請求會自動切換到新的Nacos節點,當宕機的節點恢復后,又會重新回到集群管理內。所要做的就是同步一些新的服務注冊信息給重啟的Nacos節點,達到數據一致的效果。

在Nacos中如何切換AP原則和CP原則,主要切換的條件是注冊的服務實例是否是臨時實例。如果是臨時實例,則選用的是Nacos中的AP原則。

## 服務注冊中心技術對比

## eureka與nacos的區別

* eureka采用AP模式實現注冊中心,無中心節點無leader概念,采用peertopeer集群架構

* nacos 默認采用AP模式,在1.0版本之后增加了AP+CP的混合模式實現注冊中心,采用raft協議,有leader概念

## 安裝部署

### 準備環境

Nacos 依賴 Java 環境來運行。如果您是從代碼開始構建并運行 Nacos,還需要為此配置 Maven 環境,請確保是在以下版本環境中安裝使用:

* 64 bit OS,支持 Linux/Unix/Mac/Windows,推薦選用 Linux/Unix/Mac。

* 64 bit JDK 1.8+

### 啟動

* windowd啟動方式

```

D:\open-capacity-platform\register-center>h:

H:\>cd alibaba

H:\alibaba>cd open-capacity-platform

H:\alibaba\open-capacity-platform>cd register-center

H:\alibaba\open-capacity-platform\register-center>cd nacos-server

H:\alibaba\open-capacity-platform\register-center\nacos-server>cd bin

H:\alibaba\open-capacity-platform\register-center\nacos-server\bin>startup.cmd

```

* Linux啟動方式

./startup.sh -m standalone

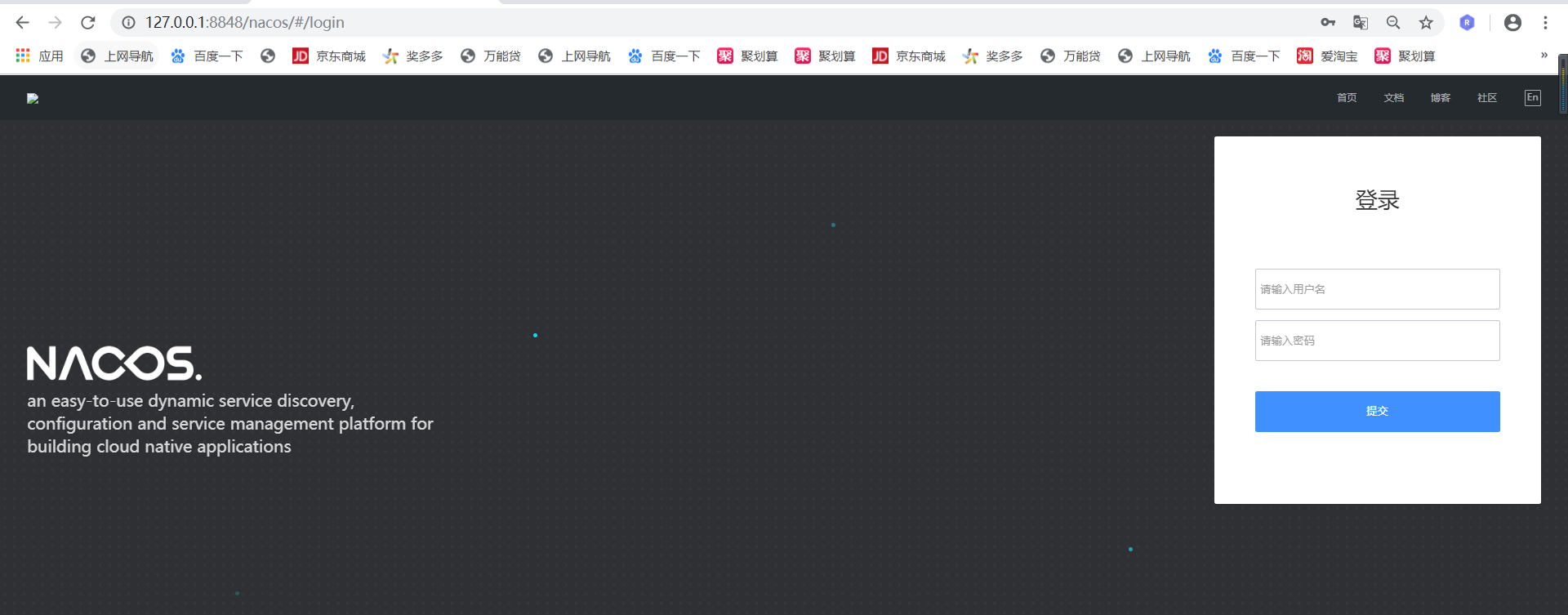

## 訪問服務

打開瀏覽器訪問:http://localhost:8848/nacos

**注:從 0.8.0 版本開始,需要登錄才可訪問,默認賬號密碼為 nacos/nacos**

## nacos服務注冊,可參考user-ceneter

引入POM

```

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-alibaba-nacos-discovery</artifactId>

</dependency>

```

bootstrap.yml增加以下配置

```

spring:

cloud:

nacos:

discovery:

server-addr: ip:prot #nacos的地址

```

工程啟動類添加以下注解

```

@EnableDiscoveryClient

```

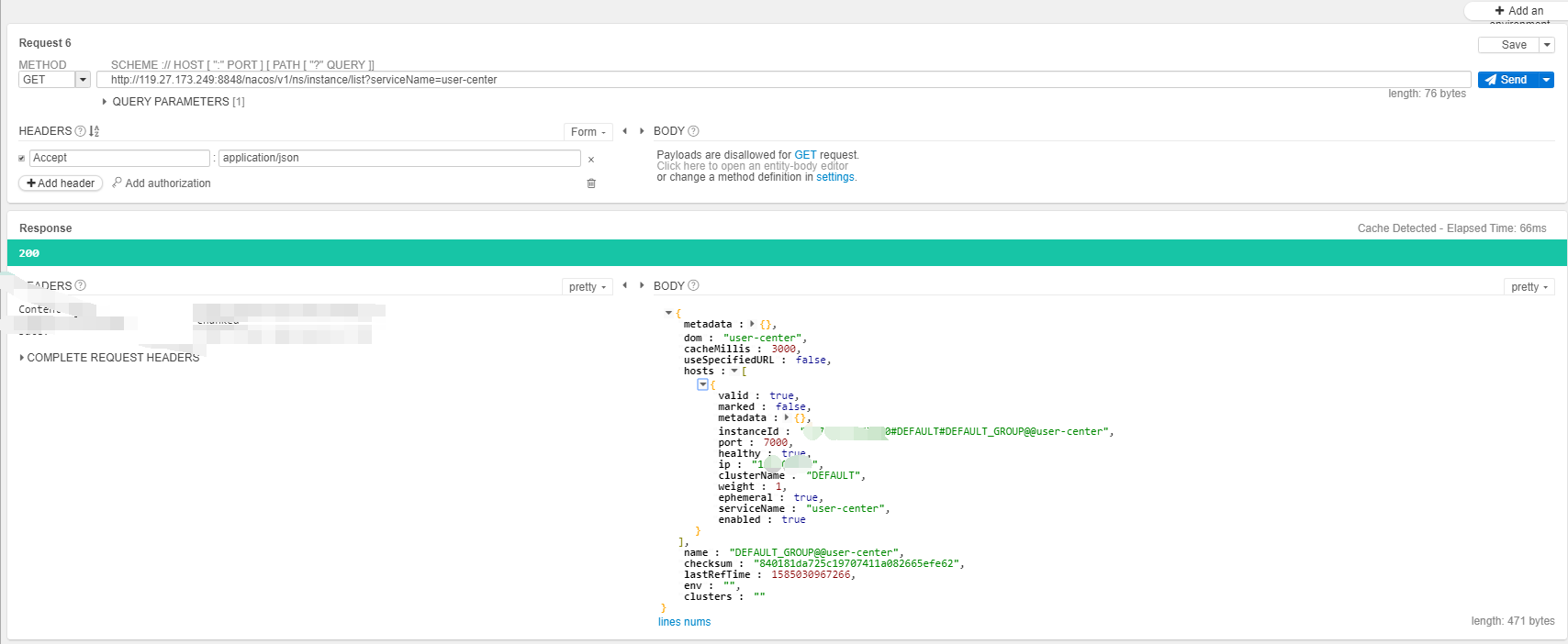

## nacos API

> 用API服務注冊,由于未心跳檢測,服務發現服務不會一直有效

### 服務注冊API

### 服務發現API

### 控制臺查看

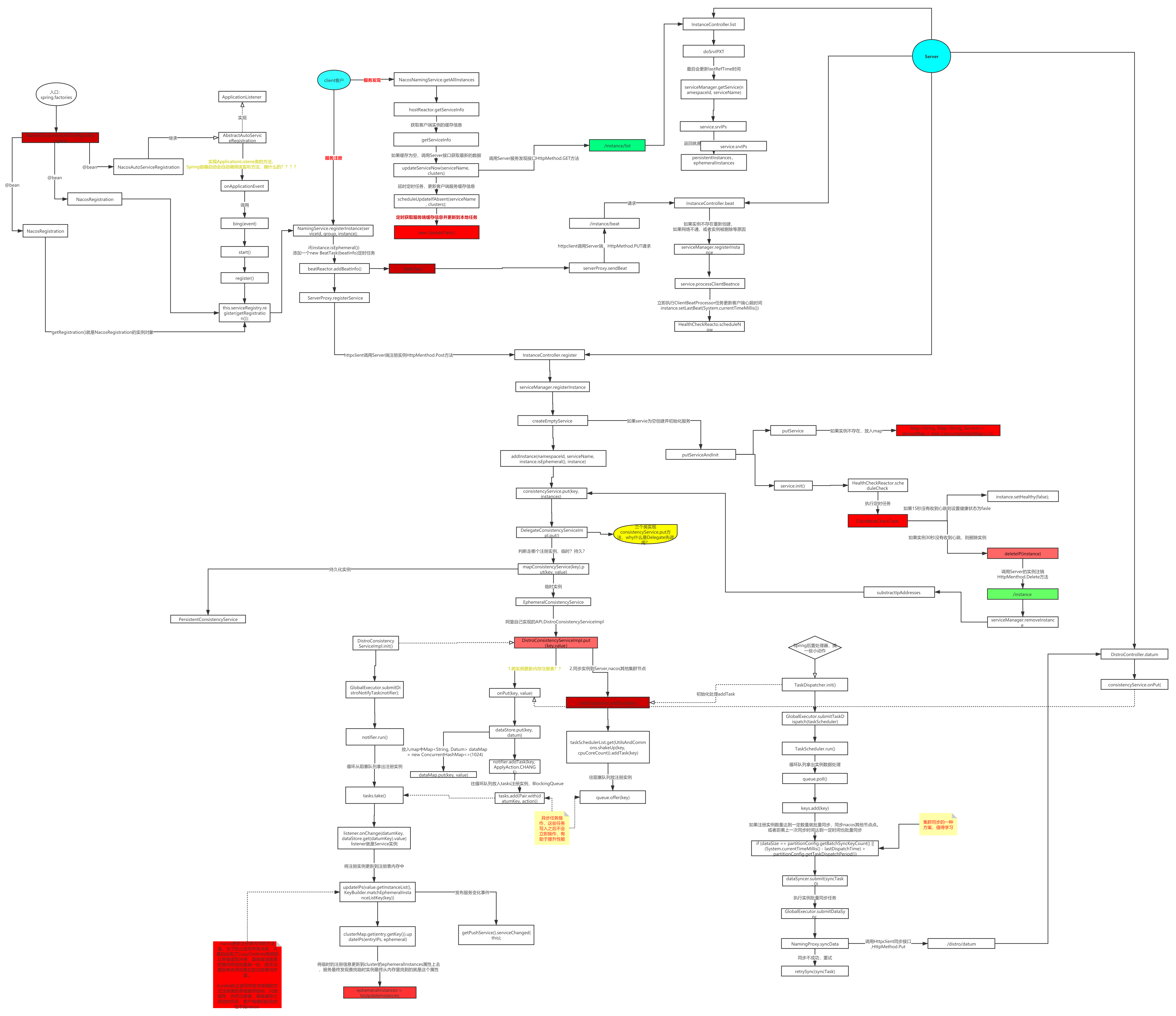

## nacos源碼分析

### nacos數據結構

### nacos 整體結構

### 內核原理

通過NacosServiceRegistry實現了ServiceRegistry接口,ServiceInstance可以拿到當前注冊實例。

#### 注冊

nacos-client注冊

```

@Override

public void register(Registration registration) {

if (StringUtils.isEmpty(registration.getServiceId())) {

log.warn("No service to register for nacos client...");

return;

}

String serviceId = registration.getServiceId();

Instance instance = new Instance();

instance.setIp(registration.getHost());

instance.setPort(registration.getPort());

instance.setWeight(nacosDiscoveryProperties.getWeight());

instance.setClusterName(nacosDiscoveryProperties.getClusterName());

instance.setMetadata(registration.getMetadata());

try {

namingService.registerInstance(serviceId, instance);

log.info("nacos registry, {} {}:{} register finished", serviceId,

instance.getIp(), instance.getPort());

}

catch (Exception e) {

log.error("nacos registry, {} register failed...{},", serviceId,

registration.toString(), e);

}

}

```

#### 心跳

定時發送給nacos-server

```

package com.alibaba.nacos.client.naming.beat;

import com.alibaba.nacos.api.common.Constants;

import com.alibaba.nacos.client.monitor.MetricsMonitor;

import com.alibaba.nacos.client.naming.net.NamingProxy;

import com.alibaba.nacos.client.naming.utils.UtilAndComs;

import java.util.Map;

import java.util.concurrent.*;

import static com.alibaba.nacos.client.utils.LogUtils.NAMING_LOGGER;

/**

* @author harold

*/

public class BeatReactor {

private ScheduledExecutorService executorService;

private volatile long clientBeatInterval = 5 * 1000;

private NamingProxy serverProxy;

public final Map<String, BeatInfo> dom2Beat = new ConcurrentHashMap<String, BeatInfo>();

public BeatReactor(NamingProxy serverProxy) {

this(serverProxy, UtilAndComs.DEFAULT_CLIENT_BEAT_THREAD_COUNT);

}

public BeatReactor(NamingProxy serverProxy, int threadCount) {

this.serverProxy = serverProxy;

executorService = new ScheduledThreadPoolExecutor(threadCount, new ThreadFactory() {

@Override

public Thread newThread(Runnable r) {

Thread thread = new Thread(r);

thread.setDaemon(true);

thread.setName("com.alibaba.nacos.naming.beat.sender");

return thread;

}

});

executorService.schedule(new BeatProcessor(), 0, TimeUnit.MILLISECONDS);

}

public void addBeatInfo(String serviceName, BeatInfo beatInfo) {

NAMING_LOGGER.info("[BEAT] adding beat: {} to beat map.", beatInfo);

dom2Beat.put(buildKey(serviceName, beatInfo.getIp(), beatInfo.getPort()), beatInfo);

MetricsMonitor.getDom2BeatSizeMonitor().set(dom2Beat.size());

}

public void removeBeatInfo(String serviceName, String ip, int port) {

NAMING_LOGGER.info("[BEAT] removing beat: {}:{}:{} from beat map.", serviceName, ip, port);

dom2Beat.remove(buildKey(serviceName, ip, port));

MetricsMonitor.getDom2BeatSizeMonitor().set(dom2Beat.size());

}

public String buildKey(String serviceName, String ip, int port) {

return serviceName + Constants.NAMING_INSTANCE_ID_SPLITTER

+ ip + Constants.NAMING_INSTANCE_ID_SPLITTER + port;

}

class BeatProcessor implements Runnable {

@Override

public void run() {

try {

for (Map.Entry<String, BeatInfo> entry : dom2Beat.entrySet()) {

BeatInfo beatInfo = entry.getValue();

if (beatInfo.isScheduled()) {

continue;

}

beatInfo.setScheduled(true);

executorService.schedule(new BeatTask(beatInfo), 0, TimeUnit.MILLISECONDS);

}

} catch (Exception e) {

NAMING_LOGGER.error("[CLIENT-BEAT] Exception while scheduling beat.", e);

} finally {

executorService.schedule(this, clientBeatInterval, TimeUnit.MILLISECONDS);

}

}

}

class BeatTask implements Runnable {

BeatInfo beatInfo;

public BeatTask(BeatInfo beatInfo) {

this.beatInfo = beatInfo;

}

@Override

public void run() {

long result = serverProxy.sendBeat(beatInfo);

beatInfo.setScheduled(false);

if (result > 0) {

clientBeatInterval = result;

}

}

}

}

```

### 功能說明

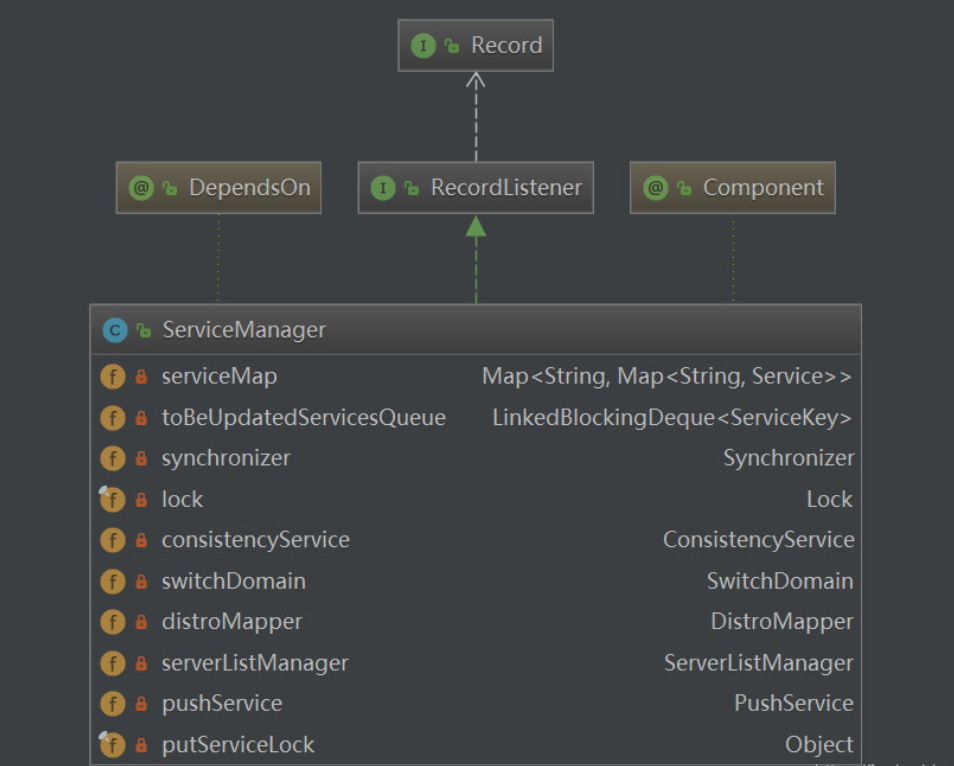

ServiceManager是nacos naming server中service核心管理類。在啟動時會執行一次本地信息到其他服務器,while(true)發生改變的service隊列內容進行本地更新,同時啟動對com.alibaba.nacos.naming.domains.meta.前綴的key的監聽;在運行過程中,執行controller接受的相關請求的功能,完成本地狀態和遠程服務器同步。

## nacos流程圖

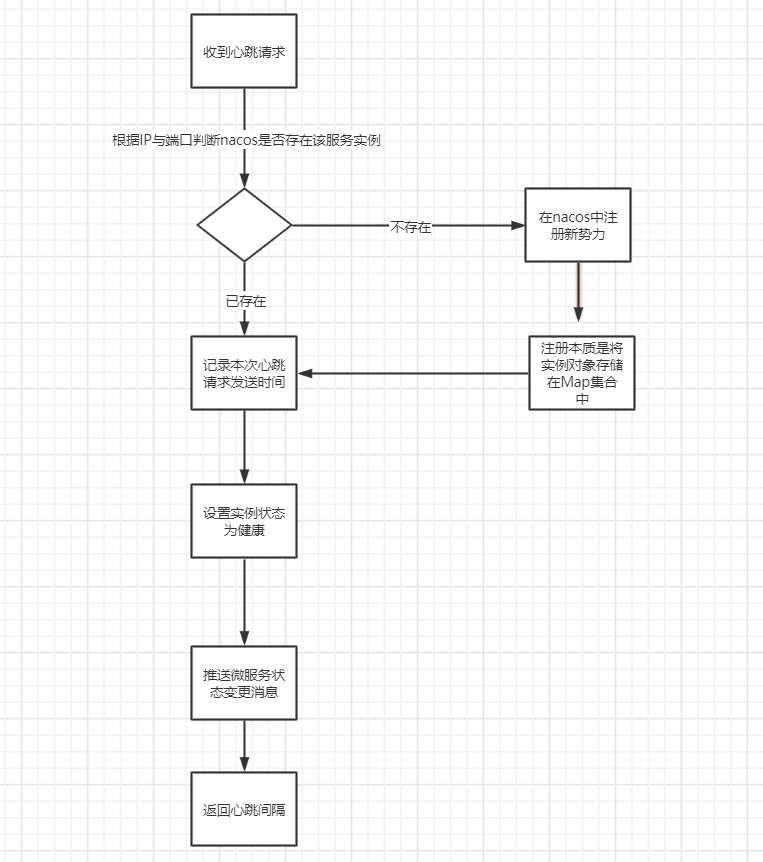

## Nacos 注冊中心的心跳機制

與 Nacos 服務器之間的通信過程。在微服務啟動后每過5秒,會由微服務內置的 Nacos 客戶端主動向 Nacos 服務器發起心跳包(HeartBeat)。心跳包會包含當前服務實例的名稱、IP、端口、集群名、權重等信息。

如果你開啟微服務 Debug?日志,會清晰地看到每?5?秒一個心跳請求被發送到?Nacos 的 /nacos/v1/ns/instance/beat 接口,該請求會被 Nacos 服務器內置的 naming 模塊處理。

```

17:11:23.826 DEBUG 10720 --- [ing.beat.sender] s.n.www.protocol.http.HttpURLConnection : sun.net.www.MessageHeader@665891d213 pairs: {PUT /nacos/v1/ns/instance/beat?app=unknown&serviceName=DEFAULT_GROUP%40%40sample-service&namespaceId=public&port=9000&clusterName=DEFAULT&ip=119.27.173.249 HTTP/1.1: null}{Content-Type: application/x-www-form-urlencoded}{Accept-Charset: UTF-8}{Accept-Encoding: gzip,deflate,sdch}{Content-Encoding: gzip}{Client-Version: 1.3.2}{User-Agent: Nacos-Java-Client:v1.3.2}{RequestId: 6447aa06-9d70-41ea-83ef-cd27af1d3422}{Request-Module: Naming}{Host: 119.27.173.249:8848}{Accept: text/html, image/gif, image/jpeg, *; q=.2, */*; q=.2}{Connection: keep-alive}{Content-Length: 326}

17:11:28.837 DEBUG 10720 --- [ing.beat.sender] s.n.www.protocol.http.HttpURLConnection : sun.net.www.MessageHeader@5f00479a12 pairs: {PUT /nacos/v1/ns/instance/beat?app=unknown&serviceName=DEFAULT_GROUP%40%40sample-service&namespaceId=public&port=9000&clusterName=DEFAULT&ip=119.27.173.249 HTTP/1.1: null}{Content-Type: application/x-www-form-urlencoded}{Accept-Charset: UTF-8}{Accept-Encoding: gzip,deflate,sdch}{Content-Encoding: gzip}{Client-Version: 1.3.2}{User-Agent: Nacos-Java-Client:v1.3.2}{RequestId: 9fdf2264-9704-437f-bd34-7c9ee5e0be41}{Request-Module: Naming}{Host: 119.27.173.249:8848}{Accept: text/html, image/gif, image/jpeg, *; q=.2, */*; q=.2}{Connection: keep-alive}

17:11:38.847 DEBUG 10720 --- [ing.beat.sender] s.n.www.protocol.http.HttpURLConnection : sun.net.www.MessageHeader@3521283812 pairs: {PUT /nacos/v1/ns/instance/beat?app=unknown&serviceName=DEFAULT_GROUP%40%40sample-service&namespaceId=public&port=9000&clusterName=DEFAULT&ip=119.27.173.249 HTTP/1.1: null}{Content-Type: application/x-www-form-urlencoded}{Accept-Charset: UTF-8}{Accept-Encoding: gzip,deflate,sdch}{Content-Encoding: gzip}{Client-Version: 1.3.2}{User-Agent: Nacos-Java-Client:v1.3.2}{RequestId: ccb6a586-897f-4036-9c0d-c614e2ff370a}{Request-Module: Naming}{Host: 119.27.173.249:8848}{Accept: text/html, image/gif, image/jpeg, *; q=.2, */*; q=.2}{Connection: keep-alive}

```

naming 模塊在接收到心跳包后,會按下圖邏輯處理心跳包并返回響應:

naming 模塊收到心跳包,首先根據 IP 與端口判斷 Nacos 是否存在該服務實例?如果實例信息不存在,在 Nacos 中注冊登記該實例。而注冊的本質是將新實例對象存儲在Map集合中;

如果實例信息已存在,記錄本次心跳包發送時間;

* 設置實例狀態為“健康”;

* 推送“微服務狀態變更”消息;

* naming 模塊返回心跳包時間間隔。

那 Nacos 又是如何將無效實例從可用實例中剔除呢?Nacos Server 內置的邏輯是每過 20 秒對“實例 Map”中的所有“非健康”實例進行掃描,如發現“非健康”實例,隨即從Map中將該實例刪除。

- 前言

- 1.項目說明

- 2.項目更新日志

- 3.文檔更新日志

- 01.快速開始

- 01.maven構建項目

- 02.環境安裝

- 03.STS項目導入

- 03.IDEA項目導入

- 04.數據初始化

- 05.項目啟動

- 06.付費文檔說明

- 02.總體流程

- 1.oauth接口

- 2.架構設計圖

- 3.微服務介紹

- 4.功能介紹

- 5.梳理流程

- 03.模塊詳解

- 01.老版本1.0.1分支模塊講解

- 01.db-core模塊

- 02.api-commons模塊

- 03.log-core模塊

- 04.security-core模塊

- 05.swagger-core模塊

- 06.eureka-server模塊

- 07.auth-server模塊

- 08.auth-sso模塊解析

- 09.user-center模塊

- 10.api-gateway模塊

- 11.file-center模塊

- 12.log-center模塊

- 13.batch-center模塊

- 14.back-center模塊

- 02.spring-boot-starter-web那點事

- 03.自定義db-spring-boot-starter

- 04.自定義log-spring-boot-starter

- 05.自定義redis-spring-boot-starter

- 06.自定義common-spring-boot-starter

- 07.自定義swagger-spring-boot-starter

- 08.自定義uaa-server-spring-boot-starter

- 09.自定義uaa-client-spring-boot-starter

- 10.自定義ribbon-spring-boot-starter

- 11.springboot啟動原理

- 12.eureka-server模塊

- 13.auth-server模塊

- 14.user-center模塊

- 15.api-gateway模塊

- 16.file-center模塊

- 17.log-center模塊

- 18.back-center模塊

- 19.auth-sso模塊

- 20.admin-server模塊

- 21.zipkin-center模塊

- 22.job-center模塊

- 23.batch-center

- 04.全新網關

- 01.基于spring cloud gateway的new-api-gateway

- 02.spring cloud gateway整合Spring Security Oauth

- 03.基于spring cloud gateway的redis動態路由

- 04.spring cloud gateway聚合swagger文檔

- 05.技術詳解

- 01.互聯網系統設計原則

- 02.系統冪等性設計與實踐

- 03.Oauth最簡向導開發指南

- 04.oauth jdbc持久化策略

- 05.JWT token方式啟用

- 06.token有效期的處理

- 07.@PreAuthorize注解分析

- 08.獲取當前用戶信息

- 09.認證授權白名單配置

- 10.OCP權限設計

- 11.服務安全流程

- 12.認證授權詳解

- 13.驗證碼技術

- 14.短信驗證碼登錄

- 15.動態數據源配置

- 16.分頁插件使用

- 17.緩存擊穿

- 18.分布式主鍵生成策略

- 19.分布式定時任務

- 20.分布式鎖

- 21.網關多維度限流

- 22.跨域處理

- 23.容錯限流

- 24.應用訪問次數控制

- 25.統一業務異常處理

- 26.日志埋點

- 27.GPRC內部通信

- 28.服務間調用

- 29.ribbon負載均衡

- 30.微服務分布式跟蹤

- 31.異步與線程傳遞變量

- 32.死信隊列延時消息

- 33.單元測試用例

- 34.Greenwich.RELEASE升級

- 35.混沌工程質量保證

- 06.開發初探

- 1.開發技巧

- 2.crud例子

- 3.新建服務

- 4.區分前后臺用戶

- 07.分表分庫

- 08.分布式事務

- 1.Seata介紹

- 2.Seata部署

- 09.shell部署

- 01.eureka-server

- 02.user-center

- 03.auth-server

- 04.api-gateway

- 05.file-center

- 06.log-center

- 07.back-center

- 08.編寫shell腳本

- 09.集群shell部署

- 10.集群shell啟動

- 11.部署阿里云問題

- 10.網關安全

- 1.openresty https保障服務安全

- 2.openresty WAF應用防火墻

- 3.openresty 高可用

- 11.docker配置

- 01.docker安裝

- 02.Docker 開啟遠程API

- 03.采用docker方式打包到服務器

- 04.docker創建mysql

- 05.docker網絡原理

- 06.docker實戰

- 6.01.安裝docker

- 6.02.管理鏡像基本命令

- 6.03.容器管理

- 6.04容器數據持久化

- 6.05網絡模式

- 6.06.Dockerfile

- 6.07.harbor部署

- 6.08.使用自定義鏡像

- 12.統一監控中心

- 01.spring boot admin監控

- 02.Arthas診斷利器

- 03.nginx監控(filebeat+es+grafana)

- 04.Prometheus監控

- 05.redis監控(redis+prometheus+grafana)

- 06.mysql監控(mysqld_exporter+prometheus+grafana)

- 07.elasticsearch監控(elasticsearch-exporter+prometheus+grafana)

- 08.linux監控(node_exporter+prometheus+grafana)

- 09.micoservice監控

- 10.nacos監控

- 11.druid數據源監控

- 12.prometheus.yml

- 13.grafana告警

- 14.Alertmanager告警

- 15.監控微信告警

- 16.關于接口監控告警

- 17.prometheus-HA架構

- 18.總結

- 13.統一日志中心

- 01.統一日志中心建設意義

- 02.通過ELK收集mysql慢查詢日志

- 03.通過elk收集微服務模塊日志

- 04.通過elk收集nginx日志

- 05.統一日志中心性能優化

- 06.kibana安裝部署

- 07.日志清理方案

- 08.日志性能測試指標

- 09.總結

- 14.數據查詢平臺

- 01.數據查詢平臺架構

- 02.mysql配置bin-log

- 03.單節點canal-server

- 04.canal-ha部署

- 05.canal-kafka部署

- 06.實時增量數據同步mysql

- 07.canal監控

- 08.clickhouse運維常見腳本

- 15.APM監控

- 1.Elastic APM

- 2.Skywalking

- 01.docker部署es

- 02.部署skywalking-server

- 03.部署skywalking-agent

- 16.壓力測試

- 1.ocp.jmx

- 2.test.bat

- 3.壓測腳本

- 4.壓力報告

- 5.報告分析

- 6.壓測平臺

- 7.并發測試

- 8.wrk工具

- 9.nmon

- 10.jmh測試

- 17.SQL優化

- 1.oracle篇

- 01.基線測試

- 02.調優前奏

- 03.線上瓶頸定位

- 04.執行計劃解讀

- 05.高級SQL語句

- 06.SQL tuning

- 07.數據恢復

- 08.深入10053事件

- 09.深入10046事件

- 2.mysql篇

- 01.innodb存儲引擎

- 02.BTree索引

- 03.執行計劃

- 04.查詢優化案例分析

- 05.為什么會走錯索引

- 06.表連接優化問題

- 07.Connection連接參數

- 08.Centos7系統參數調優

- 09.mysql監控

- 10.高級SQL語句

- 11.常用維護腳本

- 12.percona-toolkit

- 18.redis高可用方案

- 1.免密登錄

- 2.安裝部署

- 3.配置文件

- 4.啟動腳本

- 19.消息中間件搭建

- 19-01.rabbitmq集群搭建

- 01.rabbitmq01

- 02.rabbitmq02

- 03.rabbitmq03

- 04.鏡像隊列

- 05.haproxy搭建

- 06.keepalived

- 19-02.rocketmq搭建

- 19-03.kafka集群

- 20.mysql高可用方案

- 1.環境

- 2.mysql部署

- 3.Xtrabackup部署

- 4.Galera部署

- 5.galera for mysql 集群

- 6.haproxy+keepalived部署

- 21.es集群部署

- 22.生產實施優化

- 1.linux優化

- 2.jvm優化

- 3.feign優化

- 4.zuul性能優化

- 23.線上問題診斷

- 01.CPU性能評估工具

- 02.內存性能評估工具

- 03.IO性能評估工具

- 04.網絡問題工具

- 05.綜合診斷評估工具

- 06.案例診斷01

- 07.案例診斷02

- 08.案例診斷03

- 09.案例診斷04

- 10.遠程debug

- 24.fiddler抓包實戰

- 01.fiddler介紹

- 02.web端抓包

- 03.app抓包

- 25.疑難解答交流

- 01.有了auth/token獲取token了為啥還要配置security的登錄配置

- 02.權限數據存放在redis嗎,代碼在哪里啊

- 03.其他微服務和認證中心的關系

- 04.改包問題

- 05.use RequestContextListener or RequestContextFilter to expose the current request

- 06./oauth/token對應代碼在哪里

- 07.驗證碼出不來

- 08./user/login

- 09.oauth無法自定義權限表達式

- 10.sleuth引發線程數過高問題

- 11.elk中使用7x版本問題

- 12.RedisCommandTimeoutException問題

- 13./oauth/token CPU過高

- 14.feign與權限標識符問題

- 15.動態路由RedisCommandInterruptedException: Command interrupted

- 26.學習資料

- 海量學習資料等你來拿

- 27.持續集成

- 01.git安裝

- 02.代碼倉庫gitlab

- 03.代碼倉庫gogs

- 04.jdk&&maven

- 05.nexus安裝

- 06.sonarqube

- 07.jenkins

- 28.Rancher部署

- 1.rancher-agent部署

- 2.rancher-server部署

- 3.ocp后端部署

- 4.演示前端部署

- 5.elk部署

- 6.docker私服搭建

- 7.rancher-server私服

- 8.rancher-agent docker私服

- 29.K8S部署OCP

- 01.準備OCP的構建環境和部署環境

- 02.部署順序

- 03.在K8S上部署eureka-server

- 04.在K8S上部署mysql

- 05.在K8S上部署redis

- 06.在K8S上部署auth-server

- 07.在K8S上部署user-center

- 08.在K8S上部署api-gateway

- 09.在K8S上部署back-center

- 30.Spring Cloud Alibaba

- 01.統一的依賴管理

- 02.nacos-server

- 03.生產可用的Nacos集群

- 04.nacos配置中心

- 05.common.yaml

- 06.user-center

- 07.auth-server

- 08.api-gateway

- 09.log-center

- 10.file-center

- 11.back-center

- 12.sentinel-dashboard

- 12.01.sentinel流控規則

- 12.02.sentinel熔斷降級規則

- 12.03.sentinel熱點規則

- 12.04.sentinel系統規則

- 12.05.sentinel規則持久化

- 12.06.sentinel總結

- 13.sentinel整合openfeign

- 14.sentinel整合網關

- 1.sentinel整合zuul

- 2.sentinel整合scg

- 15.Dubbo與Nacos共存

- 31.Java源碼剖析

- 01.基礎數據類型和String

- 02.Arrays工具類

- 03.ArrayList源碼分析

- 32.面試專題匯總

- 01.JVM專題匯總

- 02.多線程專題匯總

- 03.Spring專題匯總

- 04.springboot專題匯總

- 05.springcloud面試匯總

- 文檔問題跟蹤處理