# 把所有東西結合在一起

在本節中,我們將結合到目前為止所示的所有內容,并為虹膜數據集創建分類器。

## 做好準備

虹膜數據集在[第 1 章](../Text/0.html),TensorFlow 入門中使用數據源秘籍中有更詳細的描述。我們將加載這些數據并制作一個簡單的二元分類器來預測花是否是 Iris setosa 的種類。需要說明的是,這個數據集有三個種類,但我們只能預測一種花是單一種,是否是一種花,給我們一個二元分類器。我們將首先加載庫和數據,然后相應地轉換目標。

## 操作步驟

我們按如下方式處理秘籍:

1. 首先,我們加載所需的庫并初始化計算圖。注意我們也在這里加載`matplotlib`,因為我們想在之后繪制結果行:

```py

import matplotlib.pyplot as plt

import numpy as np

from sklearn import datasets

import tensorflow as tf

sess = tf.Session()

```

1. 接下來,我們加載虹膜數據。我們還需要將目標數據轉換為 1 或 0,無論目標是否為 setosa。由于虹膜數據集將 setosa 標記為 0,我們將更改所有目標,值為 0 到 1,其他值全部為 0.我們也將只使用兩個特征,花瓣長度和花瓣寬度。這兩個特征是每個`x-value`中的第三和第四個條目:

```py

iris = datasets.load_iris()

binary_target = np.array([1\. if x==0 else 0\. for x in iris.target])

iris_2d = np.array([[x[2], x[3]] for x in iris.data])

```

1. 讓我們聲明我們的批量大小,數據占位符和模型變量。請記住,可變批量大小的數據占位符將`None`作為第一個維度:

```py

batch_size = 20

x1_data = tf.placeholder(shape=[None, 1], dtype=tf.float32)

x2_data = tf.placeholder(shape=[None, 1], dtype=tf.float32)

y_target = tf.placeholder(shape=[None, 1], dtype=tf.float32)

A = tf.Variable(tf.random_normal(shape=[1, 1]))

b = tf.Variable(tf.random_normal(shape=[1, 1]))

```

> 請注意,我們可以通過使用`dtype=tf.float32`來減少浮點數的字節來提高算法的表現(速度)。

1. 在這里,我們定義線性模型。模型將采用`x2 = x1 * A + b`的形式,如果我們想要找到該行上方或下方的點,我們會在插入等式`x2 - x1 * A - b`時看到它們是高于還是低于零。我們將通過取該方程的 sigmoid 并從該方程預測 1 或 0 來實現。請記住,TensorFlow 具有內置 sigmoid 的`loss`函數,因此我們只需要在 sigmoid 函數之前定義模型的輸出:

```py

my_mult = tf.matmul(x2_data, A)

my_add = tf.add(my_mult, b)

my_output = tf.sub(x1_data, my_add)

```

1. 現在,我們使用 TensorFlow 的內置`sigmoid_cross_entropy_with_logits()`函數添加 sigmoid 交叉熵損失函數:

```py

xentropy = tf.nn.sigmoid_cross_entropy_with_logits(my_output, y_target)

```

1. 我們還必須告訴 TensorFlow 如何通過聲明優化方法來優化我們的計算圖。我們希望最大限度地減少交叉熵損失。我們還會選擇`0.05`作為我們的學習率:

```py

my_opt = tf.train.GradientDescentOptimizer(0.05)

train_step = my_opt.minimize(xentropy)

```

1. 現在,我們創建一個變量初始化操作并告訴 TensorFlow 執行它:

```py

init = tf.global_variables_initializer()

sess.run(init)

```

1. 現在,我們將訓練我們的線性模型 1000 次迭代。我們將提供我們需要的三個數據點:花瓣長度,花瓣寬度和目標變量。每 200 次迭代,我們將打印變量值:

```py

for i in range(1000):

rand_index = np.random.choice(len(iris_2d), size=batch_size)

rand_x = iris_2d[rand_index]

rand_x1 = np.array([[x[0]] for x in rand_x])

rand_x2 = np.array([[x[1]] for x in rand_x])

rand_y = np.array([[y] for y in binary_target[rand_index]])

sess.run(train_step, feed_dict={x1_data: rand_x1, x2_data: rand_x2, y_target: rand_y})

if (i + 1) % 200 == 0:

print('Step #' + str(i+1) + ' A = ' + str(sess.run(A)) + ', b = ' + str(sess.run(b)))

Step #200 A = [[ 8.67285347]], b = [[-3.47147632]]

Step #400 A = [[ 10.25393486]], b = [[-4.62928772]]

Step #600 A = [[ 11.152668]], b = [[-5.4077611]]

Step #800 A = [[ 11.81016064]], b = [[-5.96689034]]

Step #1000 A = [[ 12.41202831]], b = [[-6.34769201]]

```

1. 下一組命令提取模型變量并在繪圖上繪制線條。結果繪圖在它的工作原理...部分:

```py

[[slope]] = sess.run(A)

[[intercept]] = sess.run(b)

x = np.linspace(0, 3, num=50)

ablineValues = []

for i in x:

ablineValues.append(slope*i+intercept)

setosa_x = [a[1] for i,a in enumerate(iris_2d) if binary_target[i]==1]

setosa_y = [a[0] for i,a in enumerate(iris_2d) if binary_target[i]==1]

non_setosa_x = [a[1] for i,a in enumerate(iris_2d) if binary_target[i]==0]

non_setosa_y = [a[0] for i,a in enumerate(iris_2d) if binary_target[i]==0]

plt.plot(setosa_x, setosa_y, 'rx', ms=10, mew=2, label='setosa')

plt.plot(non_setosa_x, non_setosa_y, 'ro', label='Non-setosa')

plt.plot(x, ablineValues, 'b-')

plt.xlim([0.0, 2.7])

plt.ylim([0.0, 7.1])

plt.suptitle('Linear' Separator For I.setosa', fontsize=20)

plt.xlabel('Petal Length')

plt.ylabel('Petal Width')

plt.legend(loc='lower right')

plt.show()

```

## 工作原理

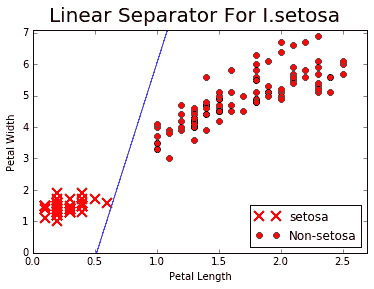

我們的目標是僅使用花瓣寬度和花瓣長度在 I. setosa 點和其他兩個物種之間擬合一條線。如果我們繪制點和結果線,我們看到我們已經實現了這個:

圖 7:花瓣寬度與花瓣長度的 I. setosa 和 non-setosa 的圖;實線是我們在 1000 次迭代后實現的線性分離器

## 更多

雖然我們實現了用一條線分隔兩個類的目標,但它可能不是分離兩個類的最佳模型。在[第 4 章](http://Support%20Vector%20Machines),支持向量機中,我們將討論支持向量機,它是在特征空間中分離兩個類的更好方法。

## 另見

* 有關 scikit-learn iris 數據集實現的信息,請參閱 [http://scikit-learn.org/stable/auto_examples/datasets/plot_iris_dataset.html](http://scikit-learn.org/stable/auto_examples/datasets/plot_iris_dataset.html) 上的文檔。

- TensorFlow 入門

- 介紹

- TensorFlow 如何工作

- 聲明變量和張量

- 使用占位符和變量

- 使用矩陣

- 聲明操作符

- 實現激活函數

- 使用數據源

- 其他資源

- TensorFlow 的方式

- 介紹

- 計算圖中的操作

- 對嵌套操作分層

- 使用多個層

- 實現損失函數

- 實現反向傳播

- 使用批量和隨機訓練

- 把所有東西結合在一起

- 評估模型

- 線性回歸

- 介紹

- 使用矩陣逆方法

- 實現分解方法

- 學習 TensorFlow 線性回歸方法

- 理解線性回歸中的損失函數

- 實現 deming 回歸

- 實現套索和嶺回歸

- 實現彈性網絡回歸

- 實現邏輯回歸

- 支持向量機

- 介紹

- 使用線性 SVM

- 簡化為線性回歸

- 在 TensorFlow 中使用內核

- 實現非線性 SVM

- 實現多類 SVM

- 最近鄰方法

- 介紹

- 使用最近鄰

- 使用基于文本的距離

- 使用混合距離函數的計算

- 使用地址匹配的示例

- 使用最近鄰進行圖像識別

- 神經網絡

- 介紹

- 實現操作門

- 使用門和激活函數

- 實現單層神經網絡

- 實現不同的層

- 使用多層神經網絡

- 改進線性模型的預測

- 學習玩井字棋

- 自然語言處理

- 介紹

- 使用詞袋嵌入

- 實現 TF-IDF

- 使用 Skip-Gram 嵌入

- 使用 CBOW 嵌入

- 使用 word2vec 進行預測

- 使用 doc2vec 進行情緒分析

- 卷積神經網絡

- 介紹

- 實現簡單的 CNN

- 實現先進的 CNN

- 重新訓練現有的 CNN 模型

- 應用 StyleNet 和 NeuralStyle 項目

- 實現 DeepDream

- 循環神經網絡

- 介紹

- 為垃圾郵件預測實現 RNN

- 實現 LSTM 模型

- 堆疊多個 LSTM 層

- 創建序列到序列模型

- 訓練 Siamese RNN 相似性度量

- 將 TensorFlow 投入生產

- 介紹

- 實現單元測試

- 使用多個執行程序

- 并行化 TensorFlow

- 將 TensorFlow 投入生產

- 生產環境 TensorFlow 的一個例子

- 使用 TensorFlow 服務

- 更多 TensorFlow

- 介紹

- 可視化 TensorBoard 中的圖

- 使用遺傳算法

- 使用 k 均值聚類

- 求解常微分方程組

- 使用隨機森林

- 使用 TensorFlow 和 Keras