# 如何利用 LSTM 網絡進行權重正則化進行時間序列預測

> 原文: [https://machinelearningmastery.com/use-weight-regularization-lstm-networks-time-series-forecasting/](https://machinelearningmastery.com/use-weight-regularization-lstm-networks-time-series-forecasting/)

長短期記憶(LSTM)模型是能夠學習觀察序列的循環神經網絡。

這可能使它們成為一個非常適合時間序列預測的網絡。

LSTM 的一個問題是他們可以輕松地過度訓練訓練數據,降低他們的預測技巧。

權重正則化是一種對 LSTM 節點內的權重施加約束(例如 L1 或 L2)的技術。這具有減少過度擬合和改善模型表現的效果。

在本教程中,您將了解如何使用 LSTM 網絡進行權重正則化,并設計實驗來測試其對時間序列預測的有效性。

完成本教程后,您將了解:

* 如何設計一個強大的測試工具來評估 LSTM 網絡的時間序列預測。

* 如何設計,執行和解釋使用 LSTM 的偏置權重正則化的結果。

* 如何設計,執行和解釋使用 LSTM 的輸入和循環權重正則化的結果。

讓我們開始吧。

如何使用 LSTM 網絡進行權重正則化進行時間序列預測

攝影:Julian Fong,保留一些權利。

## 教程概述

本教程分為 6 個部分。他們是:

1. 洗發水銷售數據集

2. 實驗測試線束

3. 偏差權重正則化

4. 輸入權重正則化

5. 復發性體重正則化

6. 審查結果

### 環境

本教程假定您已安裝 Python SciPy 環境。您可以在此示例中使用 Python 2 或 3。

本教程假設您安裝了 TensorFlow 或 Theano 后端的 Keras v2.0 或更高版本。

本教程還假設您安裝了 scikit-learn,Pandas,NumPy 和 Matplotlib。

如果您在設置 Python 環境時需要幫助,請參閱以下帖子:

* [如何使用 Anaconda 設置用于機器學習和深度學習的 Python 環境](http://machinelearningmastery.com/setup-python-environment-machine-learning-deep-learning-anaconda/)

接下來,讓我們看看標準時間序列預測問題,我們可以將其用作此實驗的上下文。

## 洗發水銷售數據集

該數據集描述了 3 年期間每月洗發水的銷售數量。

單位是銷售計數,有 36 個觀察。原始數據集歸功于 Makridakis,Wheelwright 和 Hyndman(1998)。

[您可以在此處下載并了解有關數據集的更多信息](https://datamarket.com/data/set/22r0/sales-of-shampoo-over-a-three-year-period)。

下面的示例加載并創建已加載數據集的圖。

```py

# load and plot dataset

from pandas import read_csv

from pandas import datetime

from matplotlib import pyplot

# load dataset

def parser(x):

return datetime.strptime('190'+x, '%Y-%m')

series = read_csv('shampoo-sales.csv', header=0, parse_dates=[0], index_col=0, squeeze=True, date_parser=parser)

# summarize first few rows

print(series.head())

# line plot

series.plot()

pyplot.show()

```

運行該示例將數據集作為 Pandas Series 加載并打印前 5 行。

```py

Month

1901-01-01 266.0

1901-02-01 145.9

1901-03-01 183.1

1901-04-01 119.3

1901-05-01 180.3

Name: Sales, dtype: float64

```

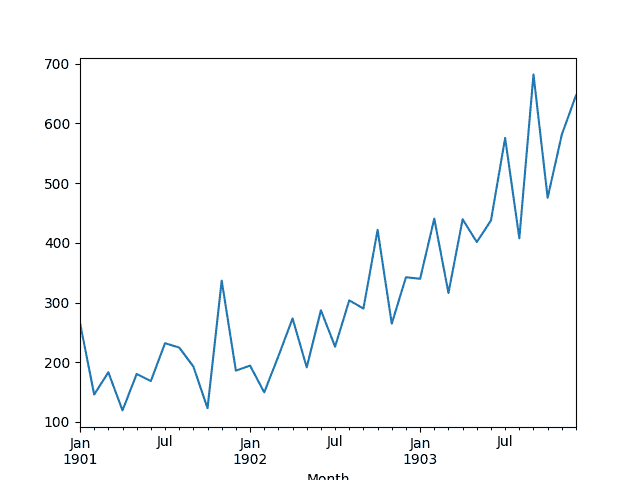

然后創建該系列的線圖,顯示明顯的增加趨勢。

洗發水銷售數據集的線圖

接下來,我們將看一下實驗中使用的模型配置和測試工具。

## 實驗測試線束

本節介紹本教程中使用的測試工具。

### 數據拆分

我們將 Shampoo Sales 數據集分為兩部分:訓練和測試集。

前兩年的數據將用于訓練數據集,剩余的一年數據將用于測試集。

將使用訓練數據集開發模型,并對測試數據集進行預測。

測試數據集的持久性預測(樸素預測)實現了每月洗發水銷售 136.761 的錯誤。這在測試集上提供了較低的可接受表現限制。

### 模型評估

將使用滾動預測場景,也稱為前進模型驗證。

測試數據集的每個時間步驟將一次一個地走。將使用模型對時間步長進行預測,然后將獲取測試集的實際預期值,并使其可用于下一時間步的預測模型。

這模仿了一個真實世界的場景,每個月都會有新的洗發水銷售觀察結果,并用于下個月的預測。

這將通過訓練和測試數據集的結構進行模擬。

將收集關于測試數據集的所有預測,并計算錯誤分數以總結模型的技能。將使用均方根誤差(RMSE),因為它會對大錯誤進行處罰,并產生與預測數據相同的分數,即每月洗發水銷售額。

### 數據準備

在我們將模型擬合到數據集之前,我們必須轉換數據。

在擬合模型和進行預測之前,對數據集執行以下三個數據變換。

1. 轉換時間序列數據,使其靜止不動。具體而言,滯后= 1 差分以消除數據中的增加趨勢。

2. 將時間序列轉換為監督學習問題。具體而言,將數據組織成輸入和輸出模式,其中前一時間步的觀察被用作預測當前時間步的觀察的輸入

3. 將觀察結果轉換為具有特定比例。具體而言,將數據重新調整為-1 到 1 之間的值。

這些變換在預測時反轉,在計算和誤差分數之前將它們恢復到原始比例。

### LSTM 模型

我們將使用基礎狀態 LSTM 模型,其中 1 個神經元適合 1000 個時期。

理想情況下,批量大小為 1 將用于步行前導驗證。我們將假設前進驗證并預測全年的速度。因此,我們可以使用任何可以按樣本數量分割的批量大小,在這種情況下,我們將使用值 4。

理想情況下,將使用更多的訓練時期(例如 1500),但這被截斷為 1000 以保持運行時間合理。

使用有效的 ADAM 優化算法和均方誤差損失函數來擬合模型。

### 實驗運行

每個實驗場景將運行 30 次,并且測試集上的 RMSE 得分將從每次運行結束時記錄。

讓我們深入研究實驗。

## 基線 LSTM 模型

讓我們從基線 LSTM 模型開始。

此問題的基線 LSTM 模型具有以下配置:

* 滯后輸入:1

* 時代:1000

* LSTM 隱藏層中的單位:3

* 批量大小:4

* 重復:3

完整的代碼清單如下。

此代碼清單將用作所有后續實驗的基礎,后續部分中僅提供對此代碼的更改。

```py

from pandas import DataFrame

from pandas import Series

from pandas import concat

from pandas import read_csv

from pandas import datetime

from sklearn.metrics import mean_squared_error

from sklearn.preprocessing import MinMaxScaler

from keras.models import Sequential

from keras.layers import Dense

from keras.layers import LSTM

from keras.regularizers import L1L2

from math import sqrt

import matplotlib

# be able to save images on server

matplotlib.use('Agg')

from matplotlib import pyplot

import numpy

# date-time parsing function for loading the dataset

def parser(x):

return datetime.strptime('190'+x, '%Y-%m')

# frame a sequence as a supervised learning problem

def timeseries_to_supervised(data, lag=1):

df = DataFrame(data)

columns = [df.shift(i) for i in range(1, lag+1)]

columns.append(df)

df = concat(columns, axis=1)

return df

# create a differenced series

def difference(dataset, interval=1):

diff = list()

for i in range(interval, len(dataset)):

value = dataset[i] - dataset[i - interval]

diff.append(value)

return Series(diff)

# invert differenced value

def inverse_difference(history, yhat, interval=1):

return yhat + history[-interval]

# scale train and test data to [-1, 1]

def scale(train, test):

# fit scaler

scaler = MinMaxScaler(feature_range=(-1, 1))

scaler = scaler.fit(train)

# transform train

train = train.reshape(train.shape[0], train.shape[1])

train_scaled = scaler.transform(train)

# transform test

test = test.reshape(test.shape[0], test.shape[1])

test_scaled = scaler.transform(test)

return scaler, train_scaled, test_scaled

# inverse scaling for a forecasted value

def invert_scale(scaler, X, yhat):

new_row = [x for x in X] + [yhat]

array = numpy.array(new_row)

array = array.reshape(1, len(array))

inverted = scaler.inverse_transform(array)

return inverted[0, -1]

# fit an LSTM network to training data

def fit_lstm(train, n_batch, nb_epoch, n_neurons):

X, y = train[:, 0:-1], train[:, -1]

X = X.reshape(X.shape[0], 1, X.shape[1])

model = Sequential()

model.add(LSTM(n_neurons, batch_input_shape=(n_batch, X.shape[1], X.shape[2]), stateful=True))

model.add(Dense(1))

model.compile(loss='mean_squared_error', optimizer='adam')

for i in range(nb_epoch):

model.fit(X, y, epochs=1, batch_size=n_batch, verbose=0, shuffle=False)

model.reset_states()

return model

# run a repeated experiment

def experiment(series, n_lag, n_repeats, n_epochs, n_batch, n_neurons):

# transform data to be stationary

raw_values = series.values

diff_values = difference(raw_values, 1)

# transform data to be supervised learning

supervised = timeseries_to_supervised(diff_values, n_lag)

supervised_values = supervised.values[n_lag:,:]

# split data into train and test-sets

train, test = supervised_values[0:-12], supervised_values[-12:]

# transform the scale of the data

scaler, train_scaled, test_scaled = scale(train, test)

# run experiment

error_scores = list()

for r in range(n_repeats):

# fit the model

train_trimmed = train_scaled[2:, :]

lstm_model = fit_lstm(train_trimmed, n_batch, n_epochs, n_neurons)

# forecast test dataset

test_reshaped = test_scaled[:,0:-1]

test_reshaped = test_reshaped.reshape(len(test_reshaped), 1, 1)

output = lstm_model.predict(test_reshaped, batch_size=n_batch)

predictions = list()

for i in range(len(output)):

yhat = output[i,0]

X = test_scaled[i, 0:-1]

# invert scaling

yhat = invert_scale(scaler, X, yhat)

# invert differencing

yhat = inverse_difference(raw_values, yhat, len(test_scaled)+1-i)

# store forecast

predictions.append(yhat)

# report performance

rmse = sqrt(mean_squared_error(raw_values[-12:], predictions))

print('%d) Test RMSE: %.3f' % (r+1, rmse))

error_scores.append(rmse)

return error_scores

# configure the experiment

def run():

# load dataset

series = read_csv('shampoo-sales.csv', header=0, parse_dates=[0], index_col=0, squeeze=True, date_parser=parser)

# configure the experiment

n_lag = 1

n_repeats = 30

n_epochs = 1000

n_batch = 4

n_neurons = 3

# run the experiment

results = DataFrame()

results['results'] = experiment(series, n_lag, n_repeats, n_epochs, n_batch, n_neurons)

# summarize results

print(results.describe())

# save boxplot

results.boxplot()

pyplot.savefig('experiment_baseline.png')

# entry point

run()

```

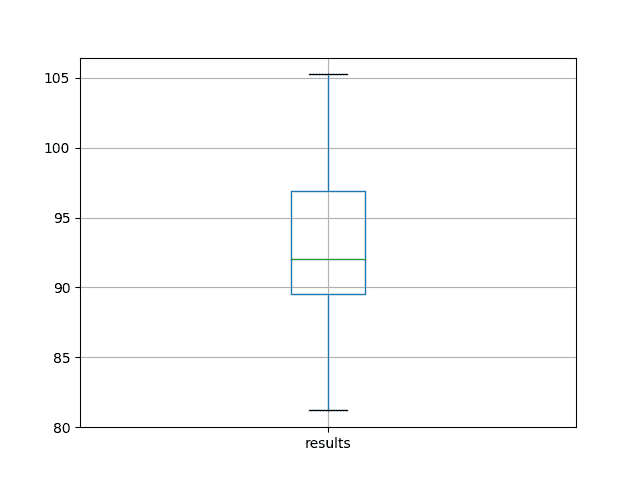

運行實驗將打印所有重復測試 RMSE 的摘要統計信息。

我們可以看到,平均而言,這種模型配置實現了約 92 個月洗發水銷售的測試 RMSE,標準偏差為 5。

```py

results

count 30.000000

mean 92.842537

std 5.748456

min 81.205979

25% 89.514367

50% 92.030003

75% 96.926145

max 105.247117

```

還會根據測試 RMSE 結果的分布創建一個盒子和胡須圖并保存到文件中。

該圖清楚地描述了結果的傳播,突出了中間 50%的值(框)和中位數(綠線)。

洗發水銷售數據集中基線表現的盒子和晶須圖

## 偏差權重正則化

權重正則化可以應用于 LSTM 節點內的偏置連接。

在 Keras 中,在創建 LSTM 層時使用 _bias_regularizer_ 參數指定。正則化器被定義為 L1,L2 或 L1L2 類之一的實例。

更多細節在這里:

* [Keras 用于規范制定者](https://keras.io/regularizers/)

在本實驗中,我們將 L1,L2 和 L1L2 與基線模型的默認值 0.01 進行比較。我們可以使用 L1L2 類指定所有配置,如下所示:

* L1L2(0.0,0.0)[例如基線]

* L1L2(0.01,0.0)[例如 L1]

* L1L2(0.0,0.01)[例如 L2]

* L1L2(0.01,0.01)[例如 L1L2 或彈性網]

下面列出了更新的 _fit_lstm()_,_ 實驗()_ 和 _run()_ 函數,用于使用 LSTM 的偏置權重正則化。

```py

# fit an LSTM network to training data

def fit_lstm(train, n_batch, nb_epoch, n_neurons, reg):

X, y = train[:, 0:-1], train[:, -1]

X = X.reshape(X.shape[0], 1, X.shape[1])

model = Sequential()

model.add(LSTM(n_neurons, batch_input_shape=(n_batch, X.shape[1], X.shape[2]), stateful=True, bias_regularizer=reg))

model.add(Dense(1))

model.compile(loss='mean_squared_error', optimizer='adam')

for i in range(nb_epoch):

model.fit(X, y, epochs=1, batch_size=n_batch, verbose=0, shuffle=False)

model.reset_states()

return model

# run a repeated experiment

def experiment(series, n_lag, n_repeats, n_epochs, n_batch, n_neurons, reg):

# transform data to be stationary

raw_values = series.values

diff_values = difference(raw_values, 1)

# transform data to be supervised learning

supervised = timeseries_to_supervised(diff_values, n_lag)

supervised_values = supervised.values[n_lag:,:]

# split data into train and test-sets

train, test = supervised_values[0:-12], supervised_values[-12:]

# transform the scale of the data

scaler, train_scaled, test_scaled = scale(train, test)

# run experiment

error_scores = list()

for r in range(n_repeats):

# fit the model

train_trimmed = train_scaled[2:, :]

lstm_model = fit_lstm(train_trimmed, n_batch, n_epochs, n_neurons, reg)

# forecast test dataset

test_reshaped = test_scaled[:,0:-1]

test_reshaped = test_reshaped.reshape(len(test_reshaped), 1, 1)

output = lstm_model.predict(test_reshaped, batch_size=n_batch)

predictions = list()

for i in range(len(output)):

yhat = output[i,0]

X = test_scaled[i, 0:-1]

# invert scaling

yhat = invert_scale(scaler, X, yhat)

# invert differencing

yhat = inverse_difference(raw_values, yhat, len(test_scaled)+1-i)

# store forecast

predictions.append(yhat)

# report performance

rmse = sqrt(mean_squared_error(raw_values[-12:], predictions))

print('%d) Test RMSE: %.3f' % (r+1, rmse))

error_scores.append(rmse)

return error_scores

# configure the experiment

def run():

# load dataset

series = read_csv('shampoo-sales.csv', header=0, parse_dates=[0], index_col=0, squeeze=True, date_parser=parser)

# configure the experiment

n_lag = 1

n_repeats = 30

n_epochs = 1000

n_batch = 4

n_neurons = 3

regularizers = [L1L2(l1=0.0, l2=0.0), L1L2(l1=0.01, l2=0.0), L1L2(l1=0.0, l2=0.01), L1L2(l1=0.01, l2=0.01)]

# run the experiment

results = DataFrame()

for reg in regularizers:

name = ('l1 %.2f,l2 %.2f' % (reg.l1, reg.l2))

results[name] = experiment(series, n_lag, n_repeats, n_epochs, n_batch, n_neurons, reg)

# summarize results

print(results.describe())

# save boxplot

results.boxplot()

pyplot.savefig('experiment_reg_bias.png')

```

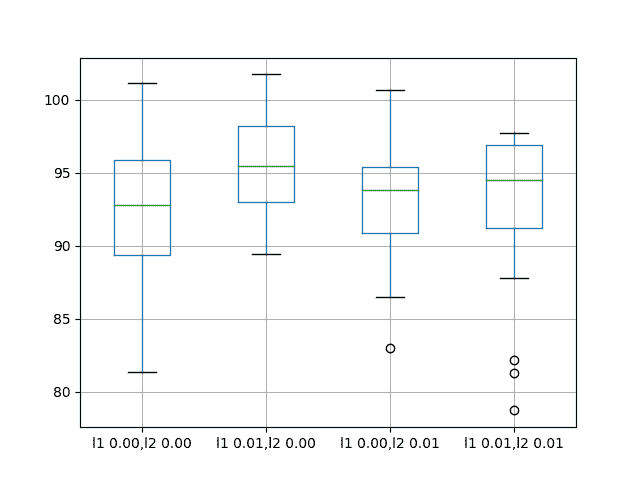

運行此實驗會打印每個已評估配置的描述性統計信息。

結果表明,與所考慮的所有其他配置相比,平均而言,無偏差正則化的默認值導致更好的表現。

```py

l1 0.00,l2 0.00 l1 0.01,l2 0.00 l1 0.00,l2 0.01 l1 0.01,l2 0.01

count 30.000000 30.000000 30.000000 30.000000

mean 92.821489 95.520003 93.285389 92.901021

std 4.894166 3.637022 3.906112 5.082358

min 81.394504 89.477398 82.994480 78.729224

25% 89.356330 93.017723 90.907343 91.210105

50% 92.822871 95.502700 93.837562 94.525965

75% 95.899939 98.195980 95.426270 96.882378

max 101.194678 101.750900 100.650130 97.766301

```

還會創建一個框和胡須圖來比較每個配置的結果分布。

該圖顯示所有配置具有大約相同的擴展,并且均勻地添加偏置正則化對該問題沒有幫助。

在洗發水銷售數據集中偏差重量正規化的盒子和晶須圖

## 輸入權重正則化

我們還可以將正則化應用于每個 LSTM 單元上的輸入連接。

在 Keras 中,這是通過將 _kernel_regularizer_ 參數設置為正則化類來實現的。

我們將測試與前一節中使用的相同的正則化器配置,具體為:

* L1L2(0.0,0.0)[例如基線]

* L1L2(0.01,0.0)[例如 L1]

* L1L2(0.0,0.01)[例如 L2]

* L1L2(0.01,0.01)[例如 L1L2 或彈性網]

下面列出了更新的 _fit_lstm()_,_ 實驗()_ 和 _run()_ 函數,用于使用 LSTM 的偏置權重正則化。

```py

# fit an LSTM network to training data

def fit_lstm(train, n_batch, nb_epoch, n_neurons, reg):

X, y = train[:, 0:-1], train[:, -1]

X = X.reshape(X.shape[0], 1, X.shape[1])

model = Sequential()

model.add(LSTM(n_neurons, batch_input_shape=(n_batch, X.shape[1], X.shape[2]), stateful=True, kernel_regularizer=reg))

model.add(Dense(1))

model.compile(loss='mean_squared_error', optimizer='adam')

for i in range(nb_epoch):

model.fit(X, y, epochs=1, batch_size=n_batch, verbose=0, shuffle=False)

model.reset_states()

return model

# run a repeated experiment

def experiment(series, n_lag, n_repeats, n_epochs, n_batch, n_neurons, reg):

# transform data to be stationary

raw_values = series.values

diff_values = difference(raw_values, 1)

# transform data to be supervised learning

supervised = timeseries_to_supervised(diff_values, n_lag)

supervised_values = supervised.values[n_lag:,:]

# split data into train and test-sets

train, test = supervised_values[0:-12], supervised_values[-12:]

# transform the scale of the data

scaler, train_scaled, test_scaled = scale(train, test)

# run experiment

error_scores = list()

for r in range(n_repeats):

# fit the model

train_trimmed = train_scaled[2:, :]

lstm_model = fit_lstm(train_trimmed, n_batch, n_epochs, n_neurons, reg)

# forecast test dataset

test_reshaped = test_scaled[:,0:-1]

test_reshaped = test_reshaped.reshape(len(test_reshaped), 1, 1)

output = lstm_model.predict(test_reshaped, batch_size=n_batch)

predictions = list()

for i in range(len(output)):

yhat = output[i,0]

X = test_scaled[i, 0:-1]

# invert scaling

yhat = invert_scale(scaler, X, yhat)

# invert differencing

yhat = inverse_difference(raw_values, yhat, len(test_scaled)+1-i)

# store forecast

predictions.append(yhat)

# report performance

rmse = sqrt(mean_squared_error(raw_values[-12:], predictions))

print('%d) Test RMSE: %.3f' % (r+1, rmse))

error_scores.append(rmse)

return error_scores

# configure the experiment

def run():

# load dataset

series = read_csv('shampoo-sales.csv', header=0, parse_dates=[0], index_col=0, squeeze=True, date_parser=parser)

# configure the experiment

n_lag = 1

n_repeats = 30

n_epochs = 1000

n_batch = 4

n_neurons = 3

regularizers = [L1L2(l1=0.0, l2=0.0), L1L2(l1=0.01, l2=0.0), L1L2(l1=0.0, l2=0.01), L1L2(l1=0.01, l2=0.01)]

# run the experiment

results = DataFrame()

for reg in regularizers:

name = ('l1 %.2f,l2 %.2f' % (reg.l1, reg.l2))

results[name] = experiment(series, n_lag, n_repeats, n_epochs, n_batch, n_neurons, reg)

# summarize results

print(results.describe())

# save boxplot

results.boxplot()

pyplot.savefig('experiment_reg_input.png')

```

運行此實驗會打印每個已評估配置的描述性統計信息。

結果表明,在輸入連接中增加重量正則化確實在這種設置上提供了全面的好處。

我們可以看到,對于所有配置,測試 RMSE 大約低 10 個單位,當 L1 和 L2 都組合成彈性網類型約束時,可能會帶來更多好處。

```py

l1 0.00,l2 0.00 l1 0.01,l2 0.00 l1 0.00,l2 0.01 l1 0.01,l2 0.01

count 30.000000 30.000000 30.000000 30.000000

mean 91.640028 82.118980 82.137198 80.471685

std 6.086401 4.116072 3.378984 2.212213

min 80.392310 75.705210 76.005173 76.550909

25% 88.025135 79.237822 79.698162 78.780802

50% 91.843761 81.235433 81.463882 80.283913

75% 94.860117 85.510177 84.563980 82.443390

max 105.820586 94.210503 90.823454 85.243135

```

還會創建一個框和胡須圖來比較每個配置的結果分布。

該圖顯示了輸入正則化的一般較低的誤差分布。結果還表明,隨著 L1L2 配置獲得更好的結果,正則化結果可能更加明顯。

這是一個令人鼓舞的發現,表明用于輸入正則化的具有不同 L1L2 值的額外實驗將是值得研究的。

洗發水銷售數據集中輸入重量正規化表現的盒子和晶須圖

## 復發性體重正則化

最后,我們還可以將正則化應用于每個 LSTM 單元上的循環連接。

在 Keras 中,這是通過將 _recurrent_regularizer_ 參數設置為正則化類來實現的。

我們將測試與前一節中使用的相同的正則化器配置,具體為:

* L1L2(0.0,0.0)[例如基線]

* L1L2(0.01,0.0)[例如 L1]

* L1L2(0.0,0.01)[例如 L2]

* L1L2(0.01,0.01)[例如 L1L2 或彈性網]

下面列出了更新的 _fit_lstm()_,_ 實驗()_ 和 _run()_ 函數,用于使用 LSTM 的偏置權重正則化。

```py

# fit an LSTM network to training data

def fit_lstm(train, n_batch, nb_epoch, n_neurons, reg):

X, y = train[:, 0:-1], train[:, -1]

X = X.reshape(X.shape[0], 1, X.shape[1])

model = Sequential()

model.add(LSTM(n_neurons, batch_input_shape=(n_batch, X.shape[1], X.shape[2]), stateful=True, recurrent_regularizer=reg))

model.add(Dense(1))

model.compile(loss='mean_squared_error', optimizer='adam')

for i in range(nb_epoch):

model.fit(X, y, epochs=1, batch_size=n_batch, verbose=0, shuffle=False)

model.reset_states()

return model

# run a repeated experiment

def experiment(series, n_lag, n_repeats, n_epochs, n_batch, n_neurons, reg):

# transform data to be stationary

raw_values = series.values

diff_values = difference(raw_values, 1)

# transform data to be supervised learning

supervised = timeseries_to_supervised(diff_values, n_lag)

supervised_values = supervised.values[n_lag:,:]

# split data into train and test-sets

train, test = supervised_values[0:-12], supervised_values[-12:]

# transform the scale of the data

scaler, train_scaled, test_scaled = scale(train, test)

# run experiment

error_scores = list()

for r in range(n_repeats):

# fit the model

train_trimmed = train_scaled[2:, :]

lstm_model = fit_lstm(train_trimmed, n_batch, n_epochs, n_neurons, reg)

# forecast test dataset

test_reshaped = test_scaled[:,0:-1]

test_reshaped = test_reshaped.reshape(len(test_reshaped), 1, 1)

output = lstm_model.predict(test_reshaped, batch_size=n_batch)

predictions = list()

for i in range(len(output)):

yhat = output[i,0]

X = test_scaled[i, 0:-1]

# invert scaling

yhat = invert_scale(scaler, X, yhat)

# invert differencing

yhat = inverse_difference(raw_values, yhat, len(test_scaled)+1-i)

# store forecast

predictions.append(yhat)

# report performance

rmse = sqrt(mean_squared_error(raw_values[-12:], predictions))

print('%d) Test RMSE: %.3f' % (r+1, rmse))

error_scores.append(rmse)

return error_scores

# configure the experiment

def run():

# load dataset

series = read_csv('shampoo-sales.csv', header=0, parse_dates=[0], index_col=0, squeeze=True, date_parser=parser)

# configure the experiment

n_lag = 1

n_repeats = 30

n_epochs = 1000

n_batch = 4

n_neurons = 3

regularizers = [L1L2(l1=0.0, l2=0.0), L1L2(l1=0.01, l2=0.0), L1L2(l1=0.0, l2=0.01), L1L2(l1=0.01, l2=0.01)]

# run the experiment

results = DataFrame()

for reg in regularizers:

name = ('l1 %.2f,l2 %.2f' % (reg.l1, reg.l2))

results[name] = experiment(series, n_lag, n_repeats, n_epochs, n_batch, n_neurons, reg)

# summarize results

print(results.describe())

# save boxplot

results.boxplot()

pyplot.savefig('experiment_reg_recurrent.png')

```

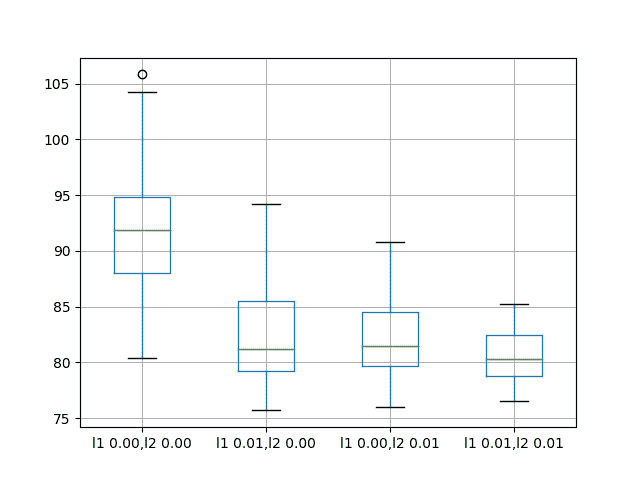

運行此實驗會打印每個已評估配置的描述性統計信息。

結果表明,對 LSTM 的復發連接使用正則化對此問題沒有明顯的好處。

嘗試的所有變化的平均表現導致比基線模型更差的表現。

```py

l1 0.00,l2 0.00 l1 0.01,l2 0.00 l1 0.00,l2 0.01 l1 0.01,l2 0.01

count 30.000000 30.000000 30.000000 30.000000

mean 92.918797 100.675386 101.302169 96.820026

std 7.172764 3.866547 5.228815 3.966710

min 72.967841 93.789854 91.063592 89.367600

25% 90.311185 98.014045 98.222732 94.787647

50% 92.327824 100.546756 101.903350 95.727549

75% 95.989761 103.491192 104.918266 98.240613

max 110.529422 108.788604 110.712064 111.185747

```

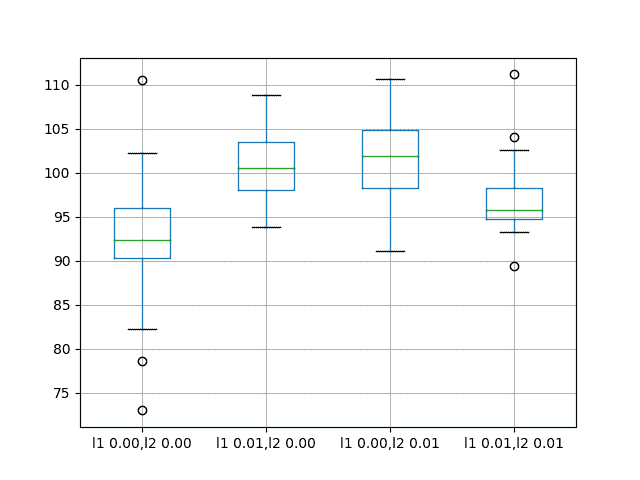

還會創建一個框和胡須圖來比較每個配置的結果分布。

該圖顯示了與摘要統計相同的故事,表明使用復發體重正則化幾乎沒有益處。

洗發水銷售數據集中復發重量正常化的盒子和晶須圖

## 擴展

本節列出了后續實驗的想法,以擴展本教程中的工作。

* **輸入權重正則化**。輸入權重正則化對該問題的實驗結果表明了上市績效的巨大希望。這可以通過網格搜索不同的 L1 和 L2 值來進一步研究,以找到最佳配置。

* **行為動態**。可以通過在訓練時期上繪制訓練和測試 RMSE 來研究每個權重正則化方案的動態行為,以獲得對過度擬合或欠擬合行為模式的權重正則化的想法。

* **結合正則化**。可以設計實驗來探索組合不同重量正則化方案的效果。

* **激活正則化**。 Keras 還支持激活正則化,這可能是探索對 LSTM 施加約束并減少過度擬合的另一種途徑。

## 摘要

在本教程中,您了解了如何將權重正則化與 LSTM 一起用于時間序列預測。

具體來說,你學到了:

* 如何設計一個強大的測試工具來評估 LSTM 網絡的時間序列預測。

* 如何在 LSTM 上配置偏差權重正則化用于時間序列預測。

* 如何在 LSTM 上配置輸入和循環權重正則化以進行時間序列預測。

您對使用 LSTM 網絡的權重正則化有任何疑問嗎?

在下面的評論中提出您的問題,我會盡力回答。

- Machine Learning Mastery 應用機器學習教程

- 5競爭機器學習的好處

- 過度擬合的簡單直覺,或者為什么測試訓練數據是一個壞主意

- 特征選擇簡介

- 應用機器學習作為一個搜索問題的溫和介紹

- 為什么應用機器學習很難

- 為什么我的結果不如我想的那么好?你可能過度擬合了

- 用ROC曲線評估和比較分類器表現

- BigML評論:發現本機學習即服務平臺的聰明功能

- BigML教程:開發您的第一個決策樹并進行預測

- 構建生產機器學習基礎設施

- 分類準確性不夠:可以使用更多表現測量

- 一種預測模型的巧妙應用

- 機器學習項目中常見的陷阱

- 數據清理:將凌亂的數據轉換為整潔的數據

- 機器學習中的數據泄漏

- 數據,學習和建模

- 數據管理至關重要以及為什么需要認真對待它

- 將預測模型部署到生產中

- 參數和超參數之間有什么區別?

- 測試和驗證數據集之間有什么區別?

- 發現特征工程,如何設計特征以及如何獲得它

- 如何開始使用Kaggle

- 超越預測

- 如何在評估機器學習算法時選擇正確的測試選項

- 如何定義機器學習問題

- 如何評估機器學習算法

- 如何獲得基線結果及其重要性

- 如何充分利用機器學習數據

- 如何識別數據中的異常值

- 如何提高機器學習效果

- 如何在競爭機器學習中踢屁股

- 如何知道您的機器學習模型是否具有良好的表現

- 如何布局和管理您的機器學習項目

- 如何為機器學習準備數據

- 如何減少最終機器學習模型中的方差

- 如何使用機器學習結果

- 如何解決像數據科學家這樣的問題

- 通過數據預處理提高模型精度

- 處理機器學習的大數據文件的7種方法

- 建立機器學習系統的經驗教訓

- 如何使用機器學習清單可靠地獲得準確的預測(即使您是初學者)

- 機器學習模型運行期間要做什么

- 機器學習表現改進備忘單

- 來自世界級從業者的機器學習技巧:Phil Brierley

- 模型預測精度與機器學習中的解釋

- 競爭機器學習的模型選擇技巧

- 機器學習需要多少訓練數據?

- 如何系統地規劃和運行機器學習實驗

- 應用機器學習過程

- 默認情況下可重現的機器學習結果

- 10個實踐應用機器學習的標準數據集

- 簡單的三步法到最佳機器學習算法

- 打擊機器學習數據集中不平衡類的8種策略

- 模型表現不匹配問題(以及如何處理)

- 黑箱機器學習的誘惑陷阱

- 如何培養最終的機器學習模型

- 使用探索性數據分析了解您的問題并獲得更好的結果

- 什么是數據挖掘和KDD

- 為什么One-Hot在機器學習中編碼數據?

- 為什么你應該在你的機器學習問題上進行抽樣檢查算法

- 所以,你正在研究機器學習問題......

- Machine Learning Mastery Keras 深度學習教程

- Keras 中神經網絡模型的 5 步生命周期

- 在 Python 迷你課程中應用深度學習

- Keras 深度學習庫的二元分類教程

- 如何用 Keras 構建多層感知器神經網絡模型

- 如何在 Keras 中檢查深度學習模型

- 10 個用于 Amazon Web Services 深度學習的命令行秘籍

- 機器學習卷積神經網絡的速成課程

- 如何在 Python 中使用 Keras 進行深度學習的度量

- 深度學習書籍

- 深度學習課程

- 你所知道的深度學習是一種謊言

- 如何設置 Amazon AWS EC2 GPU 以訓練 Keras 深度學習模型(分步)

- 神經網絡中批量和迭代之間的區別是什么?

- 在 Keras 展示深度學習模型訓練歷史

- 基于 Keras 的深度學習模型中的dropout正則化

- 評估 Keras 中深度學習模型的表現

- 如何評價深度學習模型的技巧

- 小批量梯度下降的簡要介紹以及如何配置批量大小

- 在 Keras 中獲得深度學習幫助的 9 種方法

- 如何使用 Keras 在 Python 中網格搜索深度學習模型的超參數

- 用 Keras 在 Python 中使用卷積神經網絡進行手寫數字識別

- 如何用 Keras 進行預測

- 用 Keras 進行深度學習的圖像增強

- 8 個深度學習的鼓舞人心的應用

- Python 深度學習庫 Keras 簡介

- Python 深度學習庫 TensorFlow 簡介

- Python 深度學習庫 Theano 簡介

- 如何使用 Keras 函數式 API 進行深度學習

- Keras 深度學習庫的多類分類教程

- 多層感知器神經網絡速成課程

- 基于卷積神經網絡的 Keras 深度學習庫中的目標識別

- 流行的深度學習庫

- 用深度學習預測電影評論的情感

- Python 中的 Keras 深度學習庫的回歸教程

- 如何使用 Keras 獲得可重現的結果

- 如何在 Linux 服務器上運行深度學習實驗

- 保存并加載您的 Keras 深度學習模型

- 用 Keras 逐步開發 Python 中的第一個神經網絡

- 用 Keras 理解 Python 中的有狀態 LSTM 循環神經網絡

- 在 Python 中使用 Keras 深度學習模型和 Scikit-Learn

- 如何使用預訓練的 VGG 模型對照片中的物體進行分類

- 在 Python 和 Keras 中對深度學習模型使用學習率調度

- 如何在 Keras 中可視化深度學習神經網絡模型

- 什么是深度學習?

- 何時使用 MLP,CNN 和 RNN 神經網絡

- 為什么用隨機權重初始化神經網絡?

- Machine Learning Mastery 深度學習 NLP 教程

- 深度學習在自然語言處理中的 7 個應用

- 如何實現自然語言處理的波束搜索解碼器

- 深度學習文檔分類的最佳實踐

- 關于自然語言處理的熱門書籍

- 在 Python 中計算文本 BLEU 分數的溫和介紹

- 使用編碼器 - 解碼器模型的用于字幕生成的注入和合并架構

- 如何用 Python 清理機器學習的文本

- 如何配置神經機器翻譯的編碼器 - 解碼器模型

- 如何開始深度學習自然語言處理(7 天迷你課程)

- 自然語言處理的數據集

- 如何開發一種深度學習的詞袋模型來預測電影評論情感

- 深度學習字幕生成模型的溫和介紹

- 如何在 Keras 中定義神經機器翻譯的編碼器 - 解碼器序列 - 序列模型

- 如何利用小實驗在 Keras 中開發字幕生成模型

- 如何從頭開發深度學習圖片標題生成器

- 如何在 Keras 中開發基于字符的神經語言模型

- 如何開發用于情感分析的 N-gram 多通道卷積神經網絡

- 如何從零開始開發神經機器翻譯系統

- 如何在 Python 中用 Keras 開發基于單詞的神經語言模型

- 如何開發一種預測電影評論情感的詞嵌入模型

- 如何使用 Gensim 在 Python 中開發詞嵌入

- 用于文本摘要的編碼器 - 解碼器深度學習模型

- Keras 中文本摘要的編碼器 - 解碼器模型

- 用于神經機器翻譯的編碼器 - 解碼器循環神經網絡模型

- 淺談詞袋模型

- 文本摘要的溫和介紹

- 編碼器 - 解碼器循環神經網絡中的注意力如何工作

- 如何利用深度學習自動生成照片的文本描述

- 如何開發一個單詞級神經語言模型并用它來生成文本

- 淺談神經機器翻譯

- 什么是自然語言處理?

- 牛津自然語言處理深度學習課程

- 如何為機器翻譯準備法語到英語的數據集

- 如何為情感分析準備電影評論數據

- 如何為文本摘要準備新聞文章

- 如何準備照片標題數據集以訓練深度學習模型

- 如何使用 Keras 為深度學習準備文本數據

- 如何使用 scikit-learn 為機器學習準備文本數據

- 自然語言處理神經網絡模型入門

- 對自然語言處理的深度學習的承諾

- 在 Python 中用 Keras 進行 LSTM 循環神經網絡的序列分類

- 斯坦福自然語言處理深度學習課程評價

- 統計語言建模和神經語言模型的簡要介紹

- 使用 Keras 在 Python 中進行 LSTM 循環神經網絡的文本生成

- 淺談機器學習中的轉換

- 如何使用 Keras 將詞嵌入層用于深度學習

- 什么是用于文本的詞嵌入

- Machine Learning Mastery 深度學習時間序列教程

- 如何開發人類活動識別的一維卷積神經網絡模型

- 人類活動識別的深度學習模型

- 如何評估人類活動識別的機器學習算法

- 時間序列預測的多層感知器網絡探索性配置

- 比較經典和機器學習方法進行時間序列預測的結果

- 如何通過深度學習快速獲得時間序列預測的結果

- 如何利用 Python 處理序列預測問題中的缺失時間步長

- 如何建立預測大氣污染日的概率預測模型

- 如何開發一種熟練的機器學習時間序列預測模型

- 如何構建家庭用電自回歸預測模型

- 如何開發多步空氣污染時間序列預測的自回歸預測模型

- 如何制定多站點多元空氣污染時間序列預測的基線預測

- 如何開發時間序列預測的卷積神經網絡模型

- 如何開發卷積神經網絡用于多步時間序列預測

- 如何開發單變量時間序列預測的深度學習模型

- 如何開發 LSTM 模型用于家庭用電的多步時間序列預測

- 如何開發 LSTM 模型進行時間序列預測

- 如何開發多元多步空氣污染時間序列預測的機器學習模型

- 如何開發多層感知器模型進行時間序列預測

- 如何開發人類活動識別時間序列分類的 RNN 模型

- 如何開始深度學習的時間序列預測(7 天迷你課程)

- 如何網格搜索深度學習模型進行時間序列預測

- 如何對單變量時間序列預測的網格搜索樸素方法

- 如何在 Python 中搜索 SARIMA 模型超參數用于時間序列預測

- 如何在 Python 中進行時間序列預測的網格搜索三次指數平滑

- 一個標準的人類活動識別問題的溫和介紹

- 如何加載和探索家庭用電數據

- 如何加載,可視化和探索復雜的多變量多步時間序列預測數據集

- 如何從智能手機數據模擬人類活動

- 如何根據環境因素預測房間占用率

- 如何使用腦波預測人眼是開放還是閉合

- 如何在 Python 中擴展長短期內存網絡的數據

- 如何使用 TimeseriesGenerator 進行 Keras 中的時間序列預測

- 基于機器學習算法的室內運動時間序列分類

- 用于時間序列預測的狀態 LSTM 在線學習的不穩定性

- 用于罕見事件時間序列預測的 LSTM 模型體系結構

- 用于時間序列預測的 4 種通用機器學習數據變換

- Python 中長短期記憶網絡的多步時間序列預測

- 家庭用電機器學習的多步時間序列預測

- Keras 中 LSTM 的多變量時間序列預測

- 如何開發和評估樸素的家庭用電量預測方法

- 如何為長短期記憶網絡準備單變量時間序列數據

- 循環神經網絡在時間序列預測中的應用

- 如何在 Python 中使用差異變換刪除趨勢和季節性

- 如何在 LSTM 中種子狀態用于 Python 中的時間序列預測

- 使用 Python 進行時間序列預測的有狀態和無狀態 LSTM

- 長短時記憶網絡在時間序列預測中的適用性

- 時間序列預測問題的分類

- Python 中長短期記憶網絡的時間序列預測

- 基于 Keras 的 Python 中 LSTM 循環神經網絡的時間序列預測

- Keras 中深度學習的時間序列預測

- 如何用 Keras 調整 LSTM 超參數進行時間序列預測

- 如何在時間序列預測訓練期間更新 LSTM 網絡

- 如何使用 LSTM 網絡的 Dropout 進行時間序列預測

- 如何使用 LSTM 網絡中的特征進行時間序列預測

- 如何在 LSTM 網絡中使用時間序列進行時間序列預測

- 如何利用 LSTM 網絡進行權重正則化進行時間序列預測

- Machine Learning Mastery 線性代數教程

- 機器學習數學符號的基礎知識

- 用 NumPy 陣列輕松介紹廣播

- 如何從 Python 中的 Scratch 計算主成分分析(PCA)

- 用于編碼器審查的計算線性代數

- 10 機器學習中的線性代數示例

- 線性代數的溫和介紹

- 用 NumPy 輕松介紹 Python 中的 N 維數組

- 機器學習向量的溫和介紹

- 如何在 Python 中為機器學習索引,切片和重塑 NumPy 數組

- 機器學習的矩陣和矩陣算法簡介

- 溫和地介紹機器學習的特征分解,特征值和特征向量

- NumPy 對預期價值,方差和協方差的簡要介紹

- 機器學習矩陣分解的溫和介紹

- 用 NumPy 輕松介紹機器學習的張量

- 用于機器學習的線性代數中的矩陣類型簡介

- 用于機器學習的線性代數備忘單

- 線性代數的深度學習

- 用于機器學習的線性代數(7 天迷你課程)

- 機器學習的線性代數

- 機器學習矩陣運算的溫和介紹

- 線性代數評論沒有廢話指南

- 學習機器學習線性代數的主要資源

- 淺談機器學習的奇異值分解

- 如何用線性代數求解線性回歸

- 用于機器學習的稀疏矩陣的溫和介紹

- 機器學習中向量規范的溫和介紹

- 學習線性代數用于機器學習的 5 個理由

- Machine Learning Mastery LSTM 教程

- Keras中長短期記憶模型的5步生命周期

- 長短時記憶循環神經網絡的注意事項

- CNN長短期記憶網絡

- 逆向神經網絡中的深度學習速成課程

- 可變長度輸入序列的數據準備

- 如何用Keras開發用于Python序列分類的雙向LSTM

- 如何開發Keras序列到序列預測的編碼器 - 解碼器模型

- 如何診斷LSTM模型的過度擬合和欠擬合

- 如何開發一種編碼器 - 解碼器模型,注重Keras中的序列到序列預測

- 編碼器 - 解碼器長短期存儲器網絡

- 神經網絡中爆炸梯度的溫和介紹

- 對時間反向傳播的溫和介紹

- 生成長短期記憶網絡的溫和介紹

- 專家對長短期記憶網絡的簡要介紹

- 在序列預測問題上充分利用LSTM

- 編輯器 - 解碼器循環神經網絡全局注意的溫和介紹

- 如何利用長短時記憶循環神經網絡處理很長的序列

- 如何在Python中對一個熱編碼序列數據

- 如何使用編碼器 - 解碼器LSTM來回顯隨機整數序列

- 具有注意力的編碼器 - 解碼器RNN體系結構的實現模式

- 學習使用編碼器解碼器LSTM循環神經網絡添加數字

- 如何學習長短時記憶循環神經網絡回聲隨機整數

- 具有Keras的長短期記憶循環神經網絡的迷你課程

- LSTM自動編碼器的溫和介紹

- 如何用Keras中的長短期記憶模型進行預測

- 用Python中的長短期內存網絡演示內存

- 基于循環神經網絡的序列預測模型的簡要介紹

- 深度學習的循環神經網絡算法之旅

- 如何重塑Keras中長短期存儲網絡的輸入數據

- 了解Keras中LSTM的返回序列和返回狀態之間的差異

- RNN展開的溫和介紹

- 5學習LSTM循環神經網絡的簡單序列預測問題的例子

- 使用序列進行預測

- 堆疊長短期內存網絡

- 什么是教師強制循環神經網絡?

- 如何在Python中使用TimeDistributed Layer for Long Short-Term Memory Networks

- 如何準備Keras中截斷反向傳播的序列預測

- 如何在使用LSTM進行訓練和預測時使用不同的批量大小

- Machine Learning Mastery 機器學習算法教程

- 機器學習算法之旅

- 用于機器學習的裝袋和隨機森林集合算法

- 從頭開始實施機器學習算法的好處

- 更好的樸素貝葉斯:從樸素貝葉斯算法中獲取最多的12個技巧

- 機器學習的提升和AdaBoost

- 選擇機器學習算法:Microsoft Azure的經驗教訓

- 機器學習的分類和回歸樹

- 什么是機器學習中的混淆矩陣

- 如何使用Python從頭開始創建算法測試工具

- 通過創建機器學習算法的目標列表來控制

- 從頭開始停止編碼機器學習算法

- 在實現機器學習算法時,不要從開源代碼開始

- 不要使用隨機猜測作為基線分類器

- 淺談機器學習中的概念漂移

- 溫和介紹機器學習中的偏差 - 方差權衡

- 機器學習的梯度下降

- 機器學習算法如何工作(他們學習輸入到輸出的映射)

- 如何建立機器學習算法的直覺

- 如何實現機器學習算法

- 如何研究機器學習算法行為

- 如何學習機器學習算法

- 如何研究機器學習算法

- 如何研究機器學習算法

- 如何在Python中從頭開始實現反向傳播算法

- 如何用Python從頭開始實現Bagging

- 如何用Python從頭開始實現基線機器學習算法

- 如何在Python中從頭開始實現決策樹算法

- 如何用Python從頭開始實現學習向量量化

- 如何利用Python從頭開始隨機梯度下降實現線性回歸

- 如何利用Python從頭開始隨機梯度下降實現Logistic回歸

- 如何用Python從頭開始實現機器學習算法表現指標

- 如何在Python中從頭開始實現感知器算法

- 如何在Python中從零開始實現隨機森林

- 如何在Python中從頭開始實現重采樣方法

- 如何用Python從頭開始實現簡單線性回歸

- 如何用Python從頭開始實現堆棧泛化(Stacking)

- K-Nearest Neighbors for Machine Learning

- 學習機器學習的向量量化

- 機器學習的線性判別分析

- 機器學習的線性回歸

- 使用梯度下降進行機器學習的線性回歸教程

- 如何在Python中從頭開始加載機器學習數據

- 機器學習的Logistic回歸

- 機器學習的Logistic回歸教程

- 機器學習算法迷你課程

- 如何在Python中從頭開始實現樸素貝葉斯

- 樸素貝葉斯機器學習

- 樸素貝葉斯機器學習教程

- 機器學習算法的過擬合和欠擬合

- 參數化和非參數機器學習算法

- 理解任何機器學習算法的6個問題

- 在機器學習中擁抱隨機性

- 如何使用Python從頭開始擴展機器學習數據

- 機器學習的簡單線性回歸教程

- 有監督和無監督的機器學習算法

- 用于機器學習的支持向量機

- 在沒有數學背景的情況下理解機器學習算法的5種技術

- 最好的機器學習算法

- 教程從頭開始在Python中實現k-Nearest Neighbors

- 通過從零開始實現它們來理解機器學習算法(以及繞過壞代碼的策略)

- 使用隨機森林:在121個數據集上測試179個分類器

- 為什么從零開始實現機器學習算法

- Machine Learning Mastery 機器學習入門教程

- 機器學習入門的四個步驟:初學者入門與實踐的自上而下策略

- 你應該培養的 5 個機器學習領域

- 一種選擇機器學習算法的數據驅動方法

- 機器學習中的分析與數值解

- 應用機器學習是一種精英政治

- 機器學習的基本概念

- 如何成為數據科學家

- 初學者如何在機器學習中弄錯

- 機器學習的最佳編程語言

- 構建機器學習組合

- 機器學習中分類與回歸的區別

- 評估自己作為數據科學家并利用結果建立驚人的數據科學團隊

- 探索 Kaggle 大師的方法論和心態:對 Diogo Ferreira 的采訪

- 擴展機器學習工具并展示掌握

- 通過尋找地標開始機器學習

- 溫和地介紹預測建模

- 通過提供結果在機器學習中獲得夢想的工作

- 如何開始機器學習:自學藍圖

- 開始并在機器學習方面取得進展

- 應用機器學習的 Hello World

- 初學者如何使用小型項目開始機器學習并在 Kaggle 上進行競爭

- 我如何開始機器學習? (簡短版)

- 我是如何開始機器學習的

- 如何在機器學習中取得更好的成績

- 如何從在銀行工作到擔任 Target 的高級數據科學家

- 如何學習任何機器學習工具

- 使用小型目標項目深入了解機器學習工具

- 獲得付費申請機器學習

- 映射機器學習工具的景觀

- 機器學習開發環境

- 機器學習金錢

- 程序員的機器學習

- 機器學習很有意思

- 機器學習是 Kaggle 比賽

- 機器學習現在很受歡迎

- 機器學習掌握方法

- 機器學習很重要

- 機器學習 Q& A:概念漂移,更好的結果和學習更快

- 缺乏自學機器學習的路線圖

- 機器學習很重要

- 快速了解任何機器學習工具(即使您是初學者)

- 機器學習工具

- 找到你的機器學習部落

- 機器學習在一年

- 通過競爭一致的大師 Kaggle

- 5 程序員在機器學習中開始犯錯誤

- 哲學畢業生到機器學習從業者(Brian Thomas 采訪)

- 機器學習入門的實用建議

- 實用機器學習問題

- 使用來自 UCI 機器學習庫的數據集練習機器學習

- 使用秘籍的任何機器學習工具快速啟動

- 程序員可以進入機器學習

- 程序員應該進入機器學習

- 項目焦點:Shashank Singh 的人臉識別

- 項目焦點:使用 Mahout 和 Konstantin Slisenko 進行堆棧交換群集

- 機器學習自學指南

- 4 個自學機器學習項目

- álvaroLemos 如何在數據科學團隊中獲得機器學習實習

- 如何思考機器學習

- 現實世界機器學習問題之旅

- 有關機器學習的有用知識

- 如果我沒有學位怎么辦?

- 如果我不是一個優秀的程序員怎么辦?

- 如果我不擅長數學怎么辦?

- 為什么機器學習算法會處理以前從未見過的數據?

- 是什么阻礙了你的機器學習目標?

- 什么是機器學習?

- 機器學習適合哪里?

- 為什么要進入機器學習?

- 研究對您來說很重要的機器學習問題

- 你這樣做是錯的。為什么機器學習不必如此困難

- Machine Learning Mastery Sklearn 教程

- Scikit-Learn 的溫和介紹:Python 機器學習庫

- 使用 Python 管道和 scikit-learn 自動化機器學習工作流程

- 如何以及何時使用帶有 scikit-learn 的校準分類模型

- 如何比較 Python 中的機器學習算法與 scikit-learn

- 用于機器學習開發人員的 Python 崩潰課程

- 用 scikit-learn 在 Python 中集成機器學習算法

- 使用重采樣評估 Python 中機器學習算法的表現

- 使用 Scikit-Learn 在 Python 中進行特征選擇

- Python 中機器學習的特征選擇

- 如何使用 scikit-learn 在 Python 中生成測試數據集

- scikit-learn 中的機器學習算法秘籍

- 如何使用 Python 處理丟失的數據

- 如何開始使用 Python 進行機器學習

- 如何使用 Scikit-Learn 在 Python 中加載數據

- Python 中概率評分方法的簡要介紹

- 如何用 Scikit-Learn 調整算法參數

- 如何在 Mac OS X 上安裝 Python 3 環境以進行機器學習和深度學習

- 使用 scikit-learn 進行機器學習簡介

- 從 shell 到一本帶有 Fernando Perez 單一工具的書的 IPython

- 如何使用 Python 3 為機器學習開發創建 Linux 虛擬機

- 如何在 Python 中加載機器學習數據

- 您在 Python 中的第一個機器學習項目循序漸進

- 如何使用 scikit-learn 進行預測

- 用于評估 Python 中機器學習算法的度量標準

- 使用 Pandas 為 Python 中的機器學習準備數據

- 如何使用 Scikit-Learn 為 Python 機器學習準備數據

- 項目焦點:使用 Artem Yankov 在 Python 中進行事件推薦

- 用于機器學習的 Python 生態系統

- Python 是應用機器學習的成長平臺

- Python 機器學習書籍

- Python 機器學習迷你課程

- 使用 Pandas 快速和骯臟的數據分析

- 使用 Scikit-Learn 重新調整 Python 中的機器學習數據

- 如何以及何時使用 ROC 曲線和精確調用曲線進行 Python 分類

- 使用 scikit-learn 在 Python 中保存和加載機器學習模型

- scikit-learn Cookbook 書評

- 如何使用 Anaconda 為機器學習和深度學習設置 Python 環境

- 使用 scikit-learn 在 Python 中進行 Spot-Check 分類機器學習算法

- 如何在 Python 中開發可重復使用的抽樣檢查算法框架

- 使用 scikit-learn 在 Python 中進行 Spot-Check 回歸機器學習算法

- 使用 Python 中的描述性統計來了解您的機器學習數據

- 使用 OpenCV,Python 和模板匹配來播放“哪里是 Waldo?”

- 使用 Pandas 在 Python 中可視化機器學習數據

- Machine Learning Mastery 統計學教程

- 淺談計算正態匯總統計量

- 非參數統計的溫和介紹

- Python中常態測試的溫和介紹

- 淺談Bootstrap方法

- 淺談機器學習的中心極限定理

- 淺談機器學習中的大數定律

- 機器學習的所有統計數據

- 如何計算Python中機器學習結果的Bootstrap置信區間

- 淺談機器學習的Chi-Squared測試

- 機器學習的置信區間

- 隨機化在機器學習中解決混雜變量的作用

- 機器學習中的受控實驗

- 機器學習統計學速成班

- 統計假設檢驗的關鍵值以及如何在Python中計算它們

- 如何在機器學習中談論數據(統計學和計算機科學術語)

- Python中數據可視化方法的簡要介紹

- Python中效果大小度量的溫和介紹

- 估計隨機機器學習算法的實驗重復次數

- 機器學習評估統計的溫和介紹

- 如何計算Python中的非參數秩相關性

- 如何在Python中計算數據的5位數摘要

- 如何在Python中從頭開始編寫學生t檢驗

- 如何在Python中生成隨機數

- 如何轉換數據以更好地擬合正態分布

- 如何使用相關來理解變量之間的關系

- 如何使用統計信息識別數據中的異常值

- 用于Python機器學習的隨機數生成器簡介

- k-fold交叉驗證的溫和介紹

- 如何計算McNemar的比較兩種機器學習量詞的測試

- Python中非參數統計顯著性測試簡介

- 如何在Python中使用參數統計顯著性測試

- 機器學習的預測間隔

- 應用統計學與機器學習的密切關系

- 如何使用置信區間報告分類器表現

- 統計數據分布的簡要介紹

- 15 Python中的統計假設檢驗(備忘單)

- 統計假設檢驗的溫和介紹

- 10如何在機器學習項目中使用統計方法的示例

- Python中統計功效和功耗分析的簡要介紹

- 統計抽樣和重新抽樣的簡要介紹

- 比較機器學習算法的統計顯著性檢驗

- 機器學習中統計容差區間的溫和介紹

- 機器學習統計書籍

- 評估機器學習模型的統計數據

- 機器學習統計(7天迷你課程)

- 用于機器學習的簡明英語統計

- 如何使用統計顯著性檢驗來解釋機器學習結果

- 什么是統計(為什么它在機器學習中很重要)?

- Machine Learning Mastery 時間序列入門教程

- 如何在 Python 中為時間序列預測創建 ARIMA 模型

- 用 Python 進行時間序列預測的自回歸模型

- 如何回溯機器學習模型的時間序列預測

- Python 中基于時間序列數據的基本特征工程

- R 的時間序列預測熱門書籍

- 10 挑戰機器學習時間序列預測問題

- 如何將時間序列轉換為 Python 中的監督學習問題

- 如何將時間序列數據分解為趨勢和季節性

- 如何用 ARCH 和 GARCH 模擬波動率進行時間序列預測

- 如何將時間序列數據集與 Python 區分開來

- Python 中時間序列預測的指數平滑的溫和介紹

- 用 Python 進行時間序列預測的特征選擇

- 淺談自相關和部分自相關

- 時間序列預測的 Box-Jenkins 方法簡介

- 用 Python 簡要介紹時間序列的時間序列預測

- 如何使用 Python 網格搜索 ARIMA 模型超參數

- 如何在 Python 中加載和探索時間序列數據

- 如何使用 Python 對 ARIMA 模型進行手動預測

- 如何用 Python 進行時間序列預測的預測

- 如何使用 Python 中的 ARIMA 進行樣本外預測

- 如何利用 Python 模擬殘差錯誤來糾正時間序列預測

- 使用 Python 進行數據準備,特征工程和時間序列預測的移動平均平滑

- 多步時間序列預測的 4 種策略

- 如何在 Python 中規范化和標準化時間序列數據

- 如何利用 Python 進行時間序列預測的基線預測

- 如何使用 Python 對時間序列預測數據進行功率變換

- 用于時間序列預測的 Python 環境

- 如何重構時間序列預測問題

- 如何使用 Python 重新采樣和插值您的時間序列數據

- 用 Python 編寫 SARIMA 時間序列預測

- 如何在 Python 中保存 ARIMA 時間序列預測模型

- 使用 Python 進行季節性持久性預測

- 基于 ARIMA 的 Python 歷史規模敏感性預測技巧分析

- 簡單的時間序列預測模型進行測試,這樣你就不會欺騙自己

- 標準多變量,多步驟和多站點時間序列預測問題

- 如何使用 Python 檢查時間序列數據是否是固定的

- 使用 Python 進行時間序列數據可視化

- 7 個機器學習的時間序列數據集

- 時間序列預測案例研究與 Python:波士頓每月武裝搶劫案

- Python 的時間序列預測案例研究:巴爾的摩的年度用水量

- 使用 Python 進行時間序列預測研究:法國香檳的月銷售額

- 使用 Python 的置信區間理解時間序列預測不確定性

- 11 Python 中的經典時間序列預測方法(備忘單)

- 使用 Python 進行時間序列預測表現測量

- 使用 Python 7 天迷你課程進行時間序列預測

- 時間序列預測作為監督學習

- 什么是時間序列預測?

- 如何使用 Python 識別和刪除時間序列數據的季節性

- 如何在 Python 中使用和刪除時間序列數據中的趨勢信息

- 如何在 Python 中調整 ARIMA 參數

- 如何用 Python 可視化時間序列殘差預測錯誤

- 白噪聲時間序列與 Python

- 如何通過時間序列預測項目

- Machine Learning Mastery XGBoost 教程

- 通過在 Python 中使用 XGBoost 提前停止來避免過度擬合

- 如何在 Python 中調優 XGBoost 的多線程支持

- 如何配置梯度提升算法

- 在 Python 中使用 XGBoost 進行梯度提升的數據準備

- 如何使用 scikit-learn 在 Python 中開發您的第一個 XGBoost 模型

- 如何在 Python 中使用 XGBoost 評估梯度提升模型

- 在 Python 中使用 XGBoost 的特征重要性和特征選擇

- 淺談機器學習的梯度提升算法

- 應用機器學習的 XGBoost 簡介

- 如何在 macOS 上為 Python 安裝 XGBoost

- 如何在 Python 中使用 XGBoost 保存梯度提升模型

- 從梯度提升開始,比較 165 個數據集上的 13 種算法

- 在 Python 中使用 XGBoost 和 scikit-learn 進行隨機梯度提升

- 如何使用 Amazon Web Services 在云中訓練 XGBoost 模型

- 在 Python 中使用 XGBoost 調整梯度提升的學習率

- 如何在 Python 中使用 XGBoost 調整決策樹的數量和大小

- 如何在 Python 中使用 XGBoost 可視化梯度提升決策樹

- 在 Python 中開始使用 XGBoost 的 7 步迷你課程