[TOC]

我們這篇文章就來試著分析下 HashMap 的源碼,由于 HashMap 底層涉及到太多方面,一篇文章總是不能面面俱到,所以我們可以帶著面試官常問的幾個問題去看源碼:

1. 了解底層如何存儲數據的

2. HashMap 的幾個主要方法

3. HashMap 是如何確定元素存儲位置的以及如何處理哈希沖突的

4. HashMap 擴容機制是怎樣的

5. JDK 1.8 在擴容和解決哈希沖突上對 HashMap 源碼做了哪些改動?有什么好處?

HashMap 的內部功能實現很多,本文主要從根據 key 獲取哈希桶數組索引位置、put 方法的詳細執行、擴容過程三個具有代表性的點深入展開講解。

### 1. 存儲結構

#### DK1.7 的存儲結構

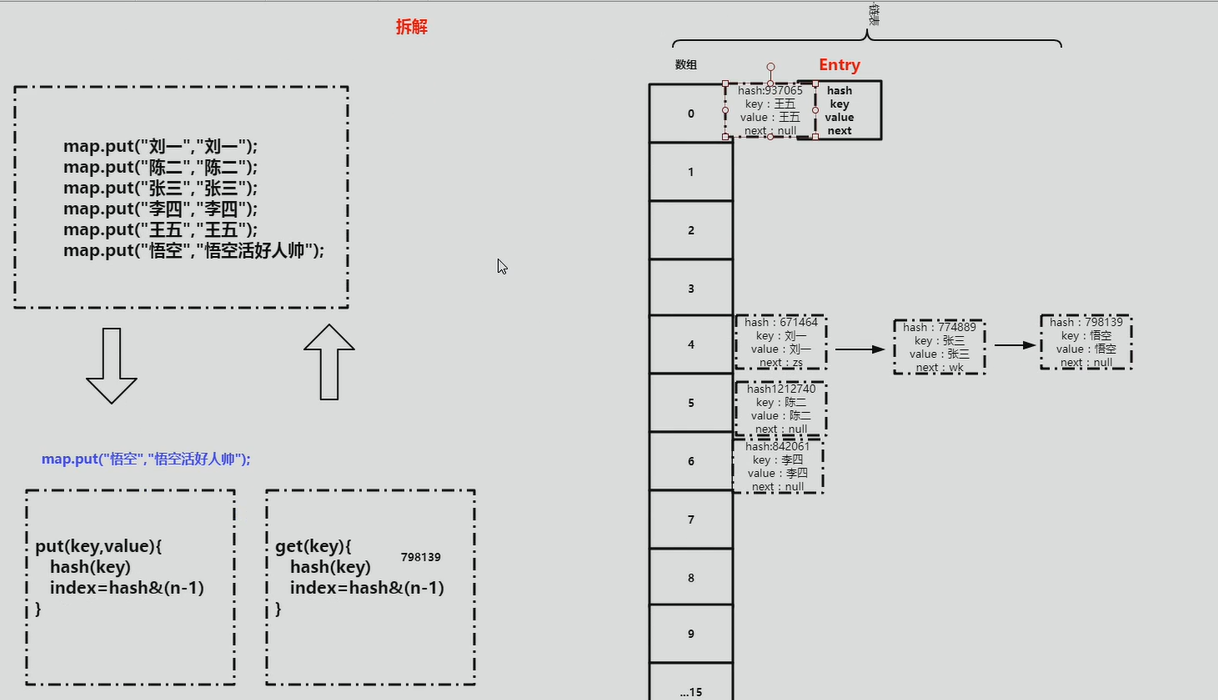

在 1.7 之前 JDK 采用「拉鏈法」來存儲數據,即數組和鏈表結合的方式:

:-:

「拉鏈法」用專業點的名詞來說叫做**鏈地址法**。簡單來說,就是數組加鏈表的結合。在每個數組元素上存儲的都是一個鏈表。

我們之前說到不同的 key 可能經過 hash 運算可能會得到相同的地址,但是一個數組單位上只能存放一個元素,采用鏈地址法以后,如果遇到相同的 hash 值的 key 的時候,我們可以將它放到作為數組元素的鏈表上。待我們去取元素的時候通過 hash 運算的結果找到這個鏈表,再在鏈表中找到與 key 相同的節點,就能找到 key 相應的值了。

JDK1.7 中新添加進來的元素總是放在數組相應的角標位置,而原來處于該角標的位置的節點作為 next 節點放到新節點的后邊。稍后通過源碼分析我們也能看到這一點。

#### JDK1.8 的存儲結構

對于 JDK1.8 之后的`HashMap`底層在解決哈希沖突的時候,就不單單是使用數組加上單鏈表的組合了,因為當處理如果 hash 值沖突較多的情況下,鏈表的長度就會越來越長,此時通過單鏈表來尋找對應 Key 對應的 Value 的時候就會使得時間復雜度達到 O(n),因此在 JDK1.8 之后,在鏈表新增節點導致鏈表長度超過`TREEIFY_THRESHOLD = 8`的時候,就會在添加元素的同時將原來的單鏈表轉化為紅黑樹。

對數據結構很在行的讀者應該,知道紅黑樹是一種易于增刪改查的二叉樹,他對與數據的查詢的時間復雜度是`O(logn)`級別,所以利用紅黑樹的特點就可以更高效的對`HashMap`中的元素進行操作。

:-:

從結構實現來講,HashMap 是數組+鏈表+紅黑樹(JDK1.8增加了紅黑樹部分)實現的,如下如所示。

1.

**這里需要講明白兩個問題:數據底層具體存儲的是什么?這樣的存儲方式有什么優點呢?**

(1)從源碼可知,HashMap 類中有一個非常重要的字段,就是 Node\[\] table,即哈希桶數組,明顯它是一個 Node 的數組。我們來看 Node( JDK1.8 中) 是何物。

~~~java

static class Node<K,V> implements Map.Entry<K,V> {

final int hash; //用來定位數組索引位置

final K key;

V value;

Node<K,V> next; //鏈表的下一個node

Node(int hash, K key, V value, Node<K,V> next) { ... }

public final K getKey(){ ... }

public final V getValue() { ... }

public final String toString() { ... }

public final int hashCode() { ... }

public final V setValue(V newValue) { ... }

public final boolean equals(Object o) { ... }

}

~~~

Node 是 HashMap 的一個內部類,實現了 Map.Entry 接口,本質是就是一個映射(鍵值對)。上圖中的每個黑色圓點就是一個Node對象。

(2)HashMap 就是使用哈希表來存儲的。哈希表為解決沖突,可以采用**開放地址法**和**鏈地址法**等來解決問題, Java 中 HashMap 采用了鏈地址法。鏈地址法,簡單來說,就是數組加鏈表的結合。在每個數組元素上都一個鏈表結構,當數據被 Hash 后,得到數組下標,把數據放在對應下標元素的鏈表上。例如程序執行下面代碼:

~~~java

map.put("美團","小美");

~~~

系統將調用 "美團" 這個 key 的 hashCode() 方法得到其 hashCode 值(該方法適用于每個 Java 對象),然后再通過 Hash 算法的后兩步運算(高位運算和取模運算,下文有介紹)來定位該鍵值對的存儲位置,有時兩個 key 會定位到相同的位置,表示發生了 Hash 碰撞。當然 Hash 算法計算結果越分散均勻,Hash 碰撞的概率就越小,map 的存取效率就會越高。

如果哈希桶數組很大,即使較差的 Hash 算法也會比較分散,如果哈希桶數組數組很小,即使好的 Hash 算法也會出現較多碰撞,所以就需要在空間成本和時間成本之間權衡,其實就是在根據實際情況確定哈希桶數組的大小,并在此基礎上設計好的 hash 算法減少 Hash 碰撞。

**那么通過什么方式來控制 map 使得 Hash 碰撞的概率又小,哈希桶數組(Node\[\] table)占用空間又少呢?**

答案就是好的 Hash 算法和擴容機制。

在理解 Hash 和擴容流程之前,我們得先了解下 HashMap 的幾個字段。從 HashMap 的默認構造函數源碼可知,構造函數就是對下面幾個字段進行初始化,源碼如下:

~~~java

int threshold; // 所能容納的key-value對極限

final float loadFactor; // 負載因子

int modCount;

int size;

~~~

首先,**Node\[\] table的初始化長度 length (默認值是16)**,**Load factor 為負載因子(默認值是0.75)**,threshold 是 HashMap 所能容納的最大數據量的 Node (鍵值對)個數。**threshold = length \* Load factor**。也就是說,在數組定義好長度之后,負載因子越大,所能容納的鍵值對個數越多。

結合負載因子的定義公式可知,threshold 就是在此 Load factor 和 length (數組長度)對應下允許的最大元素數目,超過這個數目就重新 resize(擴容),擴容后的 HashMap 容量是之前容量的兩倍。默認的負載因子 0.75 是對空間和時間效率的一個平衡選擇,建議大家不要修改,除非在時間和空間比較特殊的情況下,如果內存空間很多而又對時間效率要求很高,可以降低負載因子 Load factor 的值;相反,如果內存空間緊張而對時間效率要求不高,可以增加負載因子 loadFactor 的值,這個值可以大于1。

size 這個字段其實很好理解,就是 HashMap 中實際存在的鍵值對數量。注意和 table 的長度 length、容納最大鍵值對數量 threshold 的區別。而 modCount 字段主要用來記錄 HashMap 內部結構發生變化的次數,主要用于迭代的快速失敗。強調一點,內部結構發生變化指的是結構發生變化,例如 put 新鍵值對,但是某個 key 對應的 value 值被覆蓋不屬于結構變化。

在 HashMap 中,哈希桶數組 table 的長度 length 大小必須為 2n(一定是合數),這是一種非常規的設計,常規的設計是把桶的大小設計為素數。相對來說素數導致沖突的概率要小于合數,具體證明可以參考[為什么一般hashtable的桶數會取一個素數?](https://blog.csdn.net/liuqiyao_01/article/details/14475159),**Hashtable 初始化桶大小為 11,就是桶大小設計為素數的應用(Hashtable 擴容后不能保證還是素數)**。HashMap 采用這種非常規設計,**主要是為了在取模和擴容時做優化,同時為了減少沖突,HashMap 定位哈希桶索引位置時,也加入了高位參與運算的過程**。

這里存在一個問題,即使負載因子和 Hash 算法設計的再合理,也免不了會出現拉鏈過長的情況,一旦出現拉鏈過長,則會嚴重影響 HashMap 的性能。于是,在 JDK1.8 版本中,對數據結構做了進一步的優化,引入了紅黑樹。而當鏈表長度太長(默認超過8)時,鏈表就轉換為紅黑樹,利用紅黑樹快速增刪改查的特點提高 HashMap 的性能,其中會用到紅黑樹的插入、刪除、查找等算法。本文不再對紅黑樹展開討論,想了解更多紅黑樹數據結構的工作原理可以參考:[教你初步了解紅黑樹](https://blog.csdn.net/v_july_v/article/details/6105630)。

### 2\. 重要參數

| 參數 | 說明 |

| --- | --- |

| buckets | 在 HashMap 的注釋里使用哈希桶來形象的表示數組中每個地址位置。注意這里并不是數組本身,數組是裝哈希桶的,他可以被稱為**哈希表**。 |

| capacity | table 的容量大小,默認為 16。需要注意的是 capacity 必須保證為 2 的 n 次方。 |

| size | table 的實際使用量。 |

| threshold | size 的臨界值,size 必須小于 threshold,如果大于等于,就必須進行擴容操作。 |

| loadFactor | 裝載因子,table 能夠使用的比例,threshold = capacity \* loadFactor。 |

| TREEIFY\_THRESHOLD | 樹化閥值,哈希桶中的節點個數大于該值(默認為8)的時候將會被轉為紅黑樹行存儲結構。 |

| UNTREEIFY\_THRESHOLD | 非樹化閥值,小于該值(默認為 6)的時候將再次改為單鏈表的格式存儲 |

### 3\. 確定哈希桶數組索引位置

很多操作都需要先確定一個鍵值對所在的桶下標。

~~~java

int hash = hash(key);

int i = indexFor(hash, table.length);

~~~

(一)計算 hash 值

~~~java

final int hash(Object k) {

int h = hashSeed;

if (0 != h && k instanceof String) {

return sun.misc.Hashing.stringHash32((String) k);

}

h ^= k.hashCode();

// This function ensures that hashCodes that differ only by

// constant multiples at each bit position have a bounded

// number of collisions (approximately 8 at default load factor).

//此處通過一定的固定值的算法 得出相對分散的hash值 目的是為了減少碰撞

//JDK.1.8之后優化了這里的算法

h ^= (h >>> 20) ^ (h >>> 12);

return h ^ (h >>> 7) ^ (h >>> 4);

}

public final int hashCode() {

return Objects.hashCode(key) ^ Objects.hashCode(value);

}

~~~

(二)取模

令 x = 1<<4,即 x 為 2 的 4 次方,它具有以下性質:

~~~

x : 00010000

x-1 : 00001111

~~~

令一個數 y 與 x-1 做與運算,可以去除 y 位級表示的第 4 位以上數:

~~~

y : 10110010

x-1 : 00001111

y&(x-1) : 00000010

~~~

這個性質和 y 對 x 取模效果是一樣的:

~~~

y : 10110010

x : 00010000

y%x : 00000010

~~~

我們知道,位運算的代價比求模運算小的多,因此在進行這種計算時用位運算的話能帶來更高的性能。

確定桶下標的最后一步是將 key 的 hash 值對桶個數取模:hash%capacity,如果能保證 capacity 為 2 的 n 次方,那么就可以將這個操作轉換為位運算。

~~~java

static int indexFor(int h, int length) {

return h & (length-1);

}

~~~

### 4\. 分析HashMap的put方法

HashMap 的 put 方法執行過程可以通過下圖來理解,自己有興趣可以去對比源碼更清楚地研究學習。

1.

①.判斷鍵值對數組 table\[i\] 是否為空或為 null,否則執行 resize() 進行擴容;

②.根據鍵值 key 計算 hash 值得到插入的數組索引i,如果 table\[i\]==null,直接新建節點添加,轉向 ⑥,如果table\[i\] 不為空,轉向 ③;

③.判斷 table\[i\] 的首個元素是否和 key 一樣,如果相同直接覆蓋 value,否則轉向 ④,這里的相同指的是 hashCode 以及 equals;

④.判斷table\[i\] 是否為 treeNode,即 table\[i\] 是否是紅黑樹,如果是紅黑樹,則直接在樹中插入鍵值對,否則轉向 ⑤;

⑤.遍歷 table\[i\],判斷鏈表長度是否大于 8,大于 8 的話把鏈表轉換為紅黑樹,在紅黑樹中執行插入操作,否則進行鏈表的插入操作;遍歷過程中若發現 key 已經存在直接覆蓋 value 即可;

⑥.插入成功后,判斷實際存在的鍵值對數量 size 是否超多了最大容量 threshold,如果超過,進行擴容。

JDK1.8 HashMap 的 put 方法源碼如下:

~~~java

public V put(K key, V value) {

// 對key的hashCode()做hash

return putVal(hash(key), key, value, false, true);

}

final V putVal(int hash, K key, V value, boolean onlyIfAbsent,

boolean evict) {

Node<K,V>[] tab; Node<K,V> p; int n, i;

// 步驟①:tab為空則創建

if ((tab = table) == null || (n = tab.length) == 0)

n = (tab = resize()).length;

// 步驟②:計算index,并對null做處理

if ((p = tab[i = (n - 1) & hash]) == null)

tab[i] = newNode(hash, key, value, null);

else {

Node<K,V> e; K k;

// 步驟③:節點key存在,直接覆蓋value

if (p.hash == hash &&

((k = p.key) == key || (key != null && key.equals(k))))

e = p;

// 步驟④:判斷該鏈為紅黑樹

else if (p instanceof TreeNode)

e = ((TreeNode<K,V>)p).putTreeVal(this, tab, hash, key, value);

// 步驟⑤:該鏈為鏈表

else {

for (int binCount = 0; ; ++binCount) {

if ((e = p.next) == null) {

p.next = newNode(hash, key,value,null);

//鏈表長度大于8轉換為紅黑樹進行處理

if (binCount >= TREEIFY_THRESHOLD - 1) // -1 for 1st

treeifyBin(tab, hash);

break;

}

// key已經存在直接覆蓋value

if (e.hash == hash &&

((k = e.key) == key || (key != null && key.equals(k))))

break;

p = e;

}

}

if (e != null) { // existing mapping for key

V oldValue = e.value;

if (!onlyIfAbsent || oldValue == null)

e.value = value;

afterNodeAccess(e);

return oldValue;

}

}

++modCount;

// 步驟⑥:超過最大容量 就擴容

if (++size > threshold)

resize();

afterNodeInsertion(evict);

return null;

}

~~~

### 5\. 擴容機制

擴容 (resize) 就是重新計算容量,向 HashMap 對象里不停的添加元素,而 HashMap 對象內部的數組無法裝載更多的元素時,對象就需要擴大數組的長度,以便能裝入更多的元素。當然 Java 里的數組是無法自動擴容的,方法是使用一個新的數組代替已有的容量小的數組,就像我們用一個小桶裝水,如果想裝更多的水,就得換大水桶。

我們分析下 resize 的源碼,鑒于 JDK1.8 融入了紅黑樹,較復雜,為了便于理解我們仍然使用 JDK1.7 的代碼,好理解一些,本質上區別不大,具體區別后文再說。

~~~java

void resize(int newCapacity) { //傳入新的容量

Entry[] oldTable = table; //引用擴容前的Entry數組

int oldCapacity = oldTable.length;

if (oldCapacity == MAXIMUM_CAPACITY) { //擴容前的數組大小如果已經達到最大(2^30)了

threshold = Integer.MAX_VALUE; //修改閾值為int的最大值(2^31-1),這樣以后就不會擴容了

return;

}

Entry[] newTable = new Entry[newCapacity]; //初始化一個新的Entry數組

transfer(newTable); //!!將數據轉移到新的Entry數組里

table = newTable; //HashMap的table屬性引用新的Entry數組

threshold = (int)(newCapacity * loadFactor);//修改閾值

}

~~~

這里就是使用一個容量更大的數組來代替已有的容量小的數組,transfer() 方法將原有 Entry 數組的元素拷貝到新的 Entry 數組里。

~~~java

void transfer(Entry[] newTable) {

Entry[] src = table; //src引用了舊的Entry數組

int newCapacity = newTable.length;

for (int j = 0; j < src.length; j++) { //遍歷舊的Entry數組

Entry<K,V> e = src[j]; //取得舊Entry數組的每個元素

if (e != null) {

src[j] = null;//釋放舊Entry數組的對象引用(for循環后,舊的Entry數組不再引用任何對象)

do {

Entry<K,V> next = e.next;

int i = indexFor(e.hash, newCapacity); //!!重新計算每個元素在數組中的位置

e.next = newTable[i]; //標記[1]

newTable[i] = e; //將元素放在數組上

e = next; //訪問下一個Entry鏈上的元素

} while (e != null);

}

}

}

~~~

newTable\[i\] 的引用賦給了 e.next,也就是使用了單鏈表的頭插入方式,同一位置上新元素總會被放在鏈表的頭部位置;這樣先放在一個索引上的元素終會被放到 Entry 鏈的尾部(如果發生了 hash 沖突的話),這一點和 Jdk1.8 有區別,下文詳解。在舊數組中同一條 Entry 鏈上的元素,通過重新計算索引位置后,有可能被放到了新數組的不同位置上。

下面舉個例子說明下擴容過程。假設了我們的 hash 算法就是簡單的用 key mod 一下表的大小(也就是數組的長度)。其中的哈希桶數組 table 的 size=2, 所以 key = 3、7、5,put 順序依次為 5、7、3。在 mod 2 以后都沖突在 table\[1\] 這里了。這里假設負載因子 loadFactor=1,即當鍵值對的實際大小 size 大于 table 的實際大小時進行擴容。接下來的三個步驟是哈希桶數組 resize 成 4,然后所有的 Node 重新 rehash 的過程。

:-:

下面我們講解下 JDK1.8 做了哪些優化。經過觀測可以發現,我們使用的是 2 次冪的擴展 (指長度擴為原來 2 倍),所以,元素的位置要么是在原位置,要么是在原位置再移動 2 次冪的位置。看下圖可以明白這句話的意思,n 為 table 的長度,圖(a)表示擴容前的 key1 和 key2 兩種 key 確定索引位置的示例,圖(b)表示擴容后 key1 和 key2 兩種 key 確定索引位置的示例,其中 hash1 是 key1 對應的哈希與高位運算結果。

:-:

元素在重新計算 hash 之后,因為 n 變為 2 倍,那么 n-1 的 mask 范圍在高位多 1bit (紅色),因此新的 index 就會發生這樣的變化:

:-:

因此,我們在擴充 HashMap 的時候,不需要像 JDK1.7 的實現那樣重新計算 hash,只需要看看原來的 hash 值新增的那個 bit 是 1 還是 0 就好了,是 0 的話索引沒變,是 1 的話索引變成“原索引+oldCap”,可以看看下圖為 16 擴充為 32 的 resize 示意圖:

:-:

這個設計確實非常的巧妙,既省去了重新計算 hash 值的時間,而且同時,由于新增的 1bit 是 0 還是 1 可以認為是隨機的,因此 resize 的過程,均勻的把之前的沖突的節點分散到新的 bucket 了。這一塊就是 JDK1.8 新增的優化點。有一點注意區別,JDK1.7 中 rehash 的時候,舊鏈表遷移新鏈表的時候,如果在新表的數組索引位置相同,則鏈表元素會倒置,但是從上圖可以看出,JDK1.8 不會倒置。有興趣的同學可以研究下 JDK1.8 的 resize源 碼,寫的很贊,如下:

~~~java

final Node<K,V>[] resize() {

Node<K,V>[] oldTab = table;

int oldCap = (oldTab == null) ? 0 : oldTab.length;

int oldThr = threshold;

int newCap, newThr = 0;

if (oldCap > 0) {

// 超過最大值就不再擴充了,就只好隨你碰撞去吧

if (oldCap >= MAXIMUM_CAPACITY) {

threshold = Integer.MAX_VALUE;

return oldTab;

}

// 沒超過最大值,就擴充為原來的2倍

else if ((newCap = oldCap << 1) < MAXIMUM_CAPACITY &&

oldCap >= DEFAULT_INITIAL_CAPACITY)

newThr = oldThr << 1; // double threshold

}

else if (oldThr > 0) // initial capacity was placed in threshold

newCap = oldThr;

else { // zero initial threshold signifies using defaults

newCap = DEFAULT_INITIAL_CAPACITY;

newThr = (int)(DEFAULT_LOAD_FACTOR * DEFAULT_INITIAL_CAPACITY);

}

// 計算新的resize上限

if (newThr == 0) {

float ft = (float)newCap * loadFactor;

newThr = (newCap < MAXIMUM_CAPACITY && ft < (float)MAXIMUM_CAPACITY ?

(int)ft : Integer.MAX_VALUE);

}

threshold = newThr;

@SuppressWarnings({"rawtypes","unchecked"})

Node<K,V>[] newTab = (Node<K,V>[])new Node[newCap];

table = newTab;

if (oldTab != null) {

// 把每個bucket都移動到新的buckets中

for (int j = 0; j < oldCap; ++j) {

Node<K,V> e;

if ((e = oldTab[j]) != null) {

oldTab[j] = null;

if (e.next == null)

newTab[e.hash & (newCap - 1)] = e;

else if (e instanceof TreeNode)

((TreeNode<K,V>)e).split(this, newTab, j, oldCap);

else { // 鏈表優化重hash的代碼塊

Node<K,V> loHead = null, loTail = null;

Node<K,V> hiHead = null, hiTail = null;

Node<K,V> next;

do {

next = e.next;

// 原索引

if ((e.hash & oldCap) == 0) {

if (loTail == null)

loHead = e;

else

loTail.next = e;

loTail = e;

}

// 原索引+oldCap

else {

if (hiTail == null)

hiHead = e;

else

hiTail.next = e;

hiTail = e;

}

} while ((e = next) != null);

// 原索引放到bucket里

if (loTail != null) {

loTail.next = null;

newTab[j] = loHead;

}

// 原索引+oldCap放到bucket里

if (hiTail != null) {

hiTail.next = null;

newTab[j + oldCap] = hiHead;

}

}

}

}

}

return newTab;

}

~~~

### 6\. 線程安全性

在多線程使用場景中,應該盡量避免使用線程不安全的 HashMap,而使用線程安全的 ConcurrentHashMap。那么為什么說 HashMap 是線程不安全的,下面舉例子說明在并發的多線程使用場景中使用 HashMap 可能造成死循環。代碼例子如下(便于理解,仍然使用 JDK1.7 的環境):

~~~java

public class HashMapInfiniteLoop {

private static HashMap<Integer,String> map = new HashMap<Integer,String>(2,0.75f);

public static void main(String[] args) {

map.put(5, "C");

new Thread("Thread1") {

public void run() {

map.put(7, "B");

System.out.println(map);

};

}.start();

new Thread("Thread2") {

public void run() {

map.put(3, "A);

System.out.println(map);

};

}.start();

}

}

~~~

其中,map初始化為一個長度為2的數組,loadFactor=0.75,threshold=2\*0.75=1,也就是說當put第二個key的時候,map就需要進行resize。

通過設置斷點讓線程1和線程2同時debug到transfer方法(3.3小節代碼塊)的首行。注意此時兩個線程已經成功添加數據。放開thread1的斷點至transfer方法的“Entry next = e.next;” 這一行;然后放開線程2的的斷點,讓線程2進行resize。結果如下圖。

:-:

注意,Thread1的 e 指向了key(3),而next指向了key(7),其在線程二rehash后,指向了線程二重組后的鏈表。

線程一被調度回來執行,先是執行 newTalbe\[i\] = e, 然后是e = next,導致了e指向了key(7),而下一次循環的next = e.next導致了next指向了key(3)。

:-:

:-:

e.next = newTable\[i\] 導致 key(3).next 指向了 key(7)。注意:此時的key(7).next 已經指向了key(3), 環形鏈表就這樣出現了。

:-:

于是,當我們用線程一調用map.get(11)時,悲劇就出現了——Infinite Loop。

### 7\. JDK1.8與JDK1.7的性能對比

HashMap中,如果key經過hash算法得出的數組索引位置全部不相同,即Hash算法非常好,那樣的話,getKey方法的時間復雜度就是O(1),如果Hash算法技術的結果碰撞非常多,假如Hash算極其差,所有的Hash算法結果得出的索引位置一樣,那樣所有的鍵值對都集中到一個桶中,或者在一個鏈表中,或者在一個紅黑樹中,時間復雜度分別為O(n)和O(lgn)。 鑒于JDK1.8做了多方面的優化,總體性能優于JDK1.7,下面我們從兩個方面用例子證明這一點。

### 8\. Hash較均勻的情況

為了便于測試,我們先寫一個類Key,如下:

~~~java

class Key implements Comparable<Key> {

private final int value;

Key(int value) {

this.value = value;

}

@Override

public int compareTo(Key o) {

return Integer.compare(this.value, o.value);

}

@Override

public boolean equals(Object o) {

if (this == o) return true;

if (o == null || getClass() != o.getClass())

return false;

Key key = (Key) o;

return value == key.value;

}

@Override

public int hashCode() {

return value;

}

}

~~~

這個類復寫了equals方法,并且提供了相當好的hashCode函數,任何一個值的hashCode都不會相同,因為直接使用value當做hashcode。為了避免頻繁的GC,我將不變的Key實例緩存了起來,而不是一遍一遍的創建它們。代碼如下:

~~~java

public class Keys {

public static final int MAX_KEY = 10_000_000;

private static final Key[] KEYS_CACHE = new Key[MAX_KEY];

static {

for (int i = 0; i < MAX_KEY; ++i) {

KEYS_CACHE[i] = new Key(i);

}

}

public static Key of(int value) {

return KEYS_CACHE[value];

}

}

~~~

現在開始我們的試驗,測試需要做的僅僅是,創建不同size的HashMap(1、10、100、......10000000),屏蔽了擴容的情況,代碼如下:

~~~java

static void test(int mapSize) {

HashMap<Key, Integer> map = new HashMap<Key,Integer>(mapSize);

for (int i = 0; i < mapSize; ++i) {

map.put(Keys.of(i), i);

}

long beginTime = System.nanoTime(); //獲取納秒

for (int i = 0; i < mapSize; i++) {

map.get(Keys.of(i));

}

long endTime = System.nanoTime();

System.out.println(endTime - beginTime);

}

public static void main(String[] args) {

for(int i=10;i<= 1000 0000;i*= 10){

test(i);

}

}

~~~

在測試中會查找不同的值,然后度量花費的時間,為了計算getKey的平均時間,我們遍歷所有的get方法,計算總的時間,除以key的數量,計算一個平均值,主要用來比較,絕對值可能會受很多環境因素的影響。結果如下:

:-:

通過觀測測試結果可知,JDK1.8的性能要高于JDK1.7 15%以上,在某些size的區域上,甚至高于100%。由于Hash算法較均勻,JDK1.8引入的紅黑樹效果不明顯,下面我們看看Hash不均勻的的情況。

### 9\. Hash極不均勻的情況

假設我們又一個非常差的Key,它們所有的實例都返回相同的hashCode值。這是使用HashMap最壞的情況。代碼修改如下:

~~~java

class Key implements Comparable<Key> {

//...

@Override

public int hashCode() {

return 1;

}

}

~~~

仍然執行main方法,得出的結果如下表所示:

:-:

從表中結果中可知,隨著size的變大,JDK1.7的花費時間是增長的趨勢,而JDK1.8是明顯的降低趨勢,并且呈現對數增長穩定。當一個鏈表太長的時候,HashMap會動態的將它替換成一個紅黑樹,這話的話會將時間復雜度從O(n)降為O(logn)。hash算法均勻和不均勻所花費的時間明顯也不相同,這兩種情況的相對比較,可以說明一個好的hash算法的重要性。

測試環境:處理器為2.2 GHz Intel Core i7,內存為16 GB 1600 MHz DDR3,SSD硬盤,使用默認的JVM參數,運行在64位的OS X 10.10.1上。

### 10\. HashMap與HashTable

1. HashTable 使用 synchronized 來進行同步。

2. HashMap 可以插入鍵為 null 的 Entry。

3. HashMap 的迭代器是 fail-fast 迭代器。

4. HashMap 不能保證隨著時間的推移 Map 中的元素次序是不變的。

### 11\. 小結

1. 擴容是一個特別耗性能的操作,所以當程序員在使用 HashMap 的時候,估算 map 的大小,初始化的時候給一個大致的數值,避免 map 進行頻繁的擴容。

2. 負載因子是可以修改的,也可以大于1,但是建議不要輕易修改,除非情況非常特殊。

3. HashMap 是線程不安全的,不要在并發的環境中同時操作 HashMap,建議使用 ConcurrentHashMap。

4. JDK1.8 引入紅黑樹大程度優化了 HashMap 的性能。

參考資料:

* [Java 8系列之重新認識HashMap——美團技術](https://tech.meituan.com/java_hashmap.html)

* [搞懂 Java HashMap 源碼 - 掘金](https://juejin.im/post/5ac83fa35188255c5668afd0)

* [搞懂 Java equals 和 hashCode 方法 - 掘金](https://juejin.im/post/5ac4d8abf265da23a4050ae3)

- 一.JVM

- 1.1 java代碼是怎么運行的

- 1.2 JVM的內存區域

- 1.3 JVM運行時內存

- 1.4 JVM內存分配策略

- 1.5 JVM類加載機制與對象的生命周期

- 1.6 常用的垃圾回收算法

- 1.7 JVM垃圾收集器

- 1.8 CMS垃圾收集器

- 1.9 G1垃圾收集器

- 2.面試相關文章

- 2.1 可能是把Java內存區域講得最清楚的一篇文章

- 2.0 GC調優參數

- 2.1GC排查系列

- 2.2 內存泄漏和內存溢出

- 2.2.3 深入理解JVM-hotspot虛擬機對象探秘

- 1.10 并發的可達性分析相關問題

- 二.Java集合架構

- 1.ArrayList深入源碼分析

- 2.Vector深入源碼分析

- 3.LinkedList深入源碼分析

- 4.HashMap深入源碼分析

- 5.ConcurrentHashMap深入源碼分析

- 6.HashSet,LinkedHashSet 和 LinkedHashMap

- 7.容器中的設計模式

- 8.集合架構之面試指南

- 9.TreeSet和TreeMap

- 三.Java基礎

- 1.基礎概念

- 1.1 Java程序初始化的順序是怎么樣的

- 1.2 Java和C++的區別

- 1.3 反射

- 1.4 注解

- 1.5 泛型

- 1.6 字節與字符的區別以及訪問修飾符

- 1.7 深拷貝與淺拷貝

- 1.8 字符串常量池

- 2.面向對象

- 3.關鍵字

- 4.基本數據類型與運算

- 5.字符串與數組

- 6.異常處理

- 7.Object 通用方法

- 8.Java8

- 8.1 Java 8 Tutorial

- 8.2 Java 8 數據流(Stream)

- 8.3 Java 8 并發教程:線程和執行器

- 8.4 Java 8 并發教程:同步和鎖

- 8.5 Java 8 并發教程:原子變量和 ConcurrentMap

- 8.6 Java 8 API 示例:字符串、數值、算術和文件

- 8.7 在 Java 8 中避免 Null 檢查

- 8.8 使用 Intellij IDEA 解決 Java 8 的數據流問題

- 四.Java 并發編程

- 1.線程的實現/創建

- 2.線程生命周期/狀態轉換

- 3.線程池

- 4.線程中的協作、中斷

- 5.Java鎖

- 5.1 樂觀鎖、悲觀鎖和自旋鎖

- 5.2 Synchronized

- 5.3 ReentrantLock

- 5.4 公平鎖和非公平鎖

- 5.3.1 說說ReentrantLock的實現原理,以及ReentrantLock的核心源碼是如何實現的?

- 5.5 鎖優化和升級

- 6.多線程的上下文切換

- 7.死鎖的產生和解決

- 8.J.U.C(java.util.concurrent)

- 0.簡化版(快速復習用)

- 9.鎖優化

- 10.Java 內存模型(JMM)

- 11.ThreadLocal詳解

- 12 CAS

- 13.AQS

- 0.ArrayBlockingQueue和LinkedBlockingQueue的實現原理

- 1.DelayQueue的實現原理

- 14.Thread.join()實現原理

- 15.PriorityQueue 的特性和原理

- 16.CyclicBarrier的實際使用場景

- 五.Java I/O NIO

- 1.I/O模型簡述

- 2.Java NIO之緩沖區

- 3.JAVA NIO之文件通道

- 4.Java NIO之套接字通道

- 5.Java NIO之選擇器

- 6.基于 Java NIO 實現簡單的 HTTP 服務器

- 7.BIO-NIO-AIO

- 8.netty(一)

- 9.NIO面試題

- 六.Java設計模式

- 1.單例模式

- 2.策略模式

- 3.模板方法

- 4.適配器模式

- 5.簡單工廠

- 6.門面模式

- 7.代理模式

- 七.數據結構和算法

- 1.什么是紅黑樹

- 2.二叉樹

- 2.1 二叉樹的前序、中序、后序遍歷

- 3.排序算法匯總

- 4.java實現鏈表及鏈表的重用操作

- 4.1算法題-鏈表反轉

- 5.圖的概述

- 6.常見的幾道字符串算法題

- 7.幾道常見的鏈表算法題

- 8.leetcode常見算法題1

- 9.LRU緩存策略

- 10.二進制及位運算

- 10.1.二進制和十進制轉換

- 10.2.位運算

- 11.常見鏈表算法題

- 12.算法好文推薦

- 13.跳表

- 八.Spring 全家桶

- 1.Spring IOC

- 2.Spring AOP

- 3.Spring 事務管理

- 4.SpringMVC 運行流程和手動實現

- 0.Spring 核心技術

- 5.spring如何解決循環依賴問題

- 6.springboot自動裝配原理

- 7.Spring中的循環依賴解決機制中,為什么要三級緩存,用二級緩存不夠嗎

- 8.beanFactory和factoryBean有什么區別

- 九.數據庫

- 1.mybatis

- 1.1 MyBatis-# 與 $ 區別以及 sql 預編譯

- Mybatis系列1-Configuration

- Mybatis系列2-SQL執行過程

- Mybatis系列3-之SqlSession

- Mybatis系列4-之Executor

- Mybatis系列5-StatementHandler

- Mybatis系列6-MappedStatement

- Mybatis系列7-參數設置揭秘(ParameterHandler)

- Mybatis系列8-緩存機制

- 2.淺談聚簇索引和非聚簇索引的區別

- 3.mysql 證明為什么用limit時,offset很大會影響性能

- 4.MySQL中的索引

- 5.數據庫索引2

- 6.面試題收集

- 7.MySQL行鎖、表鎖、間隙鎖詳解

- 8.數據庫MVCC詳解

- 9.一條SQL查詢語句是如何執行的

- 10.MySQL 的 crash-safe 原理解析

- 11.MySQL 性能優化神器 Explain 使用分析

- 12.mysql中,一條update語句執行的過程是怎么樣的?期間用到了mysql的哪些log,分別有什么作用

- 十.Redis

- 0.快速復習回顧Redis

- 1.通俗易懂的Redis數據結構基礎教程

- 2.分布式鎖(一)

- 3.分布式鎖(二)

- 4.延時隊列

- 5.位圖Bitmaps

- 6.Bitmaps(位圖)的使用

- 7.Scan

- 8.redis緩存雪崩、緩存擊穿、緩存穿透

- 9.Redis為什么是單線程、及高并發快的3大原因詳解

- 10.布隆過濾器你值得擁有的開發利器

- 11.Redis哨兵、復制、集群的設計原理與區別

- 12.redis的IO多路復用

- 13.相關redis面試題

- 14.redis集群

- 十一.中間件

- 1.RabbitMQ

- 1.1 RabbitMQ實戰,hello world

- 1.2 RabbitMQ 實戰,工作隊列

- 1.3 RabbitMQ 實戰, 發布訂閱

- 1.4 RabbitMQ 實戰,路由

- 1.5 RabbitMQ 實戰,主題

- 1.6 Spring AMQP 的 AMQP 抽象

- 1.7 Spring AMQP 實戰 – 整合 RabbitMQ 發送郵件

- 1.8 RabbitMQ 的消息持久化與 Spring AMQP 的實現剖析

- 1.9 RabbitMQ必備核心知識

- 2.RocketMQ 的幾個簡單問題與答案

- 2.Kafka

- 2.1 kafka 基礎概念和術語

- 2.2 Kafka的重平衡(Rebalance)

- 2.3.kafka日志機制

- 2.4 kafka是pull還是push的方式傳遞消息的?

- 2.5 Kafka的數據處理流程

- 2.6 Kafka的腦裂預防和處理機制

- 2.7 Kafka中partition副本的Leader選舉機制

- 2.8 如果Leader掛了的時候,follower沒來得及同步,是否會出現數據不一致

- 2.9 kafka的partition副本是否會出現腦裂情況

- 十二.Zookeeper

- 0.什么是Zookeeper(漫畫)

- 1.使用docker安裝Zookeeper偽集群

- 3.ZooKeeper-Plus

- 4.zk實現分布式鎖

- 5.ZooKeeper之Watcher機制

- 6.Zookeeper之選舉及數據一致性

- 十三.計算機網絡

- 1.進制轉換:二進制、八進制、十六進制、十進制之間的轉換

- 2.位運算

- 3.計算機網絡面試題匯總1

- 十四.Docker

- 100.面試題收集合集

- 1.美團面試常見問題總結

- 2.b站部分面試題

- 3.比心面試題

- 4.騰訊面試題

- 5.哈羅部分面試

- 6.筆記

- 十五.Storm

- 1.Storm和流處理簡介

- 2.Storm 核心概念詳解

- 3.Storm 單機版本環境搭建

- 4.Storm 集群環境搭建

- 5.Storm 編程模型詳解

- 6.Storm 項目三種打包方式對比分析

- 7.Storm 集成 Redis 詳解

- 8.Storm 集成 HDFS 和 HBase

- 9.Storm 集成 Kafka

- 十六.Elasticsearch

- 1.初識ElasticSearch

- 2.文檔基本CRUD、集群健康檢查

- 3.shard&replica

- 4.document核心元數據解析及ES的并發控制

- 5.document的批量操作及數據路由原理

- 6.倒排索引

- 十七.分布式相關

- 1.分布式事務解決方案一網打盡

- 2.關于xxx怎么保證高可用的問題

- 3.一致性hash原理與實現

- 4.微服務注冊中心 Nacos 比 Eureka的優勢

- 5.Raft 協議算法

- 6.為什么微服務架構中需要網關

- 0.CAP與BASE理論

- 十八.Dubbo

- 1.快速掌握Dubbo常規應用

- 2.Dubbo應用進階

- 3.Dubbo調用模塊詳解

- 4.Dubbo調用模塊源碼分析

- 6.Dubbo協議模塊