[TOC]

# RabbitMq怎么保證高可用

RabbitMQ是一個比較有代表性的消息中間件,因為是基于主從做的高可用架構、我們就以它為例子來聊下其高可用是如何實現的。

RabbitMQ有三種模式:單機模式、普通集群模式、鏡像集群模式。

## 1.1 單機模式

單機模式就是處于一種demo模式、一般就是自己本地搞一個玩玩,生產環境沒有那個哥們會使用單機模式的。

## 1.2 普通集群模式

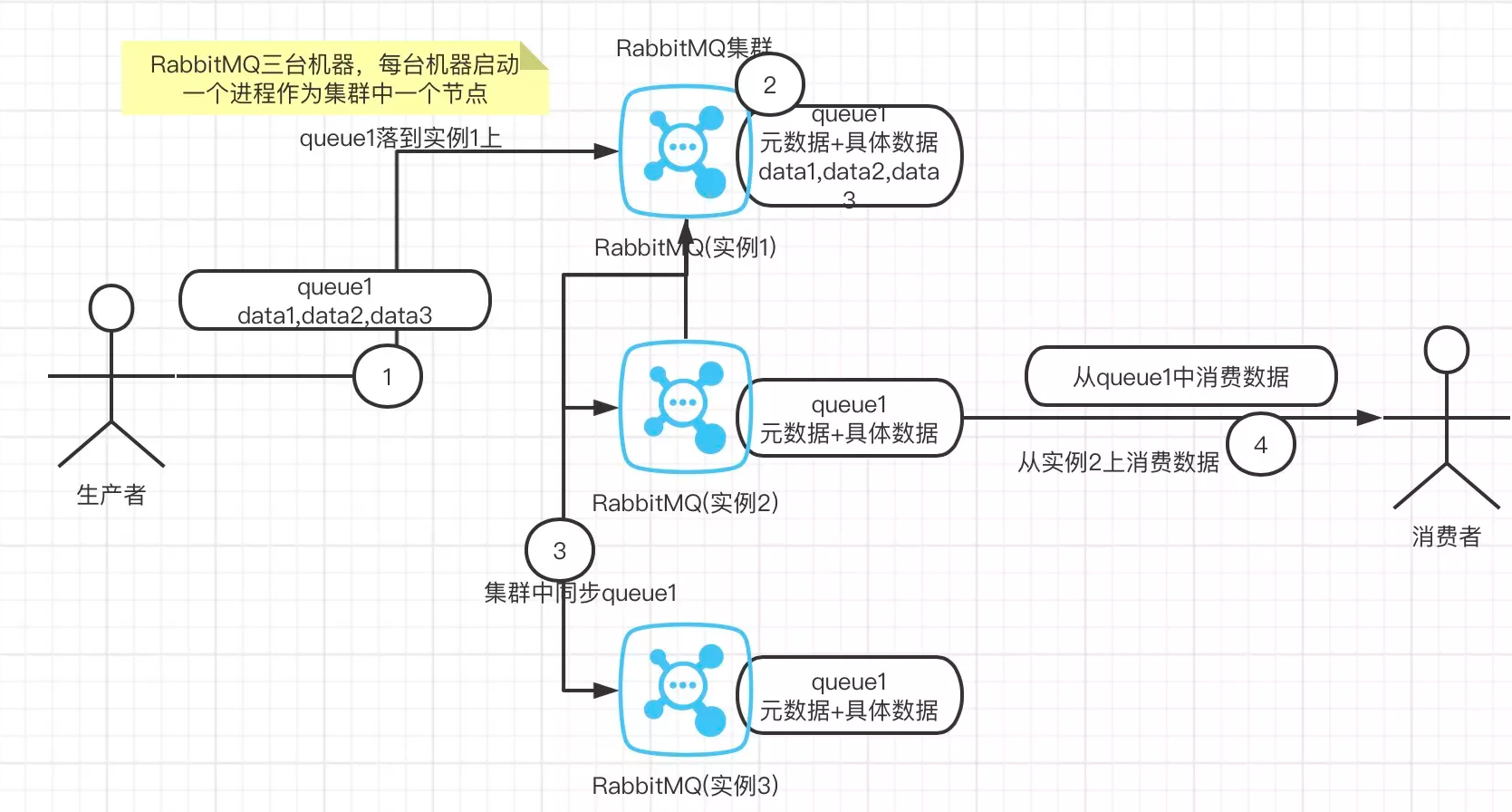

](images/screenshot_1615898622499.png)

如上圖是普通集群模式

1、RabbitMQ在多臺服務器啟動實例、每臺服務器一個實例、當你創建queue時、queue(元數據+具體數據)只會落在一臺RabbitMQ實例上、但是集群中每個實例都會同步queue的元數據(元數據:真實數據的描述如具體位置等)。

2、當用戶消費時如果連接的是另外一個實例,當前實例會根據同步的元數據找到具體的數據所在的實例從其上把具體數據拉過來消費。

這種方式的缺點很明顯,沒有做到所謂的分布式、只是一個普通的集群。這種方式在消費數據時要么隨機選擇一個實例拉去數據、要么固定連接那個queue所在的實例來拉取數據,前者導致一次實例見拉取數據的開銷、而后在會導致單實例性能的瓶頸。

而且如果存放數據的queue的實例宕機了、會導致其它實例無法從該實例來拉取數據了,如果你開啟了RabbitMQ的持久化功能,消息不一定會丟失,但是得等待這個實例重啟后才能繼續從該queue拉取數據。

所以總的來說這事就比較尷尬了,就完全沒有所謂的高可用一說了,這個方案主要的目的是提高吞吐量的,就是說讓集群中的多個節點來服務某個queue的讀寫操作。

## 1.3鏡像集群模式

這種集群模式真正達到了RabbitMQ高可用性,和普通集群不一樣的是你創建的queue不管是元數據還是里面的具體消息都會存在于所有的實例上。每次寫消息時都會把消息同步到每個節點的queue中去。

這種方式的優點在于,你任何一個節點宕機了、都沒事兒,別的節點都還可以正常使用。

缺點:

1、性能開銷太大,消息同步到所有的節點服務器會導致網絡帶寬壓力和消耗很嚴重。

2、這種模式沒有擴展性可言,如果你某個queue的負載很高,你加機器,新增的機器也包含了這個queue的所有數據,并沒有辦法線性擴展你的queue.

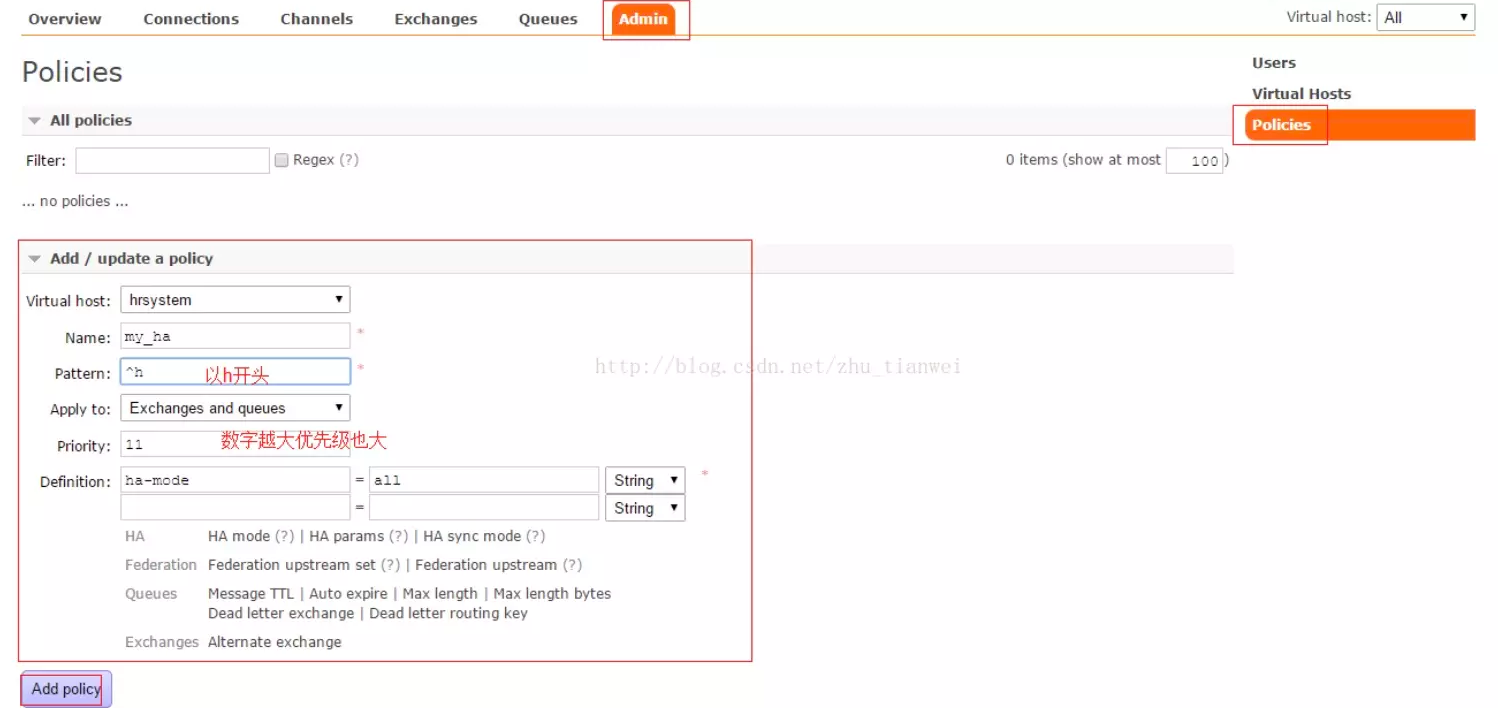

這里在多說下如何開啟鏡像集群模式?其實開啟很簡單在RabbitMQ的管理控制臺,新增一條策略、這個策略就是開啟開啟鏡像集群模式策略、指定的時候可以指定數據同步到所有的節點,也可以要求同步到指定的節點數量,之后你在創建queue時使用這個策略、就會在動降數據同步到其它節點上去了。

# Zookeeper怎么支持高可用

**高可用**:Zookeeper 系統中只要集群中存在超過一半的節點(這里指的是投票節點即非 Observer 節點)能夠正常工作,那么整個集群就能夠正常對外服務

# Redis怎么保證高可用

## 1.如何保證Redis高可用和高并發?

Redis主從架構,一主多從,可以滿足高可用和高并發。出現實例宕機自動進行主備切換,配置讀寫分離緩解Master讀寫壓力。

## 2.Redis高可用方案具體怎么實施?

使用官方推薦的哨兵(sentinel)機制就能實現,當主節點出現故障時,由Sentinel自動完成故障發現和轉移,并通知應用方,實現高可用性。它有四個主要功能:

* 集群監控,負責監控redis master和slave進程是否正常工作。

* 消息通知,如果某個redis實例有故障,那么哨兵負責發送消息作為報警通知給管理員。

* 故障轉移,如果master node掛掉了,會自動轉移到slave node上。

* 配置中心,如果故障轉移發生了,通知client客戶端新的master地址。

## 3.你能說說Redis哨兵機制的原理嗎?

通過sentinel模式啟動redis后,自動監控master/slave的運行狀態,基本原理是:心跳機制+投票裁決。每個sentinel會向其它sentinal、master、slave定時發送消息,以確認對方是否活著,如果發現對方在指定時間內未回應,則暫時認為對方宕機。若哨兵群中的多數sentinel都報告某一master沒響應,系統才認為該master真正宕機,通過Raft投票算法,從剩下的slave節點中,選一臺提升為master,然后自動修改相關配置。

# Kafka怎么保證高可用

Kafka不是完全同步,也不是完全異步,是一種特殊的ISR(In Sync Replica)。

ISR(in-sync replica) 就是 Kafka 為某個分區維護的一組同步集合,即每個分區都有自己的一個 ISR 集合,處于 ISR 集合中的副本,意味著 follower 副本與 leader 副本保持同步狀態,只有處于 ISR 集合中的副本才有資格被選舉為 leader。

## Kafka的Replica

1. kafka的topic可以設置有n個副本(replica),副本數最好要小于等于broker的數量,也就是要保證一個broker上的replica最多有一個。

2. 創建副本的單位是topic的分區,每個分區有1個leader和0到n-1follower,Kafka把多個replica分為Lerder replica和follower replica。

3. 當producer在向topic partition中寫數據時,根據ack機制,默認ack=1,只會向leader中寫入數據,然后leader中的數據會復制到其他的replica中,follower會周期性的從leader中pull數據,但是對于數據的讀寫操作都在leader replica中,follower副本只是當leader副本掛了后才重新選取leader,follower并不向外提供服務。

## Kafka ISR機制

**ISR副本:** 就是能跟首領副本基本保持一致的跟隨副本,如果同步的速度太慢的話,就會被踢出ISR副本。

**副本同步:**

* LEO(last end offset):日志末端位移,記錄了該副本對象底層日志文件中下一條消息的位移值,副本寫入消息的時候,會自動更新 LEO 值。如果LE0 為2的時候,當前的offset為1。

* HW(high watermark):高水印值,HW 一定不會大于 LEO 值,小于 HW 值的消息被認為是“已提交”或“已備份”的消息,并對消費者可見。

* producer向leader發送消息,之后寫入到leader,leader在本地生成log,之后follow從leader拉取消息,follow寫入到本地的log中,會給leader返回一個ack信號,一旦收到了ISR中的所有的ack信號,就會增加HW,然后leader返回給producer一個ack。

## Kafka的復制機制

kafka 每個分區都是由順序追加的不可變的消息序列組成,每條消息都一個唯一的offset 來標記位置。

kafka中的副本機制是以分區粒度進行復制的,在kafka中創建 topic的時候,都可以設置一個復制因子(replica count),這個復制因子決定著分區副本的個數,如果leader 掛掉了,kafka 會把分區主節點failover到其他副本節點,這樣就能保證這個分區的消息是可用的。leader節點負責接收producer 發過來的消息,其他副本節點(follower)從主節點上拷貝消息。

\[站外圖片上傳中...(image-31f1f9-1614765714779)\]

kakfa 日志復制算法提供的保證是當一條消息在producer端認為已經committed的之后,如果leader 節點掛掉了,其他節點被選舉成為了 leader 節點后,這條消息同樣是可以被消費到的。

**關鍵配置:** [unclean.leader.election.enable](https://kafka.apache.org/documentation/#brokerconfigs_unclean.leader.election.enable)

~~~

Indicates whether to enable replicas not in the ISR set to be elected as leader as a last resort,

even though doing so may result in data loss

Type: boolean

Default: false

Valid Values:

Importance: high

Update Mode: cluster-wide

~~~

默認為 `false`, 即允許不在isr中replica選為leader,這個配置可以全局配置,也可以在topic級別配置。

這樣的話,leader選舉的時候,只能從ISR集合中選舉,集合中的每個點都必須是和leader消息同步的,也就是沒有延遲,分區的leader 維護ISR 集合列表,如果某個點落后太多,就從 ISR集合中踢出去。

producer 發送一條消息到leader節點后, 只有當ISR中所有Replica都向leader發送ACK確認這條消息時,leader才commit,這時候producer才能認為這條消息commit了,正是因為如此,kafka客戶端的寫性能取決于ISR集合中的最慢的一個broker的接收消息的性能,如果一個點性能太差,就必須盡快的識別出來,然后從ISR集合中踢出去,以免造成性能問題。

**如何判斷副本不會被移除ISR集合?**

`replica.lag.max.messages` : follower副本最大落后leader副本的消息數。(0.9.0.0版本后移除)。

`replica.lag.time.max.ms`: 不僅指自從上次從副本獲取請求以來經過的時間,而且還指自上次捕獲副本以來的時間。

設置`replica.lag.max.messages`為3,只要 follower 只要不落后leader 大于2條消息,就然后是跟得上leader的節點,就不會被踢出去。

設置 replica.lag.time.max.ms 為 300ms, 意味著只要 follower 在每 300ms內發送fetch請求,就不會被認為已經dead ,不會從ISR集合中踢出去。

## 結語

Replica的目的就是在發生意外時及時頂上,leader失效后,就需要從follower中馬上選一個新的leader 。選舉時優先從ISR中選定,因為這個列表中follower的數據是與leader同步的,從他們中間選取可以保證數據完整 。

但如果不幸ISR列表中的follower都不行了,就只能從其他follower中選取,這時就有數據丟失的可能了,因為不確定這個follower是否已經把leader的數據都復制完成了。

還有一種極端情況,就是所有副本都失效了,這時有兩種方案:

* 等待ISR中的一個活過來,選為Leader,數據可靠,但活過來的時間不確定 。

* 選擇第一個活過來的Replication,不一定是ISR中的,選為leader,以最快速度恢復可用性,但數據不一定完整。

Kafka支持通過配置選擇使用哪一種方案,可以根據可用性和一致性進行權衡。

# Zookeeper的CAP

CAP理論告訴我們,一個分布式系統不可能同時滿足以下三種

一致性(C:Consistency)

可用性(A:Available)

分區容錯性(P:Partition Tolerance)

這三個基本需求,最多只能同時滿足其中的兩項,因為P是必須的,因此往往選擇就在CP或者AP中。

**在此ZooKeeper保證的是CP**

分析:可用性(A:Available)

**不能保證每次服務請求的可用性**。任何時刻對ZooKeeper的訪問請求能得到一致的數據結果,同時系統對網絡分割具備容錯性;但是它不能保證每次服務請求的可用性(注:也就是在極端環境下,ZooKeeper可能會丟棄一些請求,消費者程序需要重新請求才能獲得結果)。所以說,ZooKeeper不能保證服務可用性。

**進行leader選舉時集群都是不可用**。在使用ZooKeeper獲取服務列表時,當master節點因為網絡故障與其他節點失去聯系時,剩余節點會重新進行leader選舉。問題在于,選舉leader的時間太長,30 ~ 120s, 且選舉期間整個zk集群都是不可用的,這就導致在選舉期間注冊服務癱瘓,雖然服務能夠最終恢復,但是漫長的選舉時間導致的注冊長期不可用是不能容忍的。所以說,ZooKeeper不能保證服務可用性。

————————————————

- 一.JVM

- 1.1 java代碼是怎么運行的

- 1.2 JVM的內存區域

- 1.3 JVM運行時內存

- 1.4 JVM內存分配策略

- 1.5 JVM類加載機制與對象的生命周期

- 1.6 常用的垃圾回收算法

- 1.7 JVM垃圾收集器

- 1.8 CMS垃圾收集器

- 1.9 G1垃圾收集器

- 2.面試相關文章

- 2.1 可能是把Java內存區域講得最清楚的一篇文章

- 2.0 GC調優參數

- 2.1GC排查系列

- 2.2 內存泄漏和內存溢出

- 2.2.3 深入理解JVM-hotspot虛擬機對象探秘

- 1.10 并發的可達性分析相關問題

- 二.Java集合架構

- 1.ArrayList深入源碼分析

- 2.Vector深入源碼分析

- 3.LinkedList深入源碼分析

- 4.HashMap深入源碼分析

- 5.ConcurrentHashMap深入源碼分析

- 6.HashSet,LinkedHashSet 和 LinkedHashMap

- 7.容器中的設計模式

- 8.集合架構之面試指南

- 9.TreeSet和TreeMap

- 三.Java基礎

- 1.基礎概念

- 1.1 Java程序初始化的順序是怎么樣的

- 1.2 Java和C++的區別

- 1.3 反射

- 1.4 注解

- 1.5 泛型

- 1.6 字節與字符的區別以及訪問修飾符

- 1.7 深拷貝與淺拷貝

- 1.8 字符串常量池

- 2.面向對象

- 3.關鍵字

- 4.基本數據類型與運算

- 5.字符串與數組

- 6.異常處理

- 7.Object 通用方法

- 8.Java8

- 8.1 Java 8 Tutorial

- 8.2 Java 8 數據流(Stream)

- 8.3 Java 8 并發教程:線程和執行器

- 8.4 Java 8 并發教程:同步和鎖

- 8.5 Java 8 并發教程:原子變量和 ConcurrentMap

- 8.6 Java 8 API 示例:字符串、數值、算術和文件

- 8.7 在 Java 8 中避免 Null 檢查

- 8.8 使用 Intellij IDEA 解決 Java 8 的數據流問題

- 四.Java 并發編程

- 1.線程的實現/創建

- 2.線程生命周期/狀態轉換

- 3.線程池

- 4.線程中的協作、中斷

- 5.Java鎖

- 5.1 樂觀鎖、悲觀鎖和自旋鎖

- 5.2 Synchronized

- 5.3 ReentrantLock

- 5.4 公平鎖和非公平鎖

- 5.3.1 說說ReentrantLock的實現原理,以及ReentrantLock的核心源碼是如何實現的?

- 5.5 鎖優化和升級

- 6.多線程的上下文切換

- 7.死鎖的產生和解決

- 8.J.U.C(java.util.concurrent)

- 0.簡化版(快速復習用)

- 9.鎖優化

- 10.Java 內存模型(JMM)

- 11.ThreadLocal詳解

- 12 CAS

- 13.AQS

- 0.ArrayBlockingQueue和LinkedBlockingQueue的實現原理

- 1.DelayQueue的實現原理

- 14.Thread.join()實現原理

- 15.PriorityQueue 的特性和原理

- 16.CyclicBarrier的實際使用場景

- 五.Java I/O NIO

- 1.I/O模型簡述

- 2.Java NIO之緩沖區

- 3.JAVA NIO之文件通道

- 4.Java NIO之套接字通道

- 5.Java NIO之選擇器

- 6.基于 Java NIO 實現簡單的 HTTP 服務器

- 7.BIO-NIO-AIO

- 8.netty(一)

- 9.NIO面試題

- 六.Java設計模式

- 1.單例模式

- 2.策略模式

- 3.模板方法

- 4.適配器模式

- 5.簡單工廠

- 6.門面模式

- 7.代理模式

- 七.數據結構和算法

- 1.什么是紅黑樹

- 2.二叉樹

- 2.1 二叉樹的前序、中序、后序遍歷

- 3.排序算法匯總

- 4.java實現鏈表及鏈表的重用操作

- 4.1算法題-鏈表反轉

- 5.圖的概述

- 6.常見的幾道字符串算法題

- 7.幾道常見的鏈表算法題

- 8.leetcode常見算法題1

- 9.LRU緩存策略

- 10.二進制及位運算

- 10.1.二進制和十進制轉換

- 10.2.位運算

- 11.常見鏈表算法題

- 12.算法好文推薦

- 13.跳表

- 八.Spring 全家桶

- 1.Spring IOC

- 2.Spring AOP

- 3.Spring 事務管理

- 4.SpringMVC 運行流程和手動實現

- 0.Spring 核心技術

- 5.spring如何解決循環依賴問題

- 6.springboot自動裝配原理

- 7.Spring中的循環依賴解決機制中,為什么要三級緩存,用二級緩存不夠嗎

- 8.beanFactory和factoryBean有什么區別

- 九.數據庫

- 1.mybatis

- 1.1 MyBatis-# 與 $ 區別以及 sql 預編譯

- Mybatis系列1-Configuration

- Mybatis系列2-SQL執行過程

- Mybatis系列3-之SqlSession

- Mybatis系列4-之Executor

- Mybatis系列5-StatementHandler

- Mybatis系列6-MappedStatement

- Mybatis系列7-參數設置揭秘(ParameterHandler)

- Mybatis系列8-緩存機制

- 2.淺談聚簇索引和非聚簇索引的區別

- 3.mysql 證明為什么用limit時,offset很大會影響性能

- 4.MySQL中的索引

- 5.數據庫索引2

- 6.面試題收集

- 7.MySQL行鎖、表鎖、間隙鎖詳解

- 8.數據庫MVCC詳解

- 9.一條SQL查詢語句是如何執行的

- 10.MySQL 的 crash-safe 原理解析

- 11.MySQL 性能優化神器 Explain 使用分析

- 12.mysql中,一條update語句執行的過程是怎么樣的?期間用到了mysql的哪些log,分別有什么作用

- 十.Redis

- 0.快速復習回顧Redis

- 1.通俗易懂的Redis數據結構基礎教程

- 2.分布式鎖(一)

- 3.分布式鎖(二)

- 4.延時隊列

- 5.位圖Bitmaps

- 6.Bitmaps(位圖)的使用

- 7.Scan

- 8.redis緩存雪崩、緩存擊穿、緩存穿透

- 9.Redis為什么是單線程、及高并發快的3大原因詳解

- 10.布隆過濾器你值得擁有的開發利器

- 11.Redis哨兵、復制、集群的設計原理與區別

- 12.redis的IO多路復用

- 13.相關redis面試題

- 14.redis集群

- 十一.中間件

- 1.RabbitMQ

- 1.1 RabbitMQ實戰,hello world

- 1.2 RabbitMQ 實戰,工作隊列

- 1.3 RabbitMQ 實戰, 發布訂閱

- 1.4 RabbitMQ 實戰,路由

- 1.5 RabbitMQ 實戰,主題

- 1.6 Spring AMQP 的 AMQP 抽象

- 1.7 Spring AMQP 實戰 – 整合 RabbitMQ 發送郵件

- 1.8 RabbitMQ 的消息持久化與 Spring AMQP 的實現剖析

- 1.9 RabbitMQ必備核心知識

- 2.RocketMQ 的幾個簡單問題與答案

- 2.Kafka

- 2.1 kafka 基礎概念和術語

- 2.2 Kafka的重平衡(Rebalance)

- 2.3.kafka日志機制

- 2.4 kafka是pull還是push的方式傳遞消息的?

- 2.5 Kafka的數據處理流程

- 2.6 Kafka的腦裂預防和處理機制

- 2.7 Kafka中partition副本的Leader選舉機制

- 2.8 如果Leader掛了的時候,follower沒來得及同步,是否會出現數據不一致

- 2.9 kafka的partition副本是否會出現腦裂情況

- 十二.Zookeeper

- 0.什么是Zookeeper(漫畫)

- 1.使用docker安裝Zookeeper偽集群

- 3.ZooKeeper-Plus

- 4.zk實現分布式鎖

- 5.ZooKeeper之Watcher機制

- 6.Zookeeper之選舉及數據一致性

- 十三.計算機網絡

- 1.進制轉換:二進制、八進制、十六進制、十進制之間的轉換

- 2.位運算

- 3.計算機網絡面試題匯總1

- 十四.Docker

- 100.面試題收集合集

- 1.美團面試常見問題總結

- 2.b站部分面試題

- 3.比心面試題

- 4.騰訊面試題

- 5.哈羅部分面試

- 6.筆記

- 十五.Storm

- 1.Storm和流處理簡介

- 2.Storm 核心概念詳解

- 3.Storm 單機版本環境搭建

- 4.Storm 集群環境搭建

- 5.Storm 編程模型詳解

- 6.Storm 項目三種打包方式對比分析

- 7.Storm 集成 Redis 詳解

- 8.Storm 集成 HDFS 和 HBase

- 9.Storm 集成 Kafka

- 十六.Elasticsearch

- 1.初識ElasticSearch

- 2.文檔基本CRUD、集群健康檢查

- 3.shard&replica

- 4.document核心元數據解析及ES的并發控制

- 5.document的批量操作及數據路由原理

- 6.倒排索引

- 十七.分布式相關

- 1.分布式事務解決方案一網打盡

- 2.關于xxx怎么保證高可用的問題

- 3.一致性hash原理與實現

- 4.微服務注冊中心 Nacos 比 Eureka的優勢

- 5.Raft 協議算法

- 6.為什么微服務架構中需要網關

- 0.CAP與BASE理論

- 十八.Dubbo

- 1.快速掌握Dubbo常規應用

- 2.Dubbo應用進階

- 3.Dubbo調用模塊詳解

- 4.Dubbo調用模塊源碼分析

- 6.Dubbo協議模塊