# 理解卷積

**卷積**是 CNN 架構背后的核心概念。簡單來說,卷積是一種數學運算,它結合了兩個來源的信息來產生一組新的信息。具體來說,它將一個稱為內核的特殊矩陣應用于輸入張量,以產生一組稱為特征圖的矩陣。可以使用任何流行的算法將內核應用于輸入張量。

生成卷積矩陣的最常用算法如下:

```py

N_STRIDES = [1,1]

1\. Overlap the kernel with the top-left cells of the image matrix.

2\. Repeat while the kernel overlaps the image matrix:

2.1 c_col = 0

2.2 Repeat while the kernel overlaps the image matrix:

2.1.1 set c_row = 0 2.1.2 convolved_scalar = scalar_prod(kernel, overlapped cells)

2.1.3 convolved_matrix(c_row,c_col) = convolved_scalar

2.1.4 Slide the kernel down by N_STRIDES[0] rows.

2.1.5 c_row = c_row + 1

2.3 Slide the kernel to (topmost row, N_STRIDES[1] columns right)

2.4 c_col = c_col + 1

```

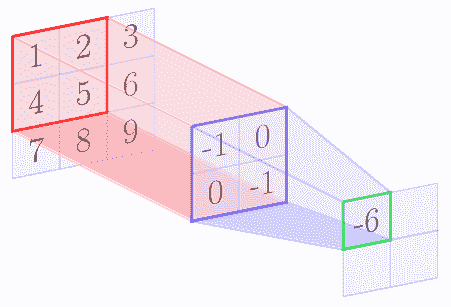

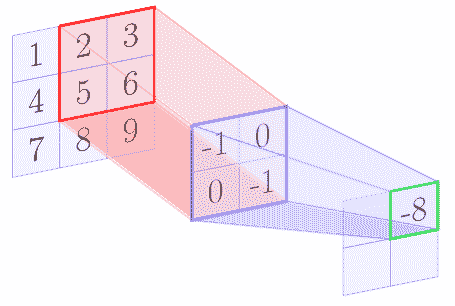

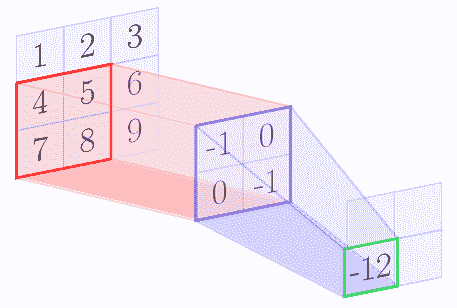

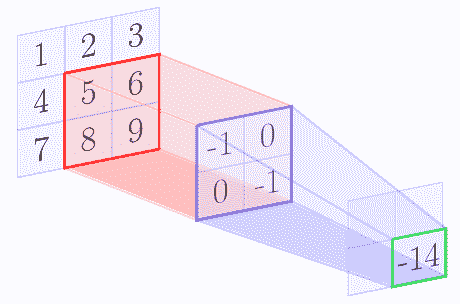

例如,我們假設核矩陣是 2 x 2 矩陣,輸入圖像是 3 x 3 矩陣。下圖逐步顯示了上述算法:

| | |

| --- | --- |

|  |  |

|  |  |

在 con 卷積操作結束時,我們得到以下特征圖:

| | |

| --- | --- |

| -6 | -8 |

| -12 | -14 |

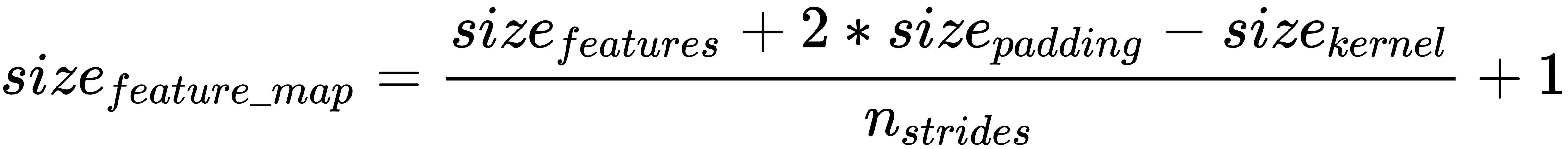

在上面的示例中,與卷積的原始輸入相比,生成的特征映射的大小更小。通常,特征圖的大小減小(內核大小-1)。因此,特征圖的大小為:

**三維張量**

對于具有額外深度尺寸的三維張量,您可以將前面的算法視為應用于深度維度中的每個層。將卷積應用于 3D 張量的輸出也是 2D 張量,因為卷積運算添加了三個通道。

**大步**

數組 N_STRIDES 中的 **步長** 是您想要將內核滑過的行或列的數字。在我們的例子中,我們使用了 1 的步幅。如果我們使用更多的步幅,那么特征圖的大小將根據以下等式進一步減小:

**填充**

如果我們不希望減小特征映射的大小,那么我們可以在輸入的所有邊上使用填充,使得特征的大小增加填充大小的兩倍。使用填充,可以按如下方式計算特征圖的大小:

TensorFlow 允許兩種填充:SAME 或 VALID。 SAME 填充意味著添加填充,使輸出特征圖與輸入特征具有相同的大小。 VALID 填充意味著沒有填充。

應用前面提到的卷積算法的結果是特征圖,是原始張量的濾波版本。例如,特征圖可能只有從原始圖像中過濾出的輪廓。因此,內核也稱為過濾器。對于每個內核,您將獲得單獨的 2D 特征圖。

根據您希望網絡學習的特征,您必須應用適當的過濾器來強調所需的特征。 但是,使用 CNN,模型可以自動了解哪些內核在卷積層中最有效。

**TensorFlow** 中的卷積運算

TensorFlow 提供實現卷積算法的卷積層。例如,具有以下簽名的`tf.nn.conv2d()`操作:

```py

tf.nn.conv2d(

input,

filter,

strides,

padding,

use_cudnn_on_gpu=None,

data_format=None,

name=None

)

```

`input`和`filter`表示形狀`[batch_size, input_height, input_width, input_depth]`的數據張量和形狀`[filter_height, filter_width, input_depth, output_depth]`的核張量。內核張量中的 `output_depth`表示應該應用于輸入的內核數量。 `strides`張量表示每個維度中要滑動的單元數。如上所述,`padding`是有效的或相同的。

您可以在以下鏈接中找到有關TensorFlow中可用卷積操作的更多信息:[https://www.tensorflow.org/api_guides/python/nn#Convolution](https://www.tensorflow.org/api_guides/python/nn#Convolution)

您可以在以下鏈接中找到有關 Keras 中可用卷積層的更多信息:[https://keras.io/layers/convolutional/](https://keras.io/layers/convolutional/)

以下鏈接提供了卷積的詳細數學解釋:[http://colah.github.io/posts/2014-07-Understanding-Convolutions/](http://colah.github.io/posts/2014-07-Understanding-Convolutions/)

[http://ufldl.stanford.edu/tutorial/supervised/FeatureExtractionUsingConvolution/](http://ufldl.stanford.edu/tutorial/supervised/FeatureExtractionUsingConvolution/)

[http://colah.github.io/posts/2014-07-Understanding-Convolutions/](http://colah.github.io/posts/2014-07-Understanding-Convolutions/)

卷積層或操作將輸入值或神經元連接到下一個隱藏層神經元。每個隱藏層神經元連接到與內核中元素數量相同數量的輸入神經元。所以在前面的例子中,內核有 4 個元素,因此隱藏層神經元連接到輸入層的 4 個神經元(3×3 個神經元中)。在我們的例子中,輸入層的 4 個神經元的這個區域被稱為 CNN 理論中的**感受域**。

卷積層具有每個內核的單獨權重和偏差參數。權重參數的數量等于內核中元素的數量,并且只有一個偏差參數。內核的所有連接共享相同的權重和偏差參數。因此在我們的例子中,將有 4 個權重參數和 1 個偏差參數,但如果我們在卷積層中使用 5 個內核,則總共將有 5 x 4 個權重參數和 5 個 1 個偏差參數,一組(4)每個特征圖的權重,1 個偏差)參數。

- TensorFlow 101

- 什么是 TensorFlow?

- TensorFlow 核心

- 代碼預熱 - Hello TensorFlow

- 張量

- 常量

- 操作

- 占位符

- 從 Python 對象創建張量

- 變量

- 從庫函數生成的張量

- 使用相同的值填充張量元素

- 用序列填充張量元素

- 使用隨機分布填充張量元素

- 使用tf.get_variable()獲取變量

- 數據流圖或計算圖

- 執行順序和延遲加載

- 跨計算設備執行圖 - CPU 和 GPU

- 將圖節點放置在特定的計算設備上

- 簡單放置

- 動態展示位置

- 軟放置

- GPU 內存處理

- 多個圖

- TensorBoard

- TensorBoard 最小的例子

- TensorBoard 詳情

- 總結

- TensorFlow 的高級庫

- TF Estimator - 以前的 TF 學習

- TF Slim

- TFLearn

- 創建 TFLearn 層

- TFLearn 核心層

- TFLearn 卷積層

- TFLearn 循環層

- TFLearn 正則化層

- TFLearn 嵌入層

- TFLearn 合并層

- TFLearn 估計層

- 創建 TFLearn 模型

- TFLearn 模型的類型

- 訓練 TFLearn 模型

- 使用 TFLearn 模型

- PrettyTensor

- Sonnet

- 總結

- Keras 101

- 安裝 Keras

- Keras 中的神經網絡模型

- 在 Keras 建立模型的工作流程

- 創建 Keras 模型

- 用于創建 Keras 模型的順序 API

- 用于創建 Keras 模型的函數式 API

- Keras 層

- Keras 核心層

- Keras 卷積層

- Keras 池化層

- Keras 本地連接層

- Keras 循環層

- Keras 嵌入層

- Keras 合并層

- Keras 高級激活層

- Keras 正則化層

- Keras 噪音層

- 將層添加到 Keras 模型

- 用于將層添加到 Keras 模型的順序 API

- 用于向 Keras 模型添加層的函數式 API

- 編譯 Keras 模型

- 訓練 Keras 模型

- 使用 Keras 模型進行預測

- Keras 的附加模塊

- MNIST 數據集的 Keras 序列模型示例

- 總結

- 使用 TensorFlow 進行經典機器學習

- 簡單的線性回歸

- 數據準備

- 構建一個簡單的回歸模型

- 定義輸入,參數和其他變量

- 定義模型

- 定義損失函數

- 定義優化器函數

- 訓練模型

- 使用訓練的模型進行預測

- 多元回歸

- 正則化回歸

- 套索正則化

- 嶺正則化

- ElasticNet 正則化

- 使用邏輯回歸進行分類

- 二分類的邏輯回歸

- 多類分類的邏輯回歸

- 二分類

- 多類分類

- 總結

- 使用 TensorFlow 和 Keras 的神經網絡和 MLP

- 感知機

- 多層感知機

- 用于圖像分類的 MLP

- 用于 MNIST 分類的基于 TensorFlow 的 MLP

- 用于 MNIST 分類的基于 Keras 的 MLP

- 用于 MNIST 分類的基于 TFLearn 的 MLP

- 使用 TensorFlow,Keras 和 TFLearn 的 MLP 總結

- 用于時間序列回歸的 MLP

- 總結

- 使用 TensorFlow 和 Keras 的 RNN

- 簡單循環神經網絡

- RNN 變種

- LSTM 網絡

- GRU 網絡

- TensorFlow RNN

- TensorFlow RNN 單元類

- TensorFlow RNN 模型構建類

- TensorFlow RNN 單元包裝器類

- 適用于 RNN 的 Keras

- RNN 的應用領域

- 用于 MNIST 數據的 Keras 中的 RNN

- 總結

- 使用 TensorFlow 和 Keras 的時間序列數據的 RNN

- 航空公司乘客數據集

- 加載 airpass 數據集

- 可視化 airpass 數據集

- 使用 TensorFlow RNN 模型預處理數據集

- TensorFlow 中的簡單 RNN

- TensorFlow 中的 LSTM

- TensorFlow 中的 GRU

- 使用 Keras RNN 模型預處理數據集

- 使用 Keras 的簡單 RNN

- 使用 Keras 的 LSTM

- 使用 Keras 的 GRU

- 總結

- 使用 TensorFlow 和 Keras 的文本數據的 RNN

- 詞向量表示

- 為 word2vec 模型準備數據

- 加載和準備 PTB 數據集

- 加載和準備 text8 數據集

- 準備小驗證集

- 使用 TensorFlow 的 skip-gram 模型

- 使用 t-SNE 可視化單詞嵌入

- keras 的 skip-gram 模型

- 使用 TensorFlow 和 Keras 中的 RNN 模型生成文本

- TensorFlow 中的 LSTM 文本生成

- Keras 中的 LSTM 文本生成

- 總結

- 使用 TensorFlow 和 Keras 的 CNN

- 理解卷積

- 了解池化

- CNN 架構模式 - LeNet

- 用于 MNIST 數據的 LeNet

- 使用 TensorFlow 的用于 MNIST 的 LeNet CNN

- 使用 Keras 的用于 MNIST 的 LeNet CNN

- 用于 CIFAR10 數據的 LeNet

- 使用 TensorFlow 的用于 CIFAR10 的 ConvNets

- 使用 Keras 的用于 CIFAR10 的 ConvNets

- 總結

- 使用 TensorFlow 和 Keras 的自編碼器

- 自編碼器類型

- TensorFlow 中的棧式自編碼器

- Keras 中的棧式自編碼器

- TensorFlow 中的去噪自編碼器

- Keras 中的去噪自編碼器

- TensorFlow 中的變分自編碼器

- Keras 中的變分自編碼器

- 總結

- TF 服務:生產中的 TensorFlow 模型

- 在 TensorFlow 中保存和恢復模型

- 使用保護程序類保存和恢復所有圖變量

- 使用保護程序類保存和恢復所選變量

- 保存和恢復 Keras 模型

- TensorFlow 服務

- 安裝 TF 服務

- 保存 TF 服務的模型

- 提供 TF 服務模型

- 在 Docker 容器中提供 TF 服務

- 安裝 Docker

- 為 TF 服務構建 Docker 鏡像

- 在 Docker 容器中提供模型

- Kubernetes 中的 TensorFlow 服務

- 安裝 Kubernetes

- 將 Docker 鏡像上傳到 dockerhub

- 在 Kubernetes 部署

- 總結

- 遷移學習和預訓練模型

- ImageNet 數據集

- 再訓練或微調模型

- COCO 動物數據集和預處理圖像

- TensorFlow 中的 VGG16

- 使用 TensorFlow 中預訓練的 VGG16 進行圖像分類

- TensorFlow 中的圖像預處理,用于預訓練的 VGG16

- 使用 TensorFlow 中的再訓練的 VGG16 進行圖像分類

- Keras 的 VGG16

- 使用 Keras 中預訓練的 VGG16 進行圖像分類

- 使用 Keras 中再訓練的 VGG16 進行圖像分類

- TensorFlow 中的 Inception v3

- 使用 TensorFlow 中的 Inception v3 進行圖像分類

- 使用 TensorFlow 中的再訓練的 Inception v3 進行圖像分類

- 總結

- 深度強化學習

- OpenAI Gym 101

- 將簡單的策略應用于 cartpole 游戲

- 強化學習 101

- Q 函數(在模型不可用時學習優化)

- RL 算法的探索與開發

- V 函數(模型可用時學習優化)

- 強化學習技巧

- 強化學習的樸素神經網絡策略

- 實現 Q-Learning

- Q-Learning 的初始化和離散化

- 使用 Q-Table 進行 Q-Learning

- Q-Network 或深 Q 網絡(DQN)的 Q-Learning

- 總結

- 生成性對抗網絡

- 生成性對抗網絡 101

- 建立和訓練 GAN 的最佳實踐

- 使用 TensorFlow 的簡單的 GAN

- 使用 Keras 的簡單的 GAN

- 使用 TensorFlow 和 Keras 的深度卷積 GAN

- 總結

- 使用 TensorFlow 集群的分布式模型

- 分布式執行策略

- TensorFlow 集群

- 定義集群規范

- 創建服務器實例

- 定義服務器和設備之間的參數和操作

- 定義并訓練圖以進行異步更新

- 定義并訓練圖以進行同步更新

- 總結

- 移動和嵌入式平臺上的 TensorFlow 模型

- 移動平臺上的 TensorFlow

- Android 應用中的 TF Mobile

- Android 上的 TF Mobile 演示

- iOS 應用中的 TF Mobile

- iOS 上的 TF Mobile 演示

- TensorFlow Lite

- Android 上的 TF Lite 演示

- iOS 上的 TF Lite 演示

- 總結

- R 中的 TensorFlow 和 Keras

- 在 R 中安裝 TensorFlow 和 Keras 軟件包

- R 中的 TF 核心 API

- R 中的 TF 估計器 API

- R 中的 Keras API

- R 中的 TensorBoard

- R 中的 tfruns 包

- 總結

- 調試 TensorFlow 模型

- 使用tf.Session.run()獲取張量值

- 使用tf.Print()打印張量值

- 用tf.Assert()斷言條件

- 使用 TensorFlow 調試器(tfdbg)進行調試

- 總結

- 張量處理單元