## 14.3 變量之間的相互作用

在前面的模型中,我們假設兩組的學習時間對成績的影響(即回歸斜率)是相同的。但是,在某些情況下,我們可以想象一個變量的效果可能會因另一個變量的值而不同,我們稱之為變量之間的 _ 交互 _。

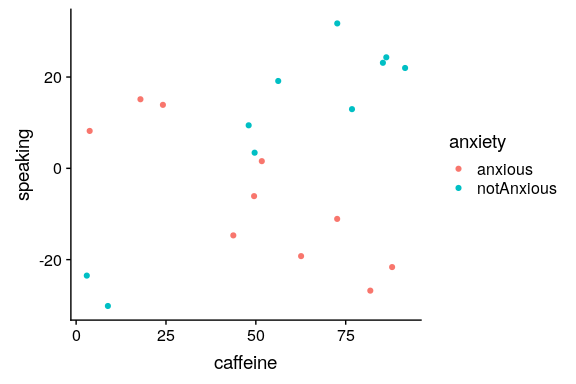

圖 14.6 咖啡因與公共演講的關系

讓我們用一個新的例子來問這個問題:咖啡因對公眾演講的影響是什么?首先,讓我們生成一些數據并繪制它們。從圖[14.6](#fig:CaffeineSpeaking)來看,似乎沒有關系,我們可以通過對數據進行線性回歸來確認:

```r

# perform linear regression with caffeine as independent variable

lmResultCaffeine <- lm(speaking ~ caffeine, data = df)

summary(lmResultCaffeine)

```

```r

##

## Call:

## lm(formula = speaking ~ caffeine, data = df)

##

## Residuals:

## Min 1Q Median 3Q Max

## -33.10 -16.02 5.01 16.45 26.98

##

## Coefficients:

## Estimate Std. Error t value Pr(>|t|)

## (Intercept) -7.413 9.165 -0.81 0.43

## caffeine 0.168 0.151 1.11 0.28

##

## Residual standard error: 19 on 18 degrees of freedom

## Multiple R-squared: 0.0642, Adjusted R-squared: 0.0122

## F-statistic: 1.23 on 1 and 18 DF, p-value: 0.281

```

但現在讓我們假設,我們發現研究表明焦慮和非焦慮的人對咖啡因的反應不同。首先,讓我們分別為焦慮和非焦慮的人繪制數據。

圖 14.7 咖啡因與公共演講的關系,數據點顏色代表焦慮

從圖[14.7](#fig:CaffeineSpeakingAnxiety)可以看出,兩組人的言語和咖啡因之間的關系是不同的,咖啡因改善了無焦慮人群的表現,降低了焦慮人群的表現。我們想創建一個解決這個問題的統計模型。首先,讓我們看看如果在模型中包含焦慮會發生什么。

```r

# compute linear regression adding anxiety to model

lmResultCafAnx <- lm(speaking ~ caffeine + anxiety, data = df)

summary(lmResultCafAnx)

```

```r

##

## Call:

## lm(formula = speaking ~ caffeine + anxiety, data = df)

##

## Residuals:

## Min 1Q Median 3Q Max

## -32.97 -9.74 1.35 10.53 25.36

##

## Coefficients:

## Estimate Std. Error t value Pr(>|t|)

## (Intercept) -12.581 9.197 -1.37 0.19

## caffeine 0.131 0.145 0.91 0.38

## anxietynotAnxious 14.233 8.232 1.73 0.10

##

## Residual standard error: 18 on 17 degrees of freedom

## Multiple R-squared: 0.204, Adjusted R-squared: 0.11

## F-statistic: 2.18 on 2 and 17 DF, p-value: 0.144

```

在這里,我們看到咖啡因和焦慮都沒有明顯的效果,這看起來有點令人困惑。問題是,這一模型試圖符合兩組人對咖啡因說話的同一條線。如果我們想使用單獨的行來擬合它們,我們需要在模型中包含一個 _ 交互 _,這相當于為兩個組中的每個組擬合不同的行;在 r 中,這由符號表示。

```r

# compute linear regression including caffeine X anxiety interaction

lmResultInteraction <- lm(

speaking ~ caffeine + anxiety + caffeine * anxiety,

data = df

)

summary(lmResultInteraction)

```

```r

##

## Call:

## lm(formula = speaking ~ caffeine + anxiety + caffeine * anxiety,

## data = df)

##

## Residuals:

## Min 1Q Median 3Q Max

## -11.385 -7.103 -0.444 6.171 13.458

##

## Coefficients:

## Estimate Std. Error t value Pr(>|t|)

## (Intercept) 17.4308 5.4301 3.21 0.00546 **

## caffeine -0.4742 0.0966 -4.91 0.00016 ***

## anxietynotAnxious -43.4487 7.7914 -5.58 4.2e-05 ***

## caffeine:anxietynotAnxious 1.0839 0.1293 8.38 3.0e-07 ***

## ---

## Signif. codes: 0 '***' 0.001 '**' 0.01 '*' 0.05 '.' 0.1 ' ' 1

##

## Residual standard error: 8.1 on 16 degrees of freedom

## Multiple R-squared: 0.852, Adjusted R-squared: 0.825

## F-statistic: 30.8 on 3 and 16 DF, p-value: 7.01e-07

```

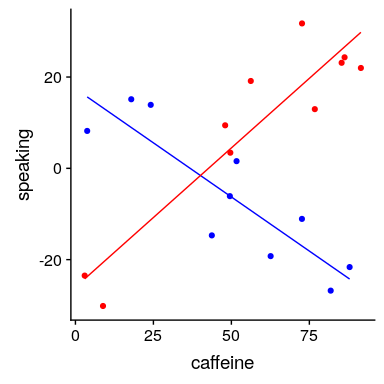

從這些結果中,我們發現咖啡因和焦慮都有顯著的影響(我們稱之為 _ 主要影響 _),以及咖啡因和焦慮之間的相互作用。圖[14.8](#fig:CaffeineAnxietyInteraction)顯示了每組的獨立回歸線。

圖 14.8 公眾演講和咖啡因之間的關系,包括與焦慮的互動。這將生成兩條線,分別為每個組建模坡度。

有時我們想比較兩個不同模型的相對擬合,以確定哪個模型更好;我們將其稱為 _ 模型比較 _。對于上面的模型,我們可以使用 r 中的`anova()`命令比較模型的擬合優度(有無交互作用):

```r

anova(lmResultCafAnx, lmResultInteraction)

```

```r

## Analysis of Variance Table

##

## Model 1: speaking ~ caffeine + anxiety

## Model 2: speaking ~ caffeine + anxiety + caffeine * anxiety

## Res.Df RSS Df Sum of Sq F Pr(>F)

## 1 17 5639

## 2 16 1046 1 4593 70.3 3e-07 ***

## ---

## Signif. codes: 0 '***' 0.001 '**' 0.01 '*' 0.05 '.' 0.1 ' ' 1

```

這告訴我們,有很好的證據表明,比起沒有交互作用的模型,更傾向于有交互作用的模型。在這種情況下,模型比較相對簡單,因為這兩個模型是 _ 嵌套的 _——其中一個模型是另一個模型的簡化版本。與非嵌套模型的模型比較可能會變得更加復雜。

- 前言

- 0.1 本書為什么存在?

- 0.2 你不是統計學家-我們為什么要聽你的?

- 0.3 為什么是 R?

- 0.4 數據的黃金時代

- 0.5 開源書籍

- 0.6 確認

- 1 引言

- 1.1 什么是統計思維?

- 1.2 統計數據能為我們做什么?

- 1.3 統計學的基本概念

- 1.4 因果關系與統計

- 1.5 閱讀建議

- 2 處理數據

- 2.1 什么是數據?

- 2.2 測量尺度

- 2.3 什么是良好的測量?

- 2.4 閱讀建議

- 3 概率

- 3.1 什么是概率?

- 3.2 我們如何確定概率?

- 3.3 概率分布

- 3.4 條件概率

- 3.5 根據數據計算條件概率

- 3.6 獨立性

- 3.7 逆轉條件概率:貝葉斯規則

- 3.8 數據學習

- 3.9 優勢比

- 3.10 概率是什么意思?

- 3.11 閱讀建議

- 4 匯總數據

- 4.1 為什么要總結數據?

- 4.2 使用表格匯總數據

- 4.3 分布的理想化表示

- 4.4 閱讀建議

- 5 將模型擬合到數據

- 5.1 什么是模型?

- 5.2 統計建模:示例

- 5.3 什么使模型“良好”?

- 5.4 模型是否太好?

- 5.5 最簡單的模型:平均值

- 5.6 模式

- 5.7 變異性:平均值與數據的擬合程度如何?

- 5.8 使用模擬了解統計數據

- 5.9 Z 分數

- 6 數據可視化

- 6.1 數據可視化如何拯救生命

- 6.2 繪圖解剖

- 6.3 使用 ggplot 在 R 中繪制

- 6.4 良好可視化原則

- 6.5 最大化數據/墨水比

- 6.6 避免圖表垃圾

- 6.7 避免數據失真

- 6.8 謊言因素

- 6.9 記住人的局限性

- 6.10 其他因素的修正

- 6.11 建議閱讀和視頻

- 7 取樣

- 7.1 我們如何取樣?

- 7.2 采樣誤差

- 7.3 平均值的標準誤差

- 7.4 中心極限定理

- 7.5 置信區間

- 7.6 閱讀建議

- 8 重新采樣和模擬

- 8.1 蒙特卡羅模擬

- 8.2 統計的隨機性

- 8.3 生成隨機數

- 8.4 使用蒙特卡羅模擬

- 8.5 使用模擬統計:引導程序

- 8.6 閱讀建議

- 9 假設檢驗

- 9.1 無效假設統計檢驗(NHST)

- 9.2 無效假設統計檢驗:一個例子

- 9.3 無效假設檢驗過程

- 9.4 現代環境下的 NHST:多重測試

- 9.5 閱讀建議

- 10 置信區間、效應大小和統計功率

- 10.1 置信區間

- 10.2 效果大小

- 10.3 統計能力

- 10.4 閱讀建議

- 11 貝葉斯統計

- 11.1 生成模型

- 11.2 貝葉斯定理與逆推理

- 11.3 進行貝葉斯估計

- 11.4 估計后驗分布

- 11.5 選擇優先權

- 11.6 貝葉斯假設檢驗

- 11.7 閱讀建議

- 12 分類關系建模

- 12.1 示例:糖果顏色

- 12.2 皮爾遜卡方檢驗

- 12.3 應急表及雙向試驗

- 12.4 標準化殘差

- 12.5 優勢比

- 12.6 貝葉斯系數

- 12.7 超出 2 x 2 表的分類分析

- 12.8 注意辛普森悖論

- 13 建模持續關系

- 13.1 一個例子:仇恨犯罪和收入不平等

- 13.2 收入不平等是否與仇恨犯罪有關?

- 13.3 協方差和相關性

- 13.4 相關性和因果關系

- 13.5 閱讀建議

- 14 一般線性模型

- 14.1 線性回歸

- 14.2 安裝更復雜的模型

- 14.3 變量之間的相互作用

- 14.4“預測”的真正含義是什么?

- 14.5 閱讀建議

- 15 比較方法

- 15.1 學生 T 考試

- 15.2 t 檢驗作為線性模型

- 15.3 平均差的貝葉斯因子

- 15.4 配對 t 檢驗

- 15.5 比較兩種以上的方法

- 16 統計建模過程:一個實例

- 16.1 統計建模過程

- 17 做重復性研究

- 17.1 我們認為科學應該如何運作

- 17.2 科學(有時)是如何工作的

- 17.3 科學中的再現性危機

- 17.4 有問題的研究實踐

- 17.5 進行重復性研究

- 17.6 進行重復性數據分析

- 17.7 結論:提高科學水平

- 17.8 閱讀建議

- References