# 一、如何使用 TensorFlow Eager 構建簡單的神經網絡

大家好! 在本教程中,我們將使用 TensorFlow 的命令模式構建一個簡單的前饋神經網絡。 希望你會發現它很有用! 如果你對如何改進代碼有任何建議,請告訴我。

教程步驟:

使用的版本:TensorFlow 1.7

## 第一步:導入有用的庫并啟用 Eager 模式

```py

# 導入 TensorFlow 和 TensorFlow Eager

import tensorflow as tf

import tensorflow.contrib.eager as tfe

# 導入函數來生成玩具分類問題

from sklearn.datasets import make_moons

import numpy as np

# 導入繪圖庫

import matplotlib.pyplot as plt

%matplotlib inline

# 開啟 Eager 模式。一旦開啟不能撤銷!只執行一次。

tfe.enable_eager_execution()

```

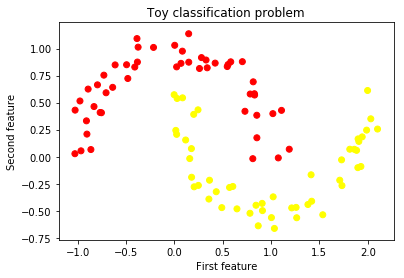

## 第二步:為二分類生成玩具數據集

我們將生成一個玩具數據集,來訓練我們的網絡。 我從`sklearn`中選擇了`make_moons`函數。 我相信它對我們的任務來說是完美的,因為類不是線性可分的,因此神經網絡將非常有用。

```py

# 為分類生成玩具數據集

# X 是 n_samples x n_features 的矩陣,表示輸入特征

# y 是 長度為 n_samples 的向量,表示我們的標簽

X, y = make_moons(n_samples=100, noise=0.1, random_state=2018)

```

## 第三步:展示生成的數據集

```py

plt.scatter(X[:,0], X[:,1], c=y, cmap=plt.cm.autumn)

plt.xlabel('First feature')

plt.ylabel('Second feature')

plt.title('Toy classification problem')

plt.show()

```

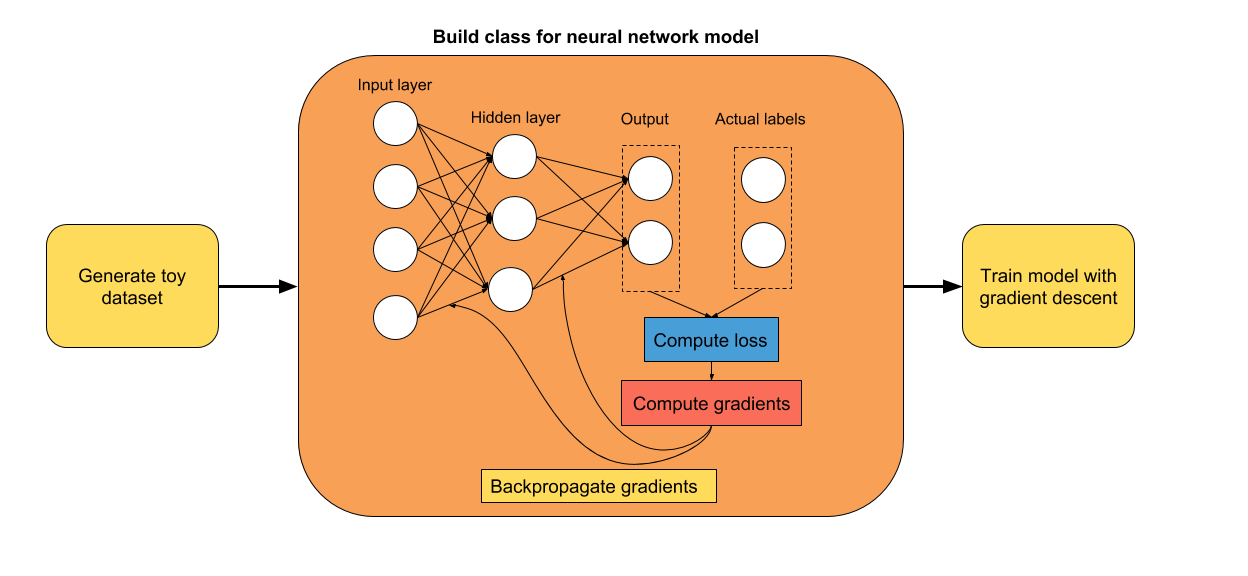

## 第四步:構建單隱層神經網絡(線性 -> ReLU -> 線性輸出)

我們的第一個試驗是一個簡單的神經網絡,只有一個隱層。 使用 TensorFlow Eager 構建神經網絡模型的最簡單方法是使用類。 在初始化期間,你可以定義執行模型正向傳播所需的層。

由于這是一個分類問題,我們將使用`softmax`交叉熵損失。 通常,我們必須對標簽進行單熱編碼。 為避免這種情況,我們將使用稀疏`softmax`損失,它以原始標簽作為輸入。 無需進一步處理!

```py

class simple_nn(tf.keras.Model):

def __init__(self):

super(simple_nn, self).__init__()

""" 在這里定義正向傳播期間

使用的神經網絡層

"""

# 隱層

self.dense_layer = tf.layers.Dense(10, activation=tf.nn.relu)

# 輸出層,無激活函數

self.output_layer = tf.layers.Dense(2, activation=None)

def predict(self, input_data):

""" 在神經網絡上執行正向傳播

Args:

input_data: 2D tensor of shape (n_samples, n_features).

Returns:

logits: unnormalized predictions.

"""

hidden_activations = self.dense_layer(input_data)

logits = self.output_layer(hidden_activations)

return logits

def loss_fn(self, input_data, target):

""" 定義訓練期間使用的損失函數

"""

logits = self.predict(input_data)

loss = tf.losses.sparse_softmax_cross_entropy(labels=target, logits=logits)

return loss

def grads_fn(self, input_data, target):

""" 在每個正向步驟中,

動態計算損失值對模型參數的梯度

"""

with tfe.GradientTape() as tape:

loss = self.loss_fn(input_data, target)

return tape.gradient(loss, self.variables)

def fit(self, input_data, target, optimizer, num_epochs=500, verbose=50):

""" 用于訓練模型的函數,

使用所選的優化器,執行所需數量的迭代

"""

for i in range(num_epochs):

grads = self.grads_fn(input_data, target)

```

## 第五步:使用梯度下降訓練模型

使用反向傳播來訓練我們模型的變量。 隨意玩玩學習率和迭代數。

```py

X_tensor = tf.constant(X)

y_tensor = tf.constant(y)

optimizer = tf.train.GradientDescentOptimizer(5e-1)

model = simple_nn()

model.fit(X_tensor, y_tensor, optimizer, num_epochs=500, verbose=50)

optimizer.apply_gradients(zip(grads, self.variables))

if (i==0) | ((i+1)%verbose==0):

print('Loss at epoch %d: %f' %(i+1, self.loss_fn(input_data, target).numpy()))

'''

Loss at epoch 1: 0.653288

Loss at epoch 50: 0.283921

Loss at epoch 100: 0.260529

Loss at epoch 150: 0.244092

Loss at epoch 200: 0.221653

Loss at epoch 250: 0.186211

Loss at epoch 300: 0.139418

Loss at epoch 350: 0.103654

Loss at epoch 400: 0.078874

Loss at epoch 450: 0.062550

Loss at epoch 500: 0.051096

'''

```

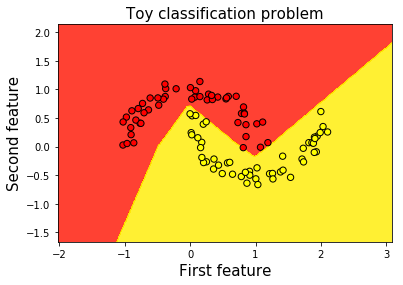

## 第六步:繪制決策邊界

用于繪制模型決策邊界的代碼受到[本教程](http://scikit-learn.org/stable/auto_examples/svm/plot_iris.html#sphx-glr-auto-examples-svm-plot-iris-py)的啟發。

```py

# 創建 mesh ,在其中繪制

x_min, x_max = X[:, 0].min() - 1, X[:, 0].max() + 1

y_min, y_max = X[:, 1].min() - 1, X[:, 1].max() + 1

xx, yy = np.meshgrid(np.arange(x_min, x_max, 0.01),

np.arange(y_min, y_max, 0.01))

# 為每個樣本 xx, yy 預測標簽

Z = np.argmax(model.predict(tf.constant(np.c_[xx.ravel(), yy.ravel()])).numpy(), axis=1)

# 將結果放進彩色繪圖

Z = Z.reshape(xx.shape)

fig = plt.figure()

plt.contourf(xx, yy, Z, cmap=plt.cm.autumn, alpha=0.8)

# 繪制我們的訓練樣本

plt.scatter(X[:, 0], X[:, 1], c=y, s=40, cmap=plt.cm.autumn, edgecolors='k')

plt.xlim(xx.min(), xx.max())

plt.ylim(yy.min(), yy.max())

plt.xlabel('First feature', fontsize=15)

plt.ylabel('Second feature', fontsize=15)

plt.title('Toy classification problem', fontsize=15)

```

- TensorFlow 1.x 深度學習秘籍

- 零、前言

- 一、TensorFlow 簡介

- 二、回歸

- 三、神經網絡:感知器

- 四、卷積神經網絡

- 五、高級卷積神經網絡

- 六、循環神經網絡

- 七、無監督學習

- 八、自編碼器

- 九、強化學習

- 十、移動計算

- 十一、生成模型和 CapsNet

- 十二、分布式 TensorFlow 和云深度學習

- 十三、AutoML 和學習如何學習(元學習)

- 十四、TensorFlow 處理單元

- 使用 TensorFlow 構建機器學習項目中文版

- 一、探索和轉換數據

- 二、聚類

- 三、線性回歸

- 四、邏輯回歸

- 五、簡單的前饋神經網絡

- 六、卷積神經網絡

- 七、循環神經網絡和 LSTM

- 八、深度神經網絡

- 九、大規模運行模型 -- GPU 和服務

- 十、庫安裝和其他提示

- TensorFlow 深度學習中文第二版

- 一、人工神經網絡

- 二、TensorFlow v1.6 的新功能是什么?

- 三、實現前饋神經網絡

- 四、CNN 實戰

- 五、使用 TensorFlow 實現自編碼器

- 六、RNN 和梯度消失或爆炸問題

- 七、TensorFlow GPU 配置

- 八、TFLearn

- 九、使用協同過濾的電影推薦

- 十、OpenAI Gym

- TensorFlow 深度學習實戰指南中文版

- 一、入門

- 二、深度神經網絡

- 三、卷積神經網絡

- 四、循環神經網絡介紹

- 五、總結

- 精通 TensorFlow 1.x

- 一、TensorFlow 101

- 二、TensorFlow 的高級庫

- 三、Keras 101

- 四、TensorFlow 中的經典機器學習

- 五、TensorFlow 和 Keras 中的神經網絡和 MLP

- 六、TensorFlow 和 Keras 中的 RNN

- 七、TensorFlow 和 Keras 中的用于時間序列數據的 RNN

- 八、TensorFlow 和 Keras 中的用于文本數據的 RNN

- 九、TensorFlow 和 Keras 中的 CNN

- 十、TensorFlow 和 Keras 中的自編碼器

- 十一、TF 服務:生產中的 TensorFlow 模型

- 十二、遷移學習和預訓練模型

- 十三、深度強化學習

- 十四、生成對抗網絡

- 十五、TensorFlow 集群的分布式模型

- 十六、移動和嵌入式平臺上的 TensorFlow 模型

- 十七、R 中的 TensorFlow 和 Keras

- 十八、調試 TensorFlow 模型

- 十九、張量處理單元

- TensorFlow 機器學習秘籍中文第二版

- 一、TensorFlow 入門

- 二、TensorFlow 的方式

- 三、線性回歸

- 四、支持向量機

- 五、最近鄰方法

- 六、神經網絡

- 七、自然語言處理

- 八、卷積神經網絡

- 九、循環神經網絡

- 十、將 TensorFlow 投入生產

- 十一、更多 TensorFlow

- 與 TensorFlow 的初次接觸

- 前言

- 1.?TensorFlow 基礎知識

- 2. TensorFlow 中的線性回歸

- 3. TensorFlow 中的聚類

- 4. TensorFlow 中的單層神經網絡

- 5. TensorFlow 中的多層神經網絡

- 6. 并行

- 后記

- TensorFlow 學習指南

- 一、基礎

- 二、線性模型

- 三、學習

- 四、分布式

- TensorFlow Rager 教程

- 一、如何使用 TensorFlow Eager 構建簡單的神經網絡

- 二、在 Eager 模式中使用指標

- 三、如何保存和恢復訓練模型

- 四、文本序列到 TFRecords

- 五、如何將原始圖片數據轉換為 TFRecords

- 六、如何使用 TensorFlow Eager 從 TFRecords 批量讀取數據

- 七、使用 TensorFlow Eager 構建用于情感識別的卷積神經網絡(CNN)

- 八、用于 TensorFlow Eager 序列分類的動態循壞神經網絡

- 九、用于 TensorFlow Eager 時間序列回歸的遞歸神經網絡

- TensorFlow 高效編程

- 圖嵌入綜述:問題,技術與應用

- 一、引言

- 三、圖嵌入的問題設定

- 四、圖嵌入技術

- 基于邊重構的優化問題

- 應用

- 基于深度學習的推薦系統:綜述和新視角

- 引言

- 基于深度學習的推薦:最先進的技術

- 基于卷積神經網絡的推薦

- 關于卷積神經網絡我們理解了什么

- 第1章概論

- 第2章多層網絡

- 2.1.4生成對抗網絡

- 2.2.1最近ConvNets演變中的關鍵架構

- 2.2.2走向ConvNet不變性

- 2.3時空卷積網絡

- 第3章了解ConvNets構建塊

- 3.2整改

- 3.3規范化

- 3.4匯集

- 第四章現狀

- 4.2打開問題

- 參考

- 機器學習超級復習筆記

- Python 遷移學習實用指南

- 零、前言

- 一、機器學習基礎

- 二、深度學習基礎

- 三、了解深度學習架構

- 四、遷移學習基礎

- 五、釋放遷移學習的力量

- 六、圖像識別與分類

- 七、文本文件分類

- 八、音頻事件識別與分類

- 九、DeepDream

- 十、自動圖像字幕生成器

- 十一、圖像著色

- 面向計算機視覺的深度學習

- 零、前言

- 一、入門

- 二、圖像分類

- 三、圖像檢索

- 四、對象檢測

- 五、語義分割

- 六、相似性學習

- 七、圖像字幕

- 八、生成模型

- 九、視頻分類

- 十、部署

- 深度學習快速參考

- 零、前言

- 一、深度學習的基礎

- 二、使用深度學習解決回歸問題

- 三、使用 TensorBoard 監控網絡訓練

- 四、使用深度學習解決二分類問題

- 五、使用 Keras 解決多分類問題

- 六、超參數優化

- 七、從頭開始訓練 CNN

- 八、將預訓練的 CNN 用于遷移學習

- 九、從頭開始訓練 RNN

- 十、使用詞嵌入從頭開始訓練 LSTM

- 十一、訓練 Seq2Seq 模型

- 十二、深度強化學習

- 十三、生成對抗網絡

- TensorFlow 2.0 快速入門指南

- 零、前言

- 第 1 部分:TensorFlow 2.00 Alpha 簡介

- 一、TensorFlow 2 簡介

- 二、Keras:TensorFlow 2 的高級 API

- 三、TensorFlow 2 和 ANN 技術

- 第 2 部分:TensorFlow 2.00 Alpha 中的監督和無監督學習

- 四、TensorFlow 2 和監督機器學習

- 五、TensorFlow 2 和無監督學習

- 第 3 部分:TensorFlow 2.00 Alpha 的神經網絡應用

- 六、使用 TensorFlow 2 識別圖像

- 七、TensorFlow 2 和神經風格遷移

- 八、TensorFlow 2 和循環神經網絡

- 九、TensorFlow 估計器和 TensorFlow HUB

- 十、從 tf1.12 轉換為 tf2

- TensorFlow 入門

- 零、前言

- 一、TensorFlow 基本概念

- 二、TensorFlow 數學運算

- 三、機器學習入門

- 四、神經網絡簡介

- 五、深度學習

- 六、TensorFlow GPU 編程和服務

- TensorFlow 卷積神經網絡實用指南

- 零、前言

- 一、TensorFlow 的設置和介紹

- 二、深度學習和卷積神經網絡

- 三、TensorFlow 中的圖像分類

- 四、目標檢測與分割

- 五、VGG,Inception,ResNet 和 MobileNets

- 六、自編碼器,變分自編碼器和生成對抗網絡

- 七、遷移學習

- 八、機器學習最佳實踐和故障排除

- 九、大規模訓練

- 十、參考文獻